MEV Workshop : une conférence de 8 heures résumée en 81 minutes

Résumé du MEV Workshop à l'édition 2023 de Science of Blockchain Conference

L'ordre équitable est erroné

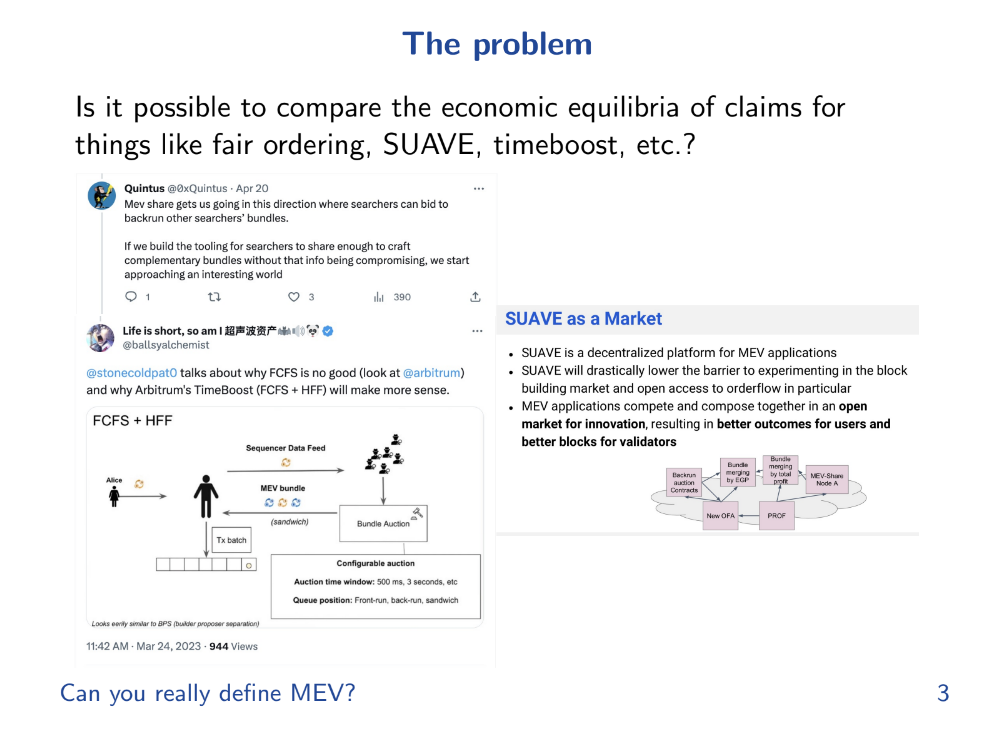

Cette présentation a été inspirée par un certain nombre d'événements survenus en février dernier ou par les travaux d'autres personnes.

Beaucoup de gens ont examiné l'ordre (ou l'ordonnancement) des transactions et la façon de mettre en œuvre un ordre équitable, qui signifie généralement des mécanismes de type Premier entré, premier sorti (FIFO), également connu sous le nom Premier arrivé, premier servi (FCFS).

Le FIFO/FCFS traite les transactions uniquement sur la base du moment où elles arrivent, sans tenir compte de facteurs comme les frais de transaction ou la priorité.

Solana et Arbitrum utilisent FIFO/FCFS en production, nous pouvons donc voir ce qui se passe avec ce mécanisme d'ordonnancement

Solana (1:15)

Solana sans Jito utilise effectivement quelque chose ressemblant à un FIFO, et les frais sont négligeables. Le problème est que, étant donné que c'est la première transaction, son utilité est très élevée et seule une seule personne peut l'obtenir.

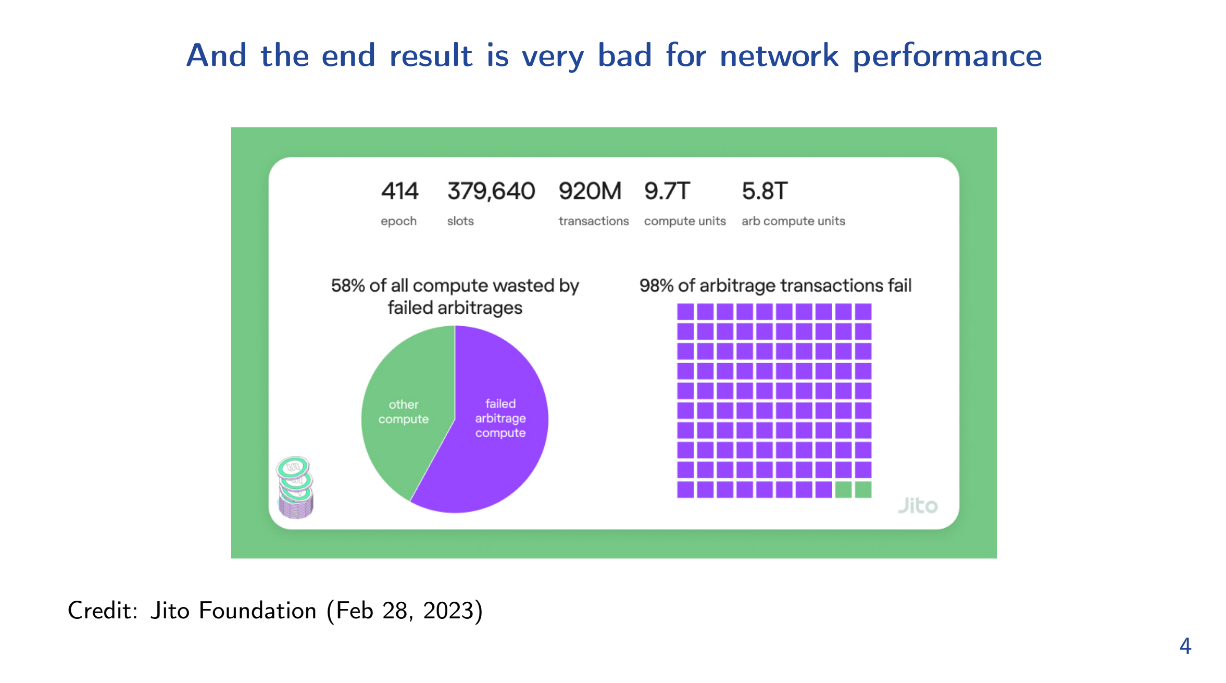

Par conséquent, les Searchers (chercheurs de bloc) vont spammer le réseau, dans le but d'être la première transaction. Et cela nuit aux autres utilisateurs et validateurs, avec 58% de puissance de calcul gaspillée et 98% des transactions d'arbitrage échouées.

Arbitrum (2:30)

Le séquenceur FIFO d'Arbitrum a également conduit à du spam. Le réseau a fini par avoir 150 000 connexions WebSocket et ce n'était pas viable.

Abritrum a proposé une solution appelée "hashcash", mais elle était controversée car il s'agissait d'une preuve de travail (Proof-of-Work). Maintenant, ils passent à des frais de priorité à la place.

Conclusion (3:30)

L'ordonnancement FIFO déforme le marché de l'espace de bloc en forçant les utilisateurs réguliers à supporter les coûts des externalités comme le spam d'arbitrage.

Nous avons besoin d'un marché pour allouer efficacement l'espace de bloc.

Un marché pour l'espace de bloc

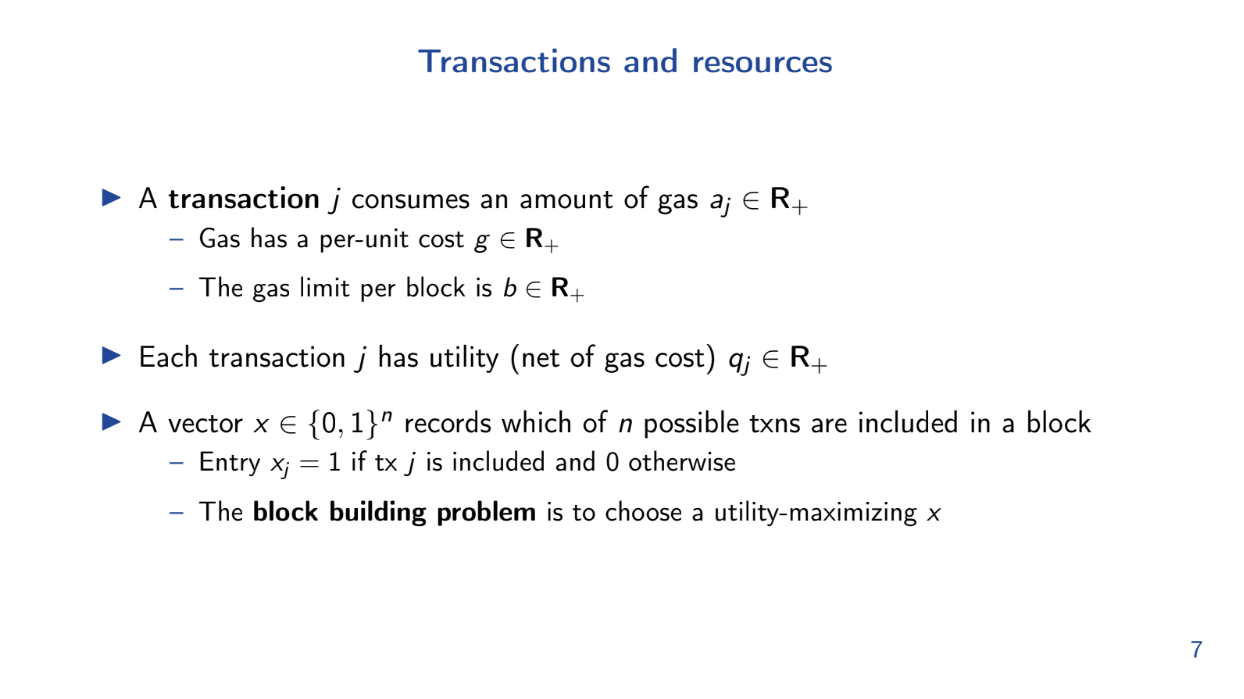

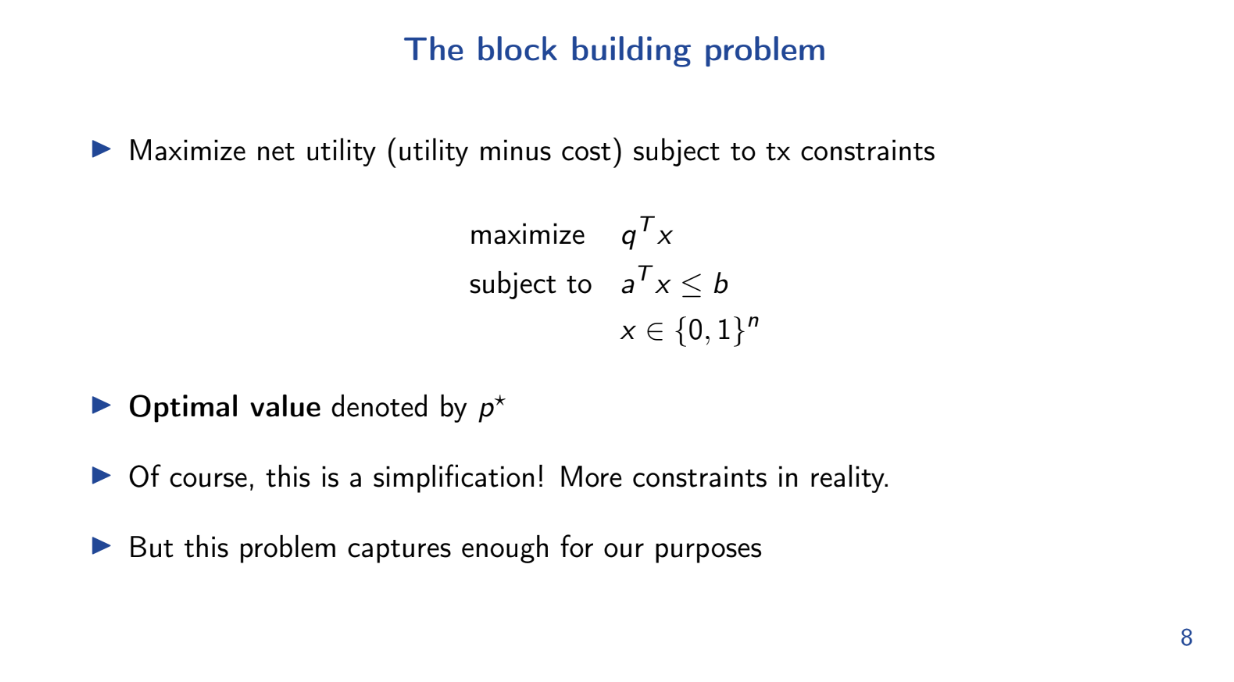

Le modèle mathématique (3:45)

Theo présente une formule du problème de construction de bloc comme un modèle d'optimisation.

Plus précisément, il s'agit d'un problème du sac à dos, où nous devons maximiser l'utilité nette de nos transactions avec des limites de gas.

Ce modèle est une simplification, mais il schématise suffisamment le problème

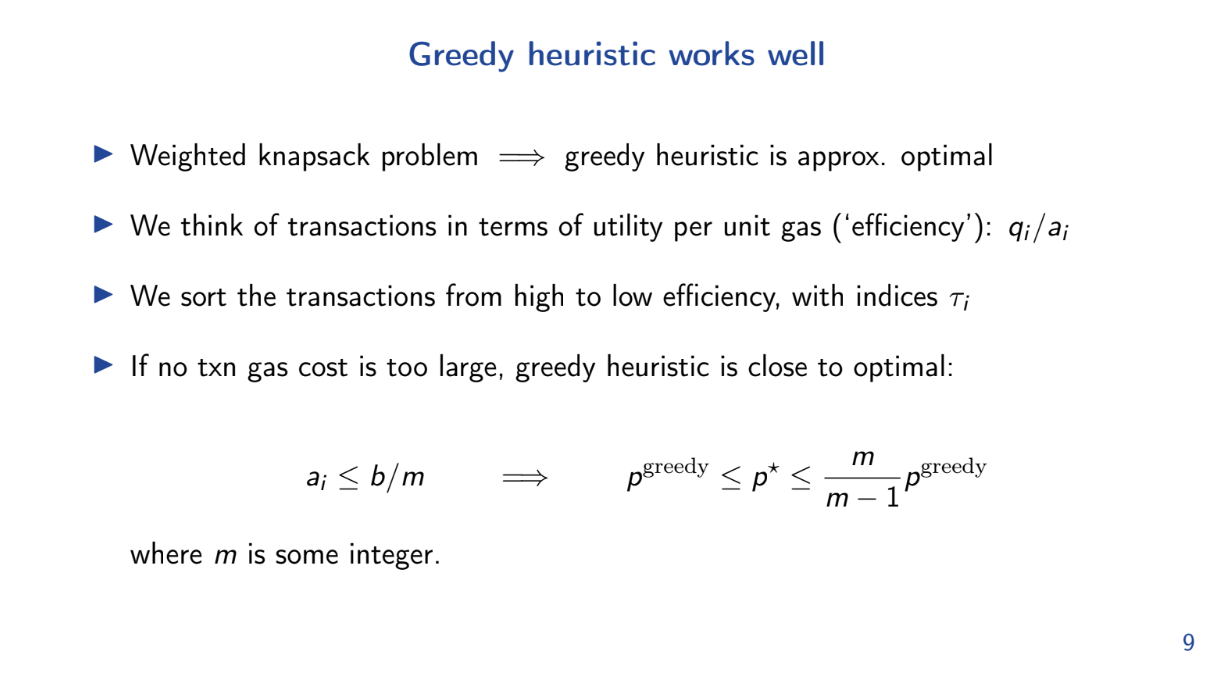

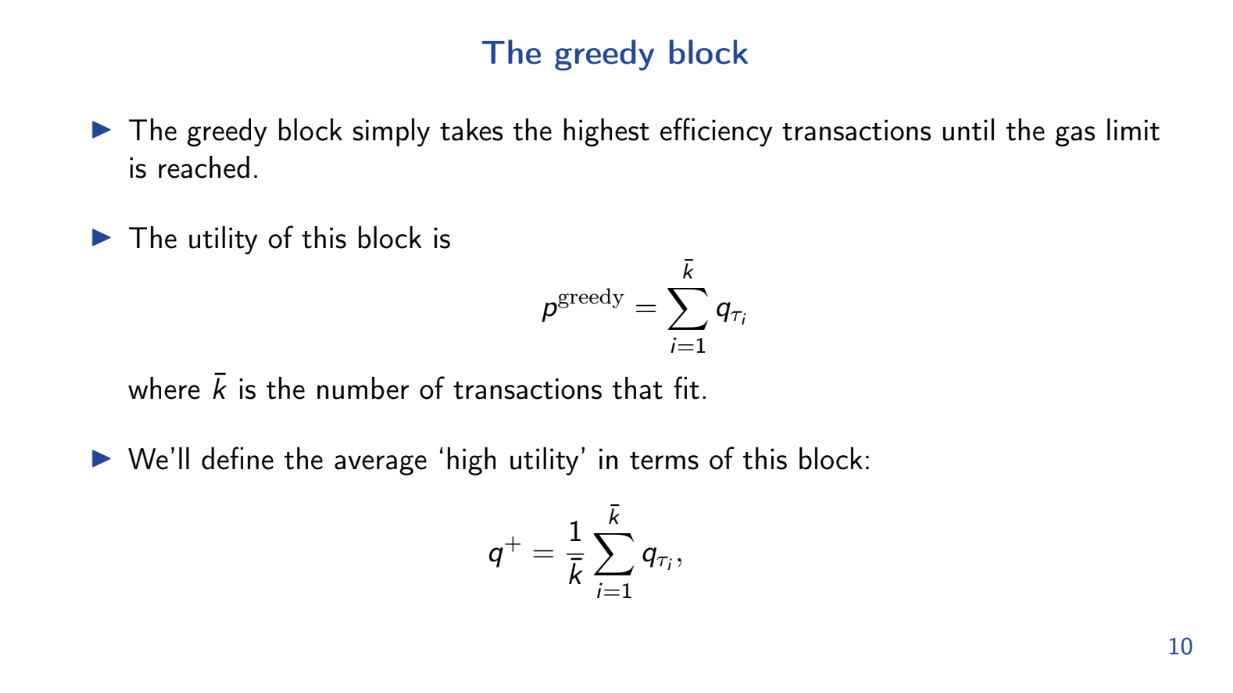

L'heuristique gloutonne fonctionne bien (6:00)

Strictement parlant, si le coût du gaz par unité de transaction n'est pas trop proche de la limite, cela signifie que nous pouvons insérer beaucoup de transactions dans le bloc.

Le modèle montre que l'algorithme glouton qui prend les transactions d'utilité/gaz les plus élevées en premier est presque optimal pour ce problème.

Bien que déclaré implicitement, le modèle démontre que la maximisation de l'utilité surpasse des ordonnancements plus simples comme FIFO pour la construction de blocs.

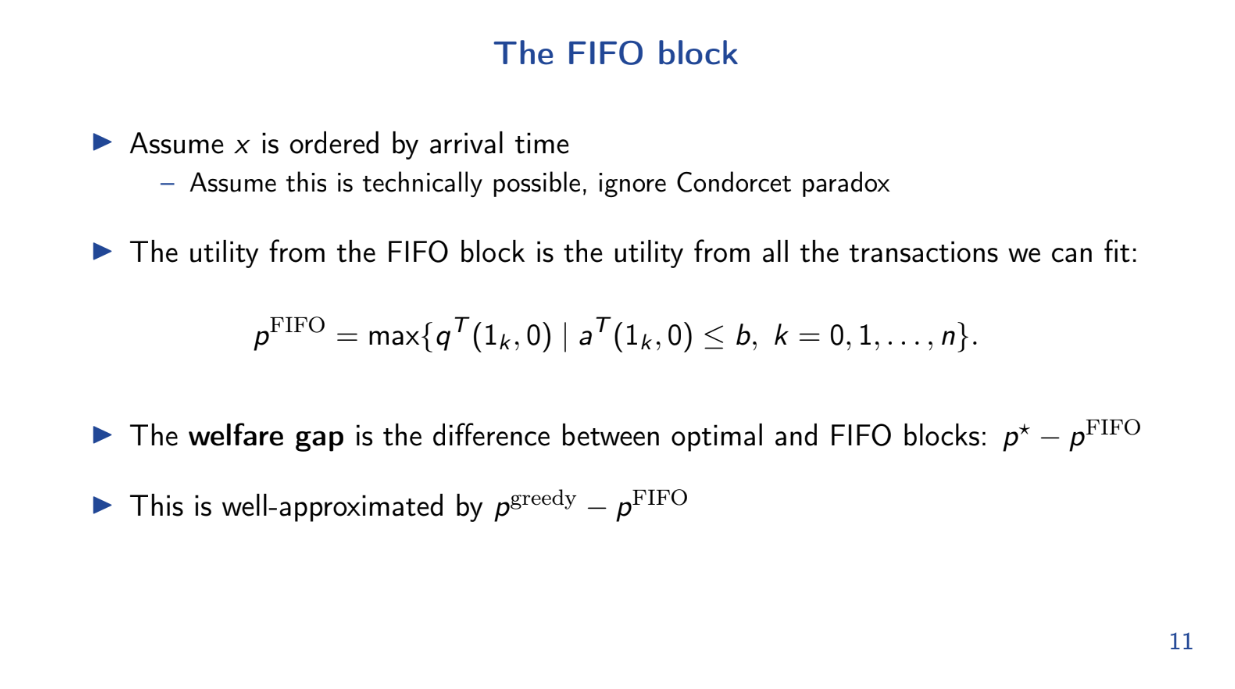

Le bloc FIFO (8:30)

Theo analyse comment un bloc de premier entré, premier sorti (FIFO) se comporte par rapport à un bloc optimal maximisant l'utilité.

Le bloc FIFO est assez simple : les transactions sont ordonnées par heure d'arrivée et ajoutées jusqu'à ce que le bloc soit plein. Nous supposons un ordre d'arrivée aléatoire.

Avec l'hypothèse d'arrivée aléatoire, il est facile de calculer une borne supérieure sur l'utilité totale attendue du bloc FIFO.

Calcul de "l'écart de prospérité"

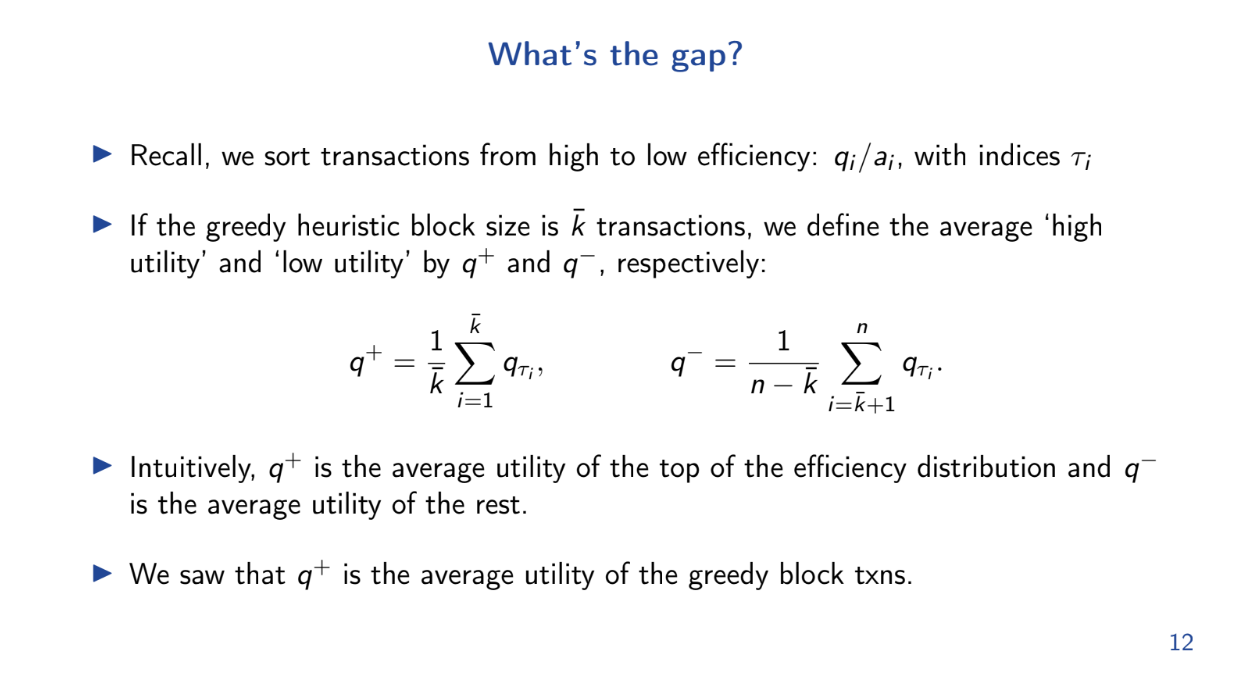

C'est quoi l'écart ? (9:30)

Écart de prospérité = utilité du bloc optimal - utilité attendue du bloc FIFO. Le but est de montrer que cet écart est significatif

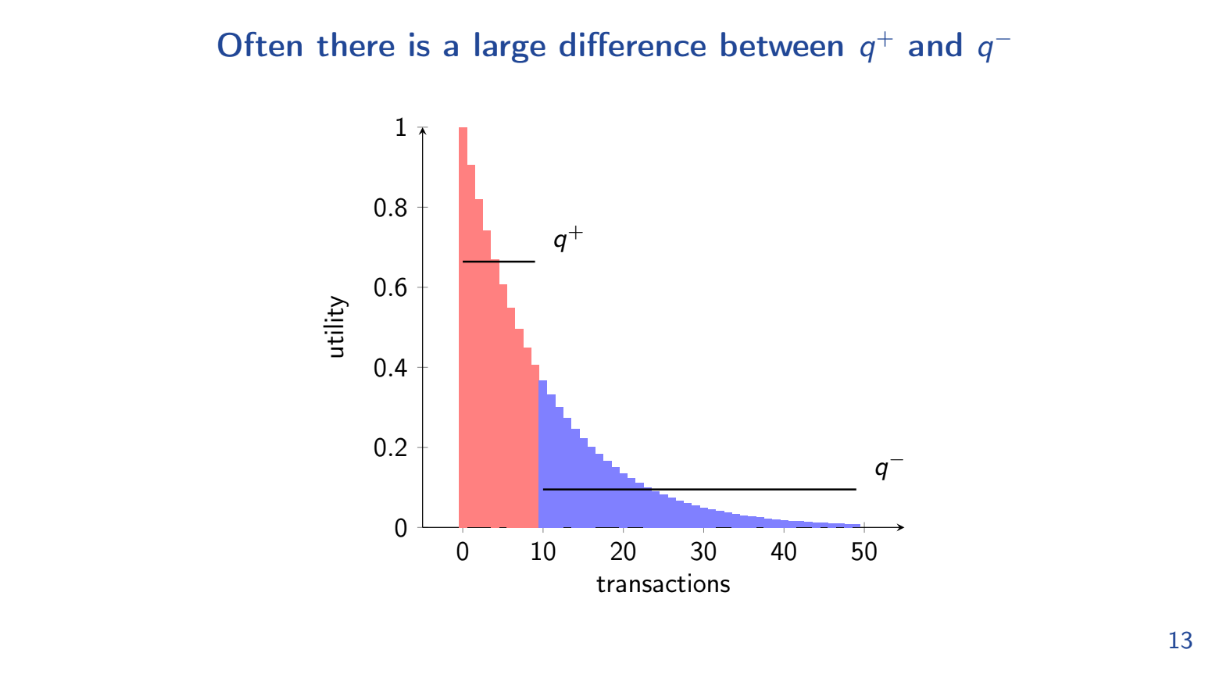

En utilisant les résultats précédents, nous pouvons fixer l'utilité du bloc glouton optimal à une borne inférieure. Nous pouvons donc maintenant borner supérieurement l'écart de bien-être en utilisant 2 limites :

- q+ est l'utilité moyenne par unité de gaz pour les transactions du bloc glouton optimal

- q- est la moyenne pour les transactions restantes.

L'écart est positif chaque fois que q+ > q- même d'une petite quantité. Intuitivement, chaque fois qu'il y a des transactions à très haute utilité, l'écart sera positif et le bloc FIFO se comporte moins bien que le bloc optimal.

En pratique, l'écart est fréquemment positif car les transactions à plus haute utilité (comme les liquidations) sont choisies en premier pour le bloc optimal. En conséquence, FIFO est sous-optimal.

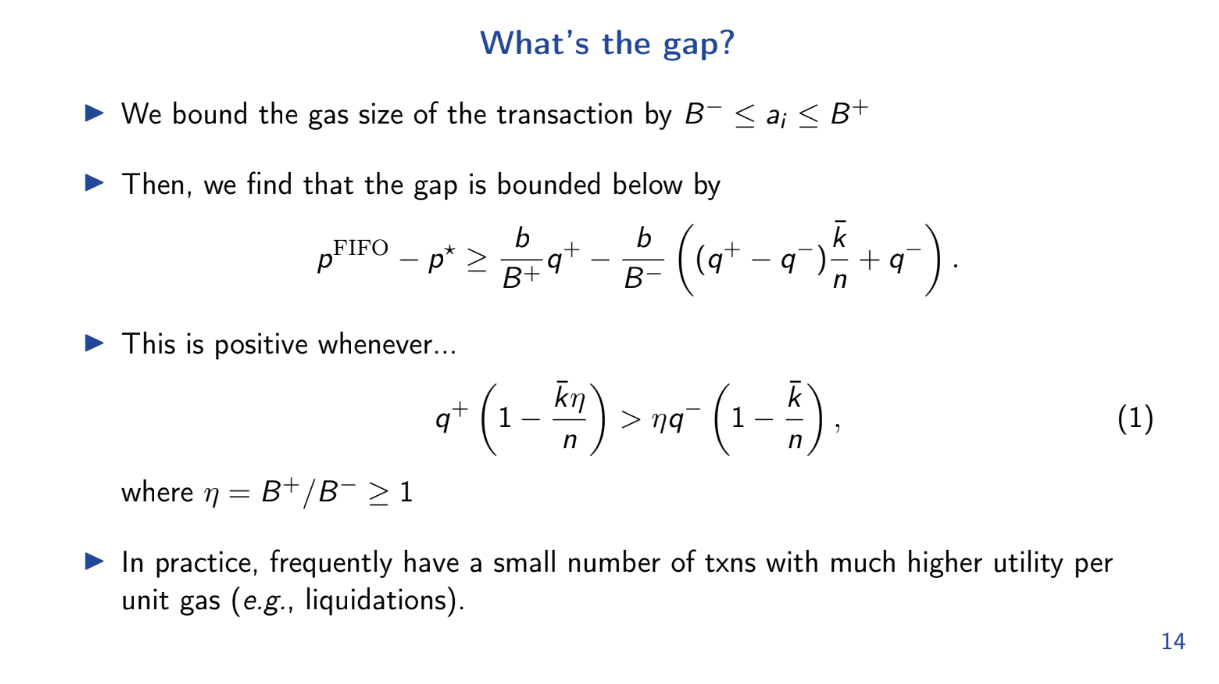

Une limite plus imple (11:45)

Essayons une autre formule pour calculer l'"écart de prospérité" entre le bloc optimal et le bloc FIFO :

q+ > (B+ / B-) q-

- Q+ est l'utilité moyenne par gaz pour le bloc optimal

- B+ est la taille maximale de transaction

- B- est la taille minimale de transaction

- Q- est l'utilité moyenne par gaz pour les transactions restantes

Donc à chaque fois que l'équation ci-dessus est vraie, le bloc FIFO se comporte moins bien qu'optimal.

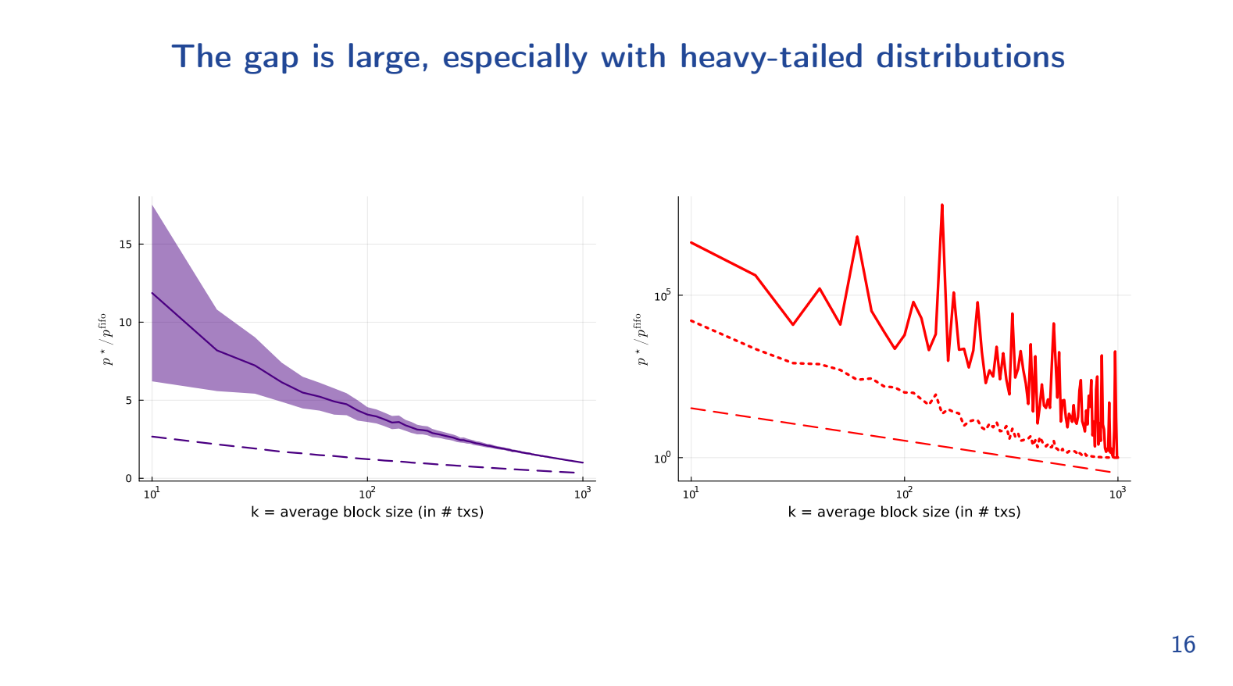

Avec une distribution à décroissance rapide, le bloc FIFO a une utilité 2 à 3 fois inférieure à l'optimal, même pour des blocs de grande taille.

Avec une distribution de longue traîne (quelques txs à très haute utilité), l'écart est de l'ordre de x100 000 (x10^5), ce qui est énorme !

Cela engendre des spammeurs qui inondent le réseau pour essayer d'obtenir ces transactions à haute utilité en premier sous FIFO, et c'est pas optimal.

Quoi faire ? (14:30)

Même si vous pouviez mettre en œuvre des ordonnancements de type FIFO, il y aura un écart de prospérité et cela amène des utilisateurs bénins à payer les externalités.

Théo a décrit les problèmes, mais des solutions sont explorées :

- Une approche consiste à mieux caractériser la valeur du réordonnancement des transactions et à concevoir des mécanismes pour minimiser les coûts de la MEV.

- Rendre les applications indépendantes de l'ordre aide également, de sorte que l'ordre des transactions dans le bloc n'ait pas d'importance.

- La mise au point de meilleurs mécanismes d'enchères on-chain pour l'espace de bloc est prometteuse.

Beaucoup de gens (Flashbots, Arbitrum...) travaillent à la mise en œuvre d'ordonnancements qui ont des marchés sensibles pour l'espace de bloc, et certains exposés de cette conférence leur sont consacrés.

FAQ

Sur la base de l'analyse montrant les problèmes avec FIFO/blocs courts, les temps de bloc plus longs sont-ils plus efficaces ? (16:45)

Le modèle ne traite pas du temps de bloc optimal et ne peut rien conclure à ce sujet. Mais le bon côté est que ces résultats sont indépendants de cela.

Le modèle visait uniquement à montrer que FIFO pose problème d'un point de vue optimisation, indépendamment du temps de bloc.

Compte tenu de la diminution de l'utilité d'arbitrage si on attend plus longtemps, le fait de tenir compte de l'évolution de l'utilité des transactions au fil du temps affecterait-il l'analyse ? (19:00)

Le modèle n'en tient pas compte actuellement. Étendre le modèle pour tenir compte des utilités de transaction dynamiques serait une extension intéressante à l'avenir.

Mise en oeuvre des directives d'ordonnancement

Limitations et détournements

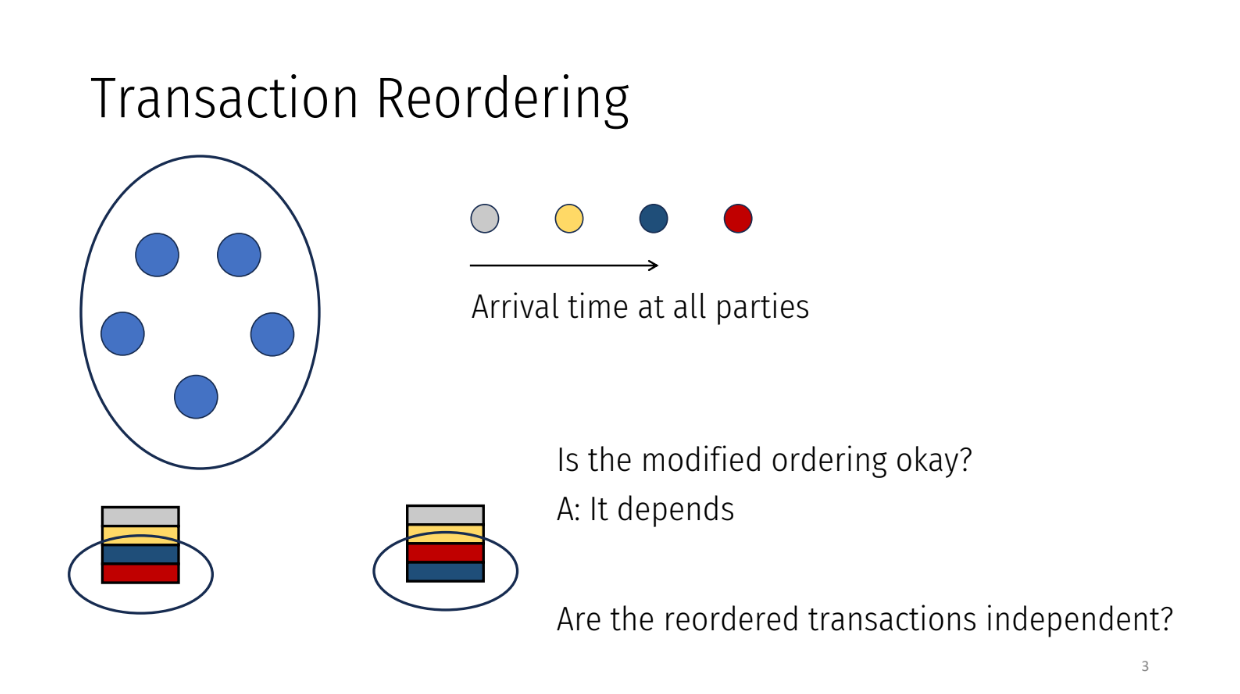

Réordonnancement des transactions

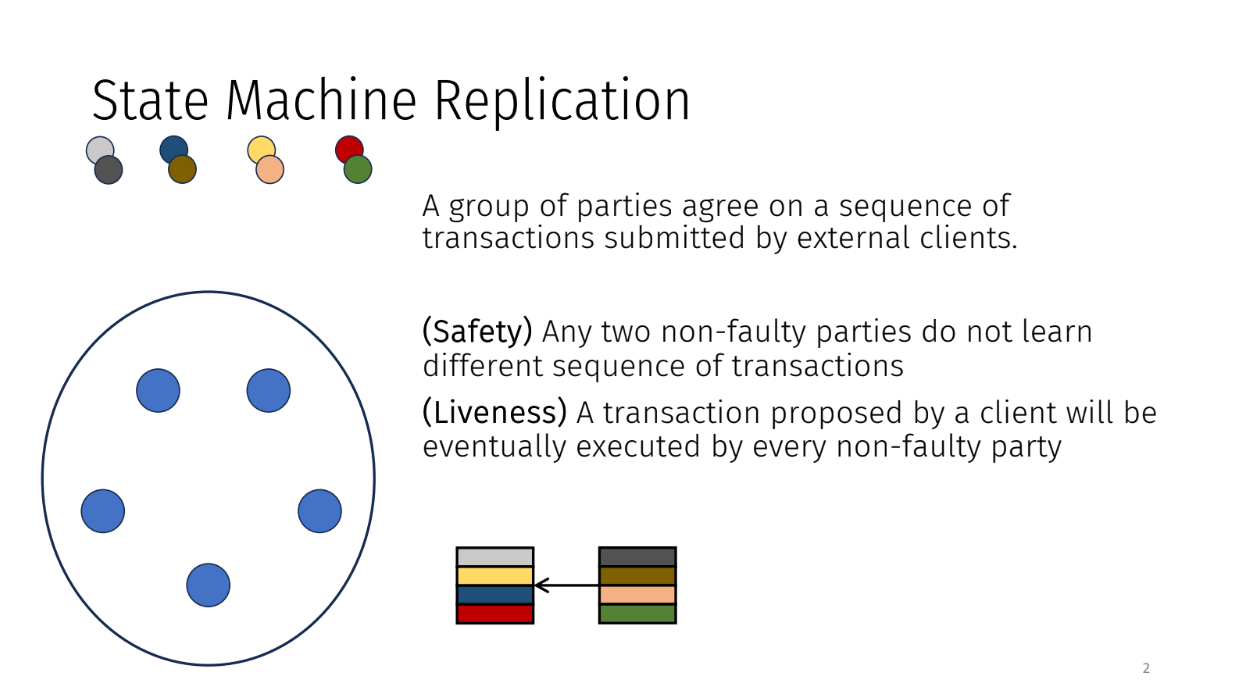

Le problème de la réplication de la machine d'état (0:00)

Le problème de la réplication de la machine d'état est celui où un groupe convient d'une séquence de transactions soumises par des clients externes. Il y a deux propriétés clés que nous recherchons :

- Sécurité : aucun désaccord sur l'ordre

- Disponibilité : les transactions sont finalement exécutées

Réordonnancement des transactions (1:00)

Les parties reçoivent des transactions une par une au fil du temps. Ils regroupent les transactions en blocs et conviennent d'un ordre pour traiter chaque bloc.

L'ordre doit correspondre à l'ordre d'arrivée des transactions dans le système. Par exemple, si une transaction grise est arrivée en premier, une transaction jaune en deuxième et une transaction bleue en troisième, alors l'ordre convenu doit être gris, jaune, bleu.

Cependant, les parties pourraient décider de modifier l'ordre pour une raison quelconque. Ils peuvent mettre une transaction arrivée plus tard (comme le rouge) avant une précédente (comme le bleu).

Le fait que cela soit correct ou équitable dépend de si les transactions sont liées ou non. Si deux transactions sont complètement indépendantes, changer l'ordre est probablement acceptable. Mais si elles sont liées, cela pose problème.

Réordonner les transactions est un problème connu avec des attaques connues. Mais il existe des approches pour empêcher la triche en appliquant des ordres qui correspondent au moment où les transactions sont arrivées. L'exposé traitera des solutions à ce problème.

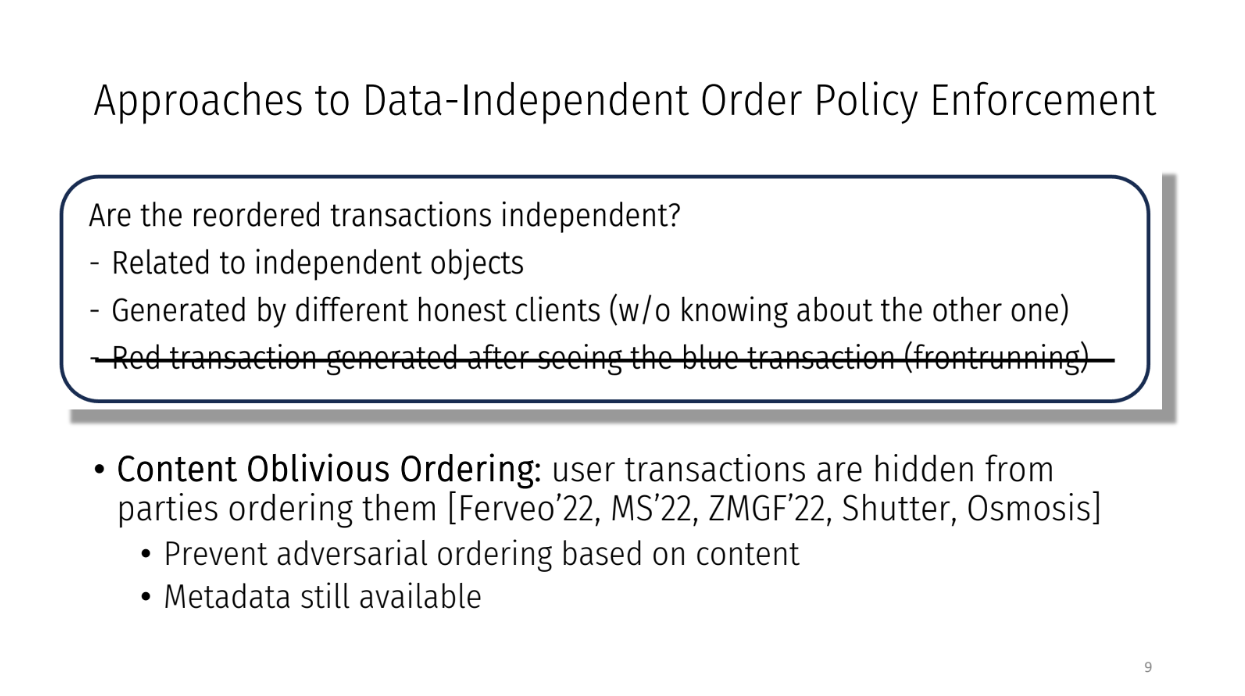

Approches d'application de l'ordonnancement indépendamment des données (3:15)

Les chercheurs ont essayé 2 approches pour s'assurer que les transactions soit ordonnées équitablement :

- "Équité de l'ordre" : cela commande les transactions uniquement en fonction du moment où elles arrivent dans le système. Ainsi, si la transaction A arrive avant la transaction B chez toutes les parties, A sera classée avant B. Cela empêche le réordonnancement injuste des transactions.

- "Séquençage sans connaissance du contenu" : le contenu de chaque transaction est caché aux parties qui les ordonnent. L'objectif est d'empêcher la triche en fonction du contenu des transactions. Les parties ne peuvent utiliser que des métadonnées comme l'heure d'arrivée pour commander les transactions.

Les deux tentent d'appliquer un ordonnancement équitable des transactions. Mais empêchent-ils complètement les attaques de réordonnancement injuste ?

Le problème est que les deux approches reposent sur le fait que la plupart des parties sont honnêtes. Mais la raison du réordonnancement injuste est que les parties veulent tricher pour un gain personnel.

Il y a une inadéquation entre le modèle de menace que ces protocoles supposent et les motivations réelles des attaques.

L'exposé d'aujourd'hui (6:00)

La question clé est de savoir si ces protocoles sont sécurisés lorsque toutes les parties prenantes sont des acteurs rationnels essayant de maximiser les profits personnels.

Dans cet exposé, Kartik se concentrera d'abord sur la réponse à cette question en analysant les protocoles existants d'équité de l'ordre lorsque toutes les parties sont rationnelles, puis en explorant une nouvelle approche appelée "Ordonnancement rationnel" (rational ordering) qui sécurise la commande contre les adversaires rationnels.

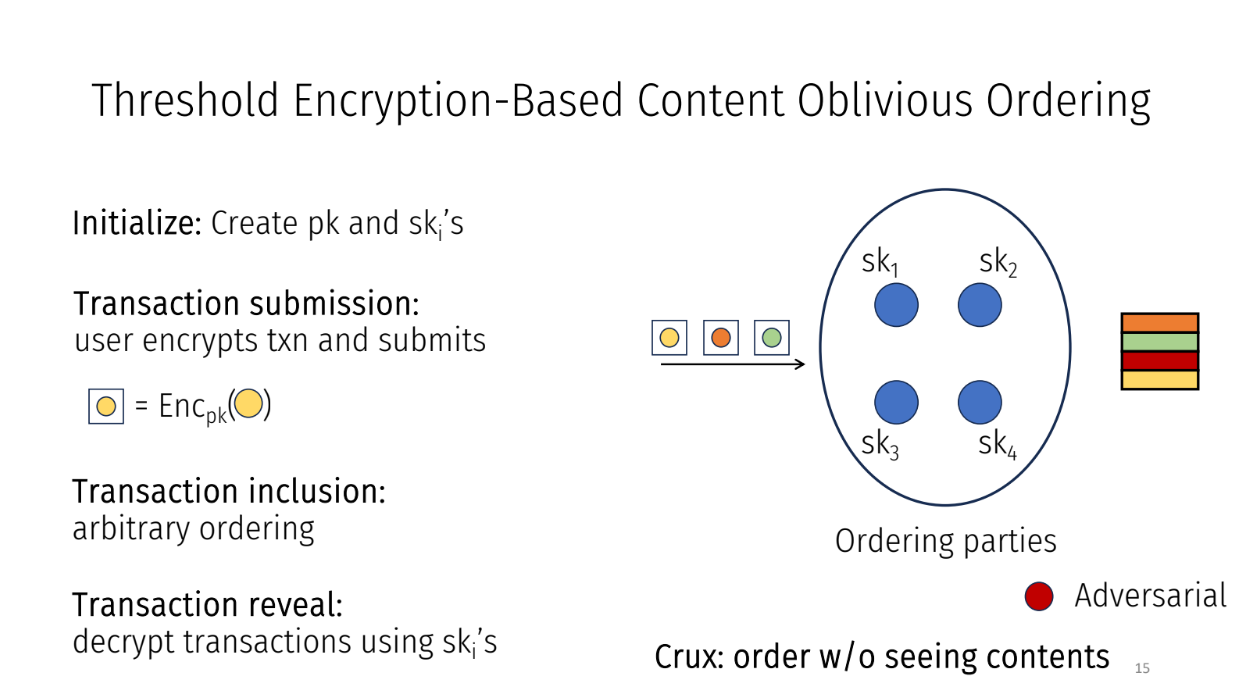

Créer le cadre

Kartik met en place un cadre qui capture différents protocoles pour ordonner équitablement les transactions dans un système. Ils utilisent un protocole spécifique appelé "Chiffrement de seuil sans connaissance du contenu" comme exemple

Le cadre fonctionne comme suit :

- Initialisation : générer une clé publique et des clés privées pour chaque partie du système

- Soumission de transaction : les utilisateurs chiffrent leurs transactions à l'aide de la clé publique et les soumettent

- Ordonnancement : les parties ordonnent les transactions chiffrées comme elles le souhaitent puisqu'elles ne peuvent pas voir le contenu

- Révélation : une fois triées, les parties déchiffrent les transactions à l'aide de leurs clés secrètes

L'idée est que les parties prenantes ne peuvent pas ordonner injustement les transactions puisqu'elles ne connaissent pas le contenu lorsqu'elles les ordonnent. Même si une mauvaise transaction est arrivée plus tôt, peu importe puisque les contenus étaient masqués.

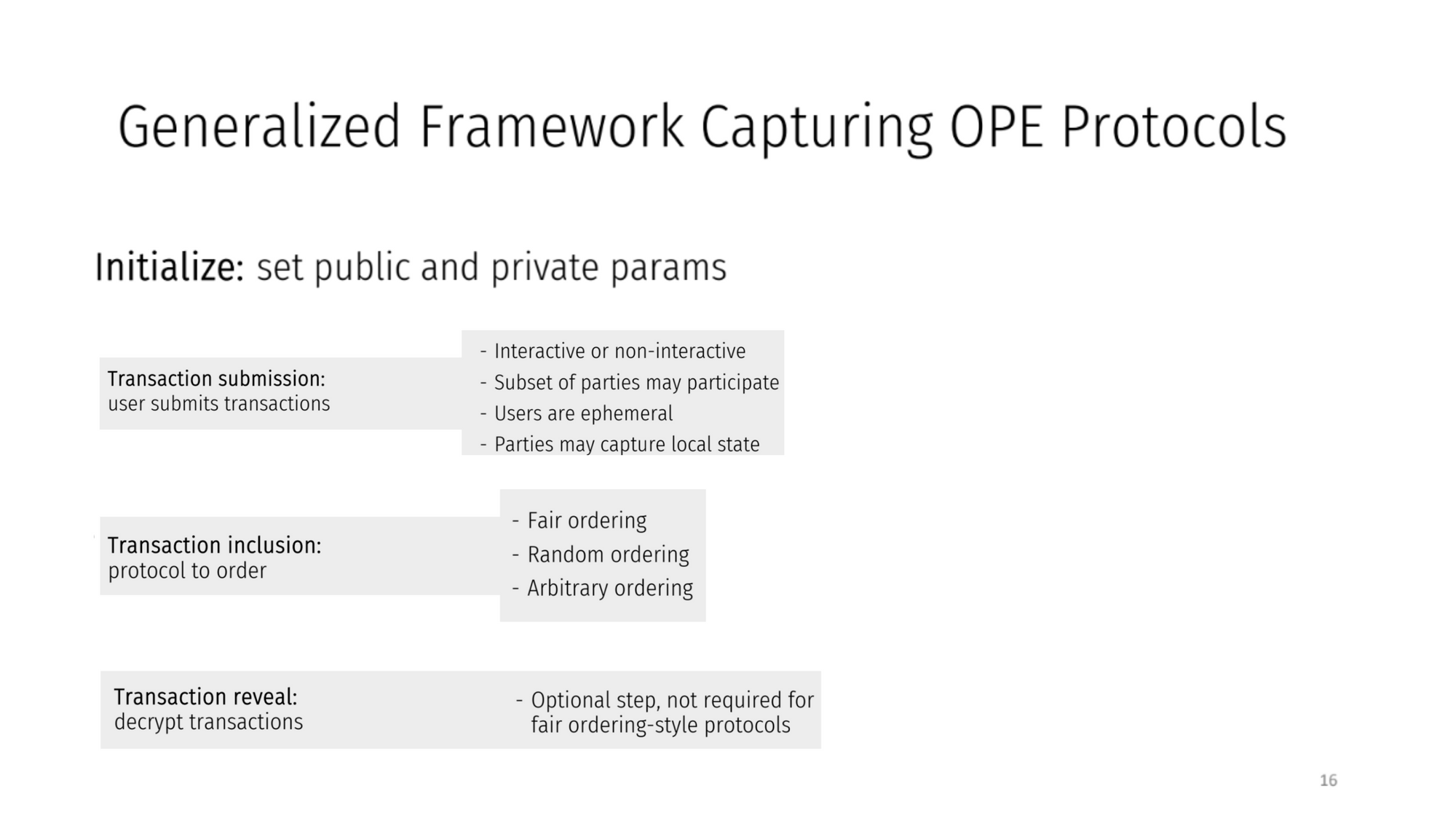

Cadre généralisé capturant les protocoles OPE (8:00)

En général, les protocoles de ce cadre ont :

- Initialisation avec des paramètres publics/privés

- Les utilisateurs soumettent des transactions

- Les parties capturent des métadonnées comme les temps d'arrivée des transactions

- Les transactions sont classées en fonction des métadonnées

- Révélation facultative des contenus après classement

- Une propriété de liaison qui indique qu'une transaction exécutée par le protocole est celle qui lui est soumise.

- Nous supposons qu'entre après le classement et avant la révélation, l'état de la transaction ne change pas

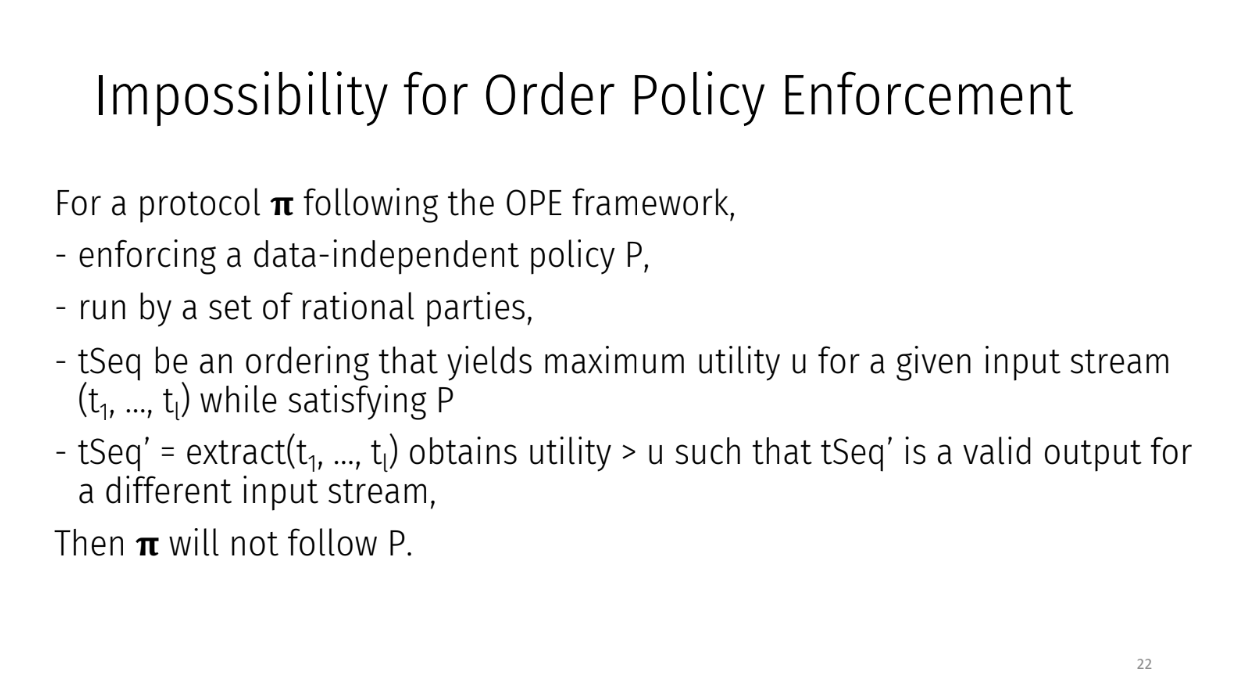

Impossibilité d'appliquer la politique de commande

Explication (10:30)

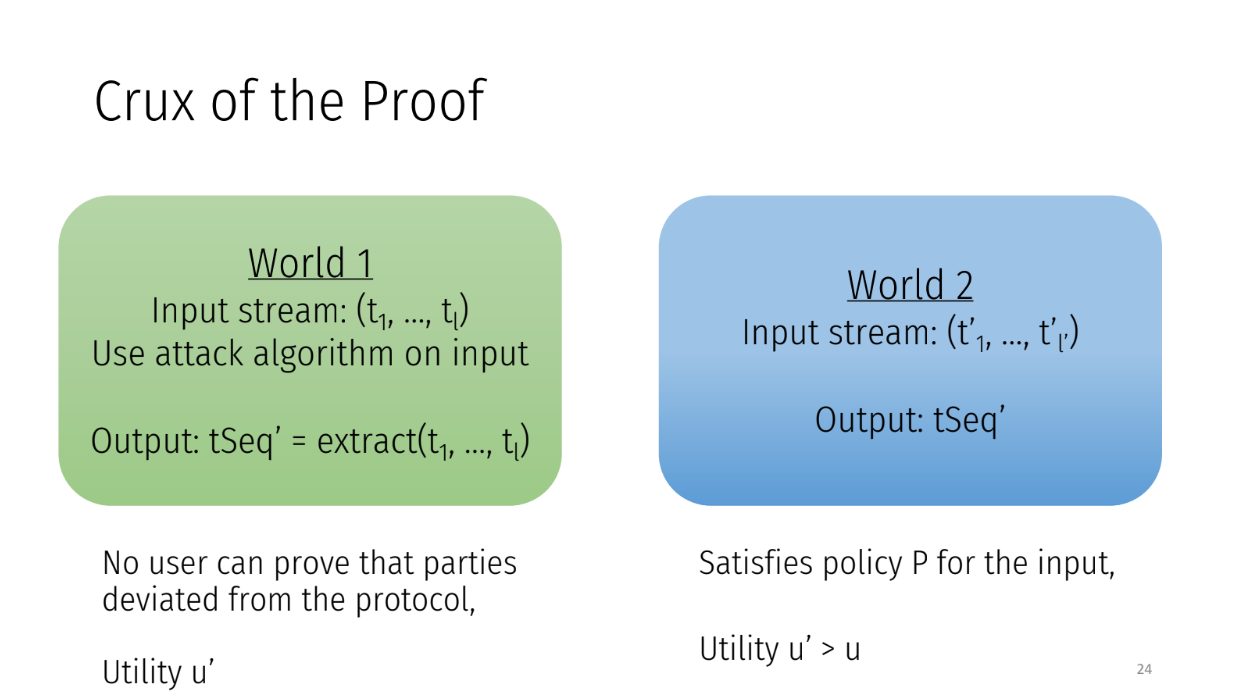

Pour les protocoles de ce cadre, s'il existe un moyen pour les parties de réordonner les transactions et de gagner plus de profits, elles le feront.

Disons que l'ordre d'origine des transactions est t1, t2, ..., tl. Et pour cet ordre, la séquence tSeq donne aux parties le profit maximum u.

Ensuite, les parties produiront tSeq à la place de suivre l'ordonnancement P. Ils manipuleront l'ordre s'ils peuvent en tirer plus de profits.

L'attaque fonctionne ainsi :

- Les parties prenantes révèlent toutes les transactions

- Exécuter des fonctions d'extraction pour maximiser les bénéfices

- Rejouer les transactions dans un ordre différent TSEC'

- Publier le nouvel état avec des bénéfices plus élevés

Cela donne l'impression qu'un flux d'entrée différent a été soumis. Par conséquent, personne ne peut prouver que l'attaque a eu lieu. Donc, les parties rationnelles attaqueront les protocoles de ce cadre si un réordonnancement rentable existe.

Comment l'équité de l'ordre peut-elle être réalisée lorsque les parties sont rationnelles ? C'est la prochaine partie de l'exposé.

Contourner l'impossibilité

Les deux approches (13:30)

- Obliger les clients à rester en ligne jusqu'à ce que leur transaction soit validée. Cela empêche les attaques car les parties ne peuvent pas voir le contenu avant le séquençage.

- Relâcher la propriété de liaison : permettre que la transaction exécutée diffère de celle soumise, tant que les acteurs rationnels suivent toujours le comportement correct.

En réalité, garder les clients en ligne est compliqué. Une meilleure approche consiste à assouplir la liaison.

Par exemple, disons qu'un client soumet une transaction "acheter 50 tokens". La transaction exécutée pourrait être "vendre 50 tokens" à la place. C'est problématique, mais si les acteurs rationnels suivent toujours le comportement correct, la liaison ne doit tenir que pour elles. C'est la "liaison rationnelle".

À partir de cela, nous pouvons créer un protocole utilisant la liaison rationnelle qui empêche les "attaques sandwich" dans certaines applications comme les Automated Market Makers (AMMs).

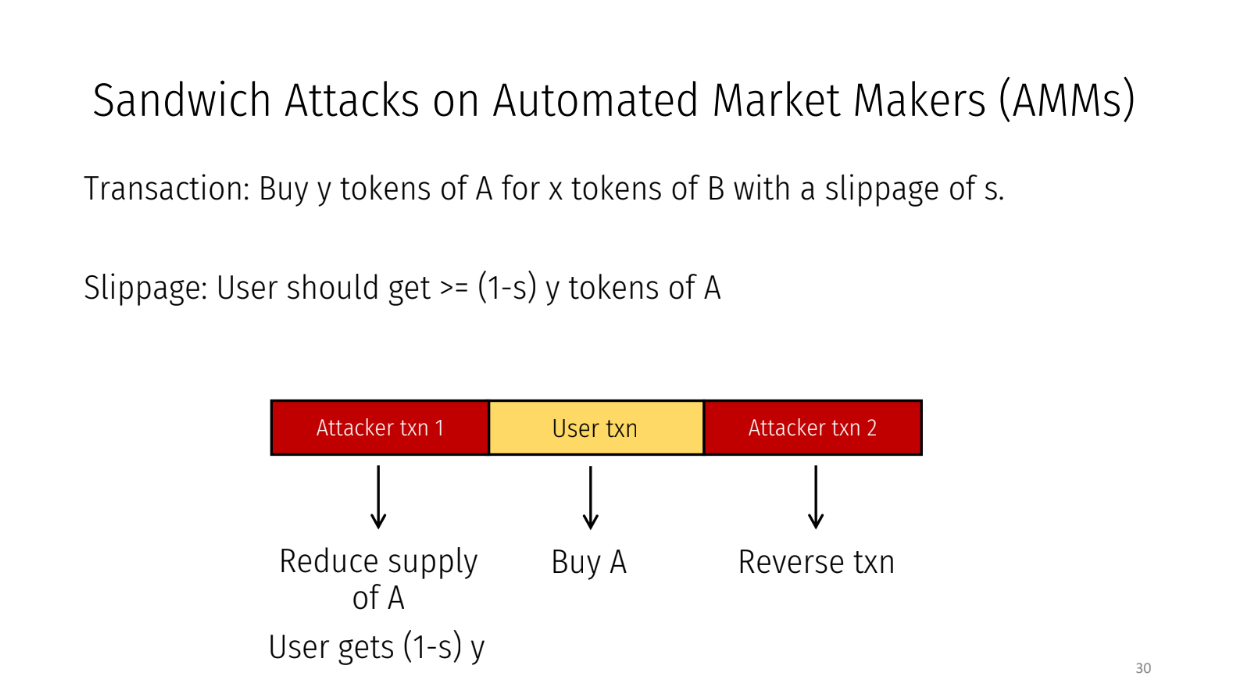

Attaques sandwich sur les AMMs (16:00)

Dans un AMM, nous échangeons un token contre un autre :

- Le taux de change dépend de la disponibilité des tokens

- Un utilisateur soumet une transaction comme "Acheter Y tokens de A pour X tokens de B"

- Il y a un slippage S pour permettre les changements de taux

Les attaques se font en effectuant des transactions avant et après la transaction de l'utilisateur. Cela réduit la disponibilité de A donc l'utilisateur obtient un pire taux de 1-S * Y jetons.

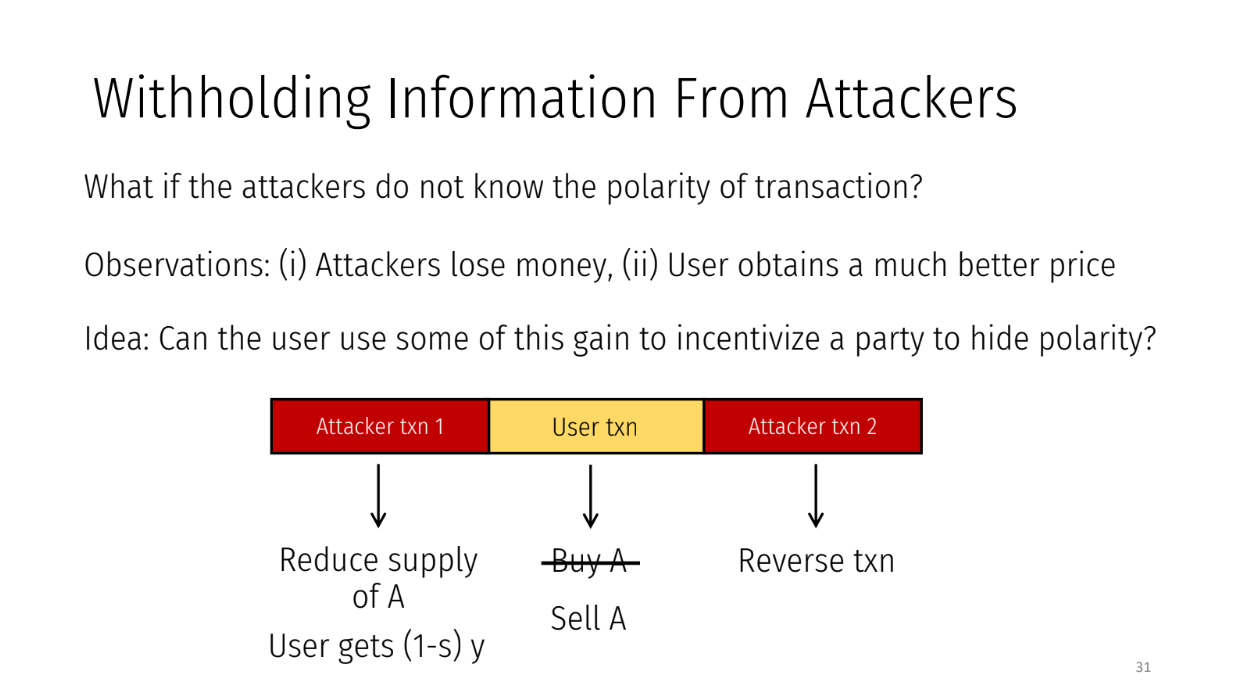

Mais comment les attaquants exploitent le slippage si les types de transactions (achat/vente) leur sont cachés ?

Si un attaquant pense que la cible est un ordre d'achat alors qu'il s'agit d'un ordre de vente, les attaquants perdraient de l'argent en effectuant cette attaque et les utilisateurs obtiendraient un prix bien meilleur que ce à quoi ils s'attendaient initialement.

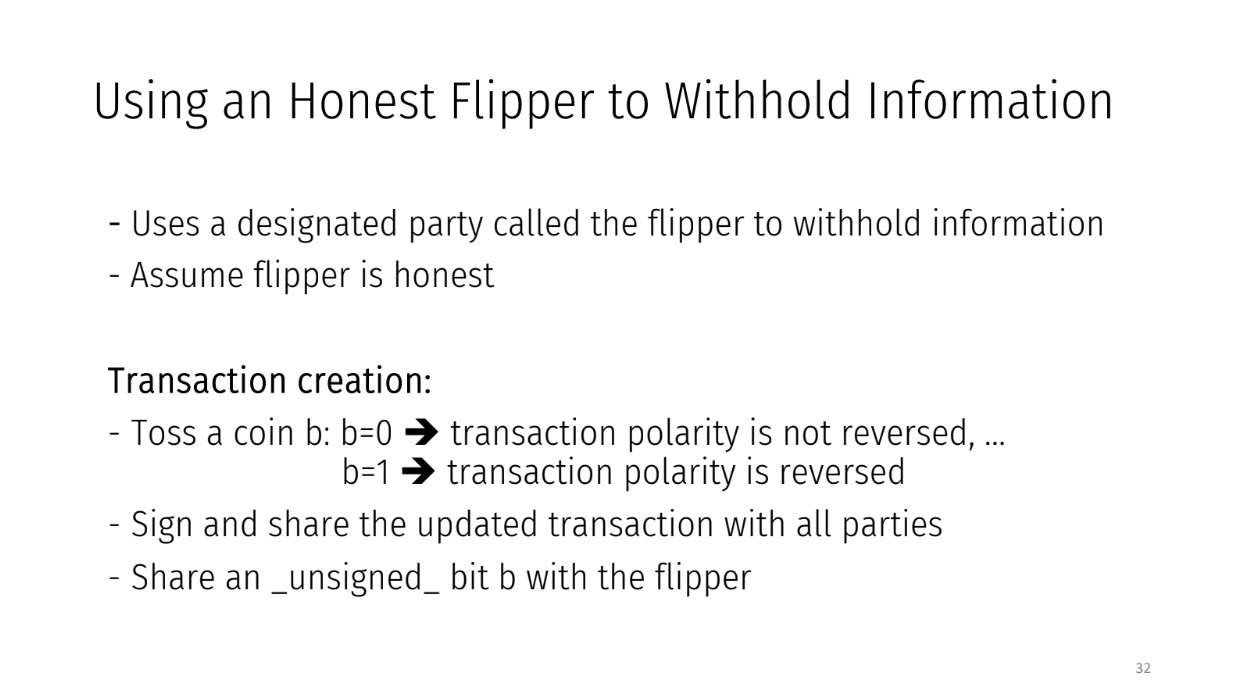

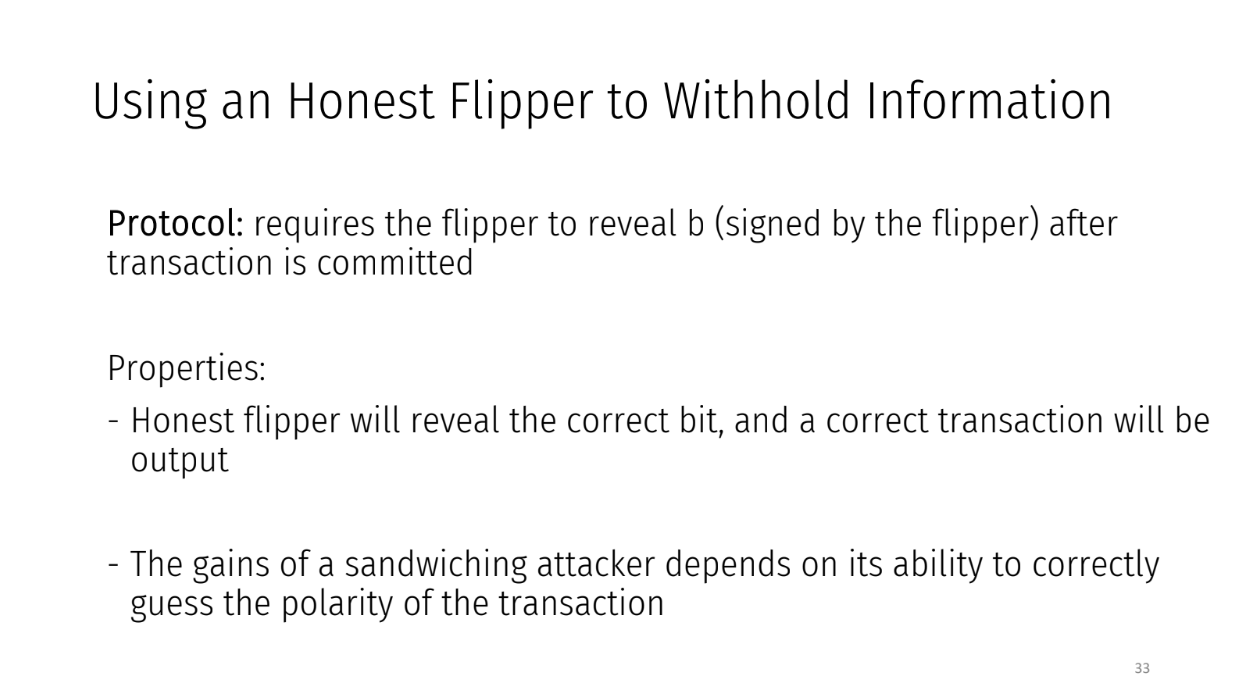

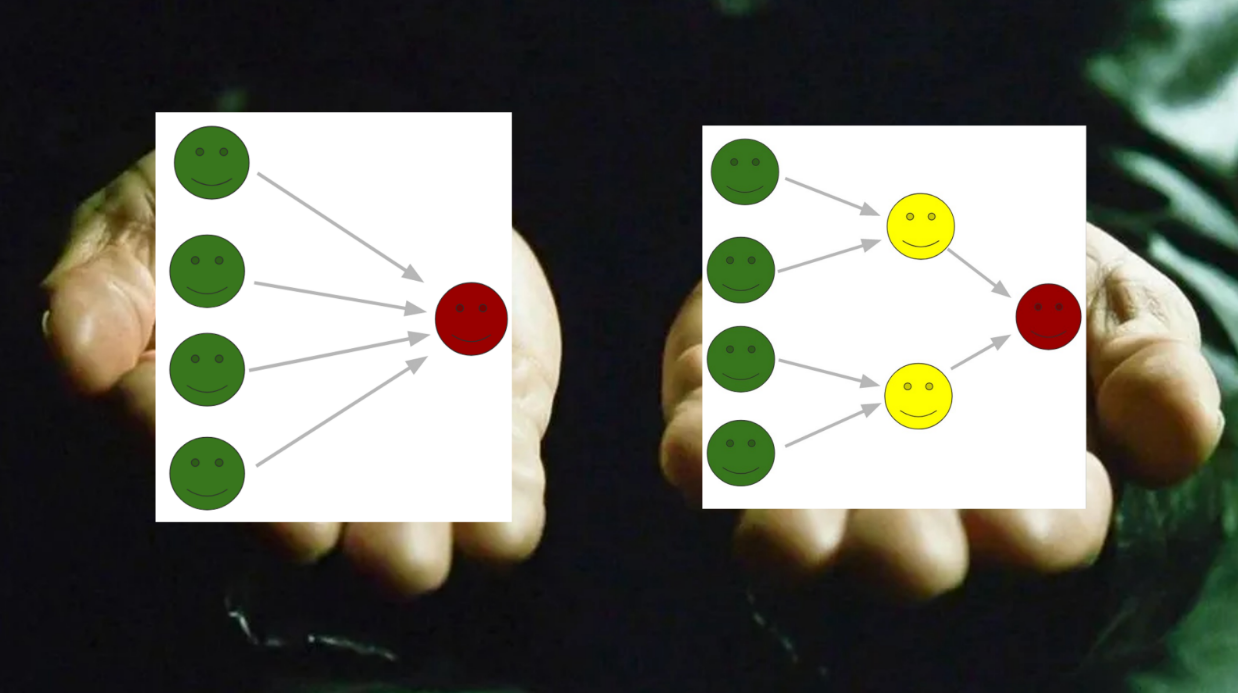

Utilisation d'un flipper honnête pour dissimuler des informations (18:30)

Un tiers appelé "flipper" voit la vraie transaction mais la cache aux autres acteurs. Cela les déroute donc ils ne peuvent pas faire d'attaque sandwich, et le flipper gagne une commission pour son rôle.

Voici comment cela fonctionne avec un flipper honnête :

- L'utilisateur soumet une transaction "achat" mais la retourne en "vente" avec 50% de probabilité avant de la partager avec les acteurs

- L'utilisateur partage la vraie transaction non signée avec le flipper

- Les acteurs commandent les transactions cachées

- Le flipper révèle le vrai type de transaction après l'ordre

Cela empêche les attaques sandwich et garantit une exécution correcte, et le flipper gagne des frais quand les utilisateurs obtiennent de meilleurs prix grâce à son aide

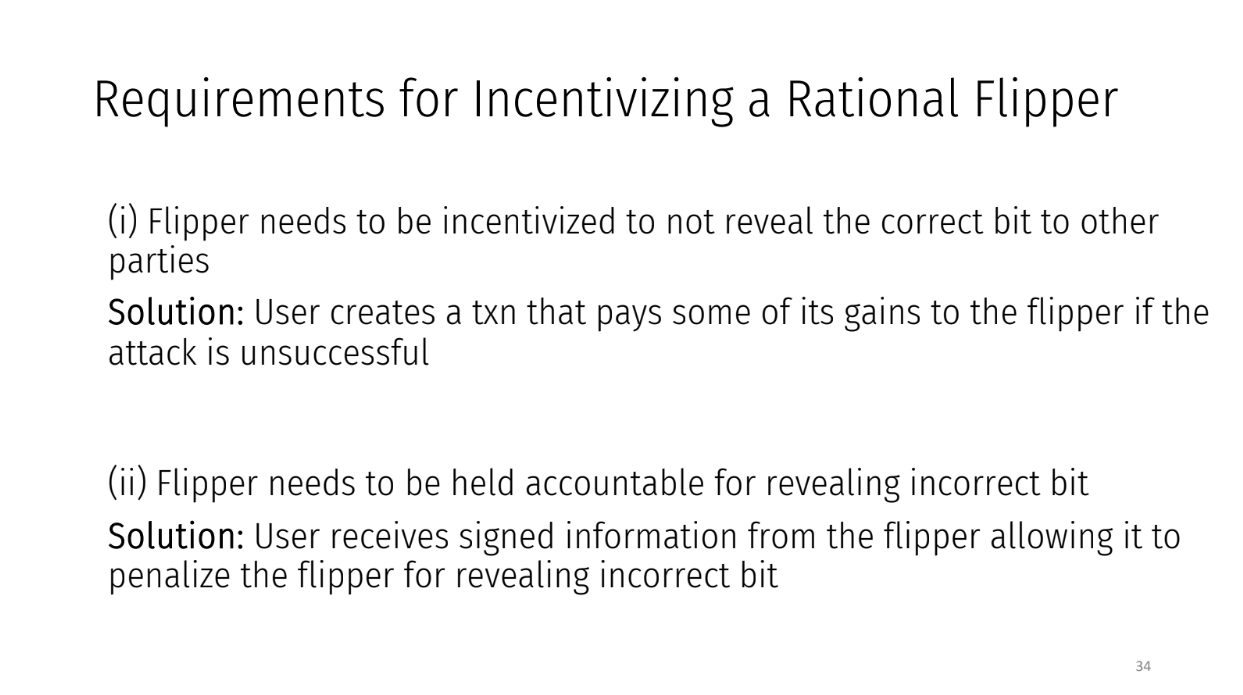

Pour inciter un flipper rationnel, il faut le récompenser quand ses tours aident les utilisateurs, et doit être pénalisé s'il collabore et révèle des informations prématurément

Cela utilise une liaison rationnelle pour détendre la liaison de transaction tout en empêchant les attaques. Kartik explore les limites comme des fonds des utilisateurs insuffisants, mais c'est une idée intéressante pour arrêter les attaques avec des acteurs rationnels

FAQ

Comment savoir qu'un flipper a été honnête une fois que les événements se sont produits ? (22:00)

Le flipper n'a pas vraiment besoin d'être honnête. Le flipper prend un engagement envers l'utilisateur pour révéler ultérieurement le vrai type de transaction. S'ils ne le font pas, l'utilisateur peut pénaliser le flipper.

Ne faudrait t'il pas payer le flipper au moins autant de profit qu'il pourrait réaliser avec une attaque sandwich ? Sinon, il pourrait simplement attaquer au lieu d'aider (23:00)

En retournant la transaction, l'utilisateur peut gagner plus que le profit de l'attaque sandwich.

Ce profit supplémentaire peut être partagé avec le flipper comme paiement. Le flipper profite de l'utilisateur, pas de l'attaque.

L'AMM a-t-il besoin d'une intégration spéciale avec le flipper ? (24:30)

Oui, après l'engagement, le flipper doit envoyer une entrée pour révéler le vrai type de transaction. Une certaine coordination est donc nécessaire.

Qu'est-ce qui empêche un flipper malveillant de perturber les transactions dans une attaque par déni de service (DoS) ? (25:00)

C'est une limitation - un flipper byzantin pourrait attaquer et être pénalisé. Ils détendent la liaison de transaction, donc cette attaque est possible.

Comment un flipper est sélectionné ? (25:45)

Kartik suggère que celui qui propose un bloc pourrait être le flipper. Aucune méthode de sélection spécifique n'est définie.

Flux d'ordres protégés (PROF)

Commander des transactions équitables dans un monde en quête de profit

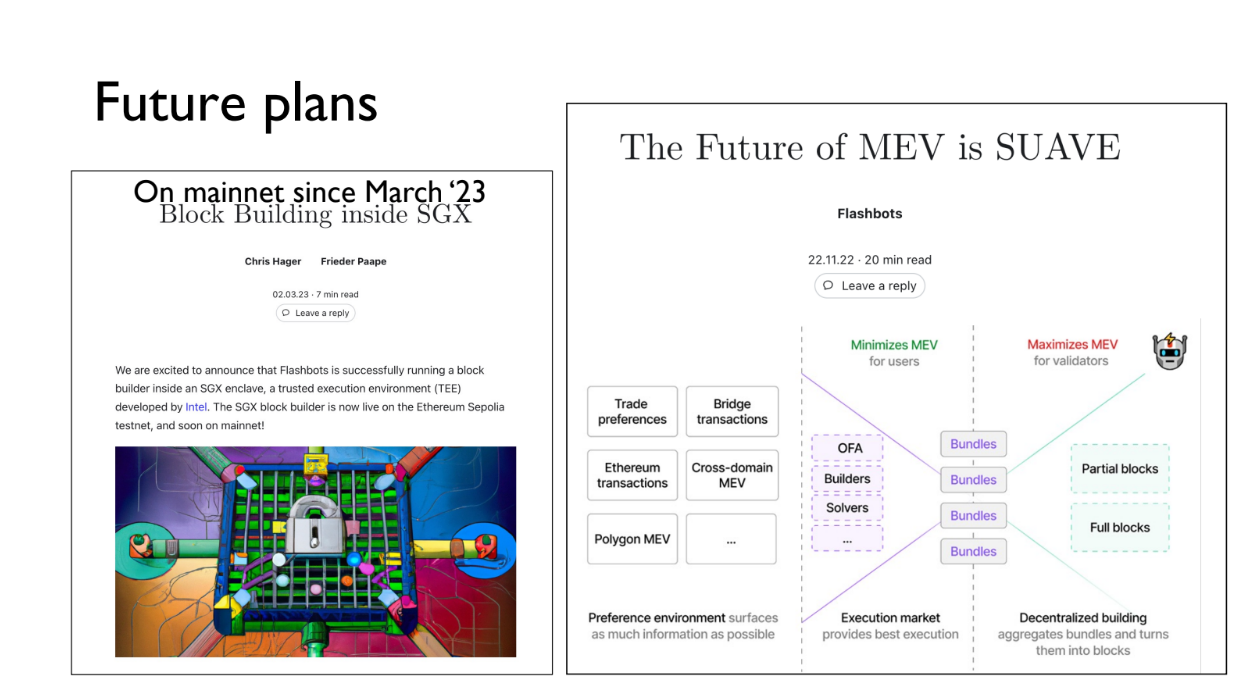

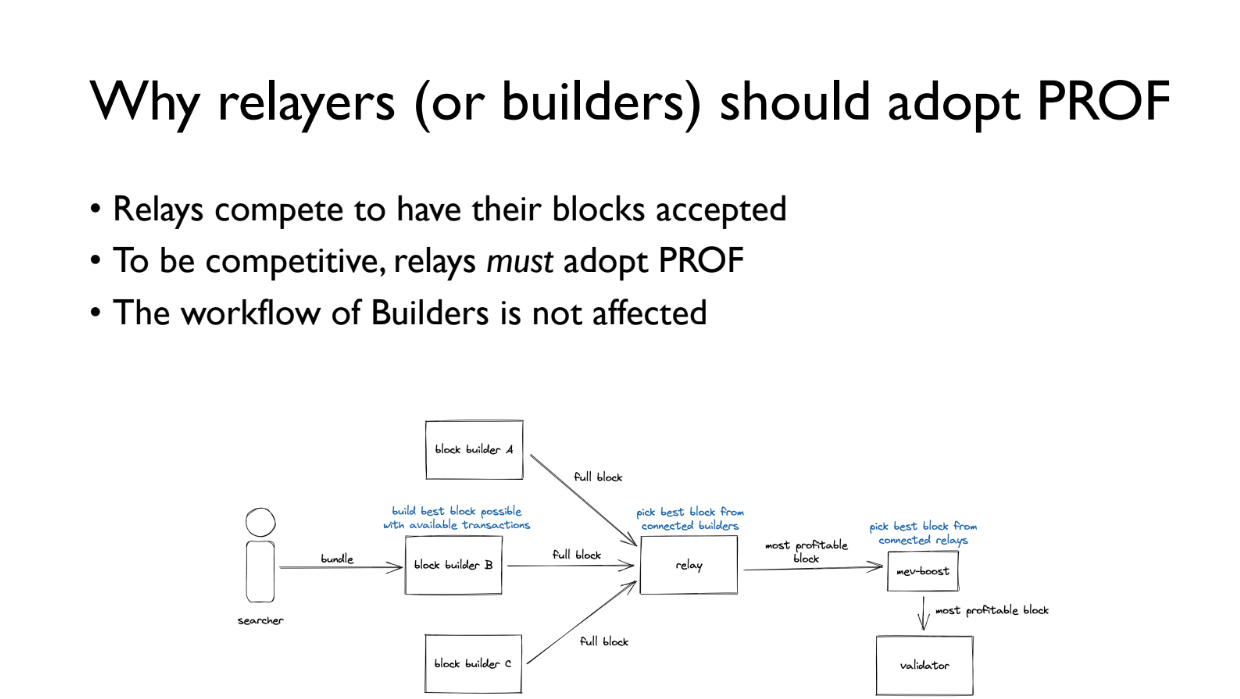

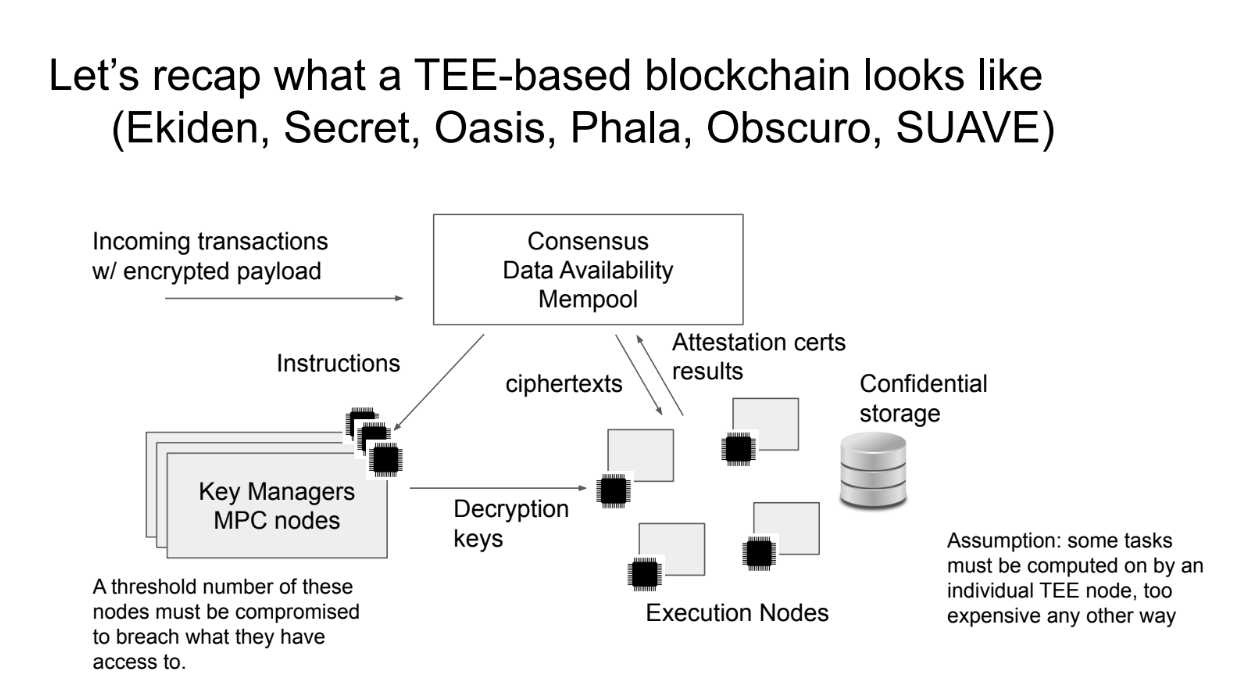

Cet exposé porte sur un projet de recherche en cours appelé "Protected Order Flow" (PROF) qui vise à permettre un ordonnancement équitable des transactions sur les réseaux blockchain comme Ethereum.

L'objectif de PROF est d'ajouter des paquets (Bundles) de transactions aux blocs dans un ordre équitable, tout en restant compatible avec les systèmes existants comme Flashbots.

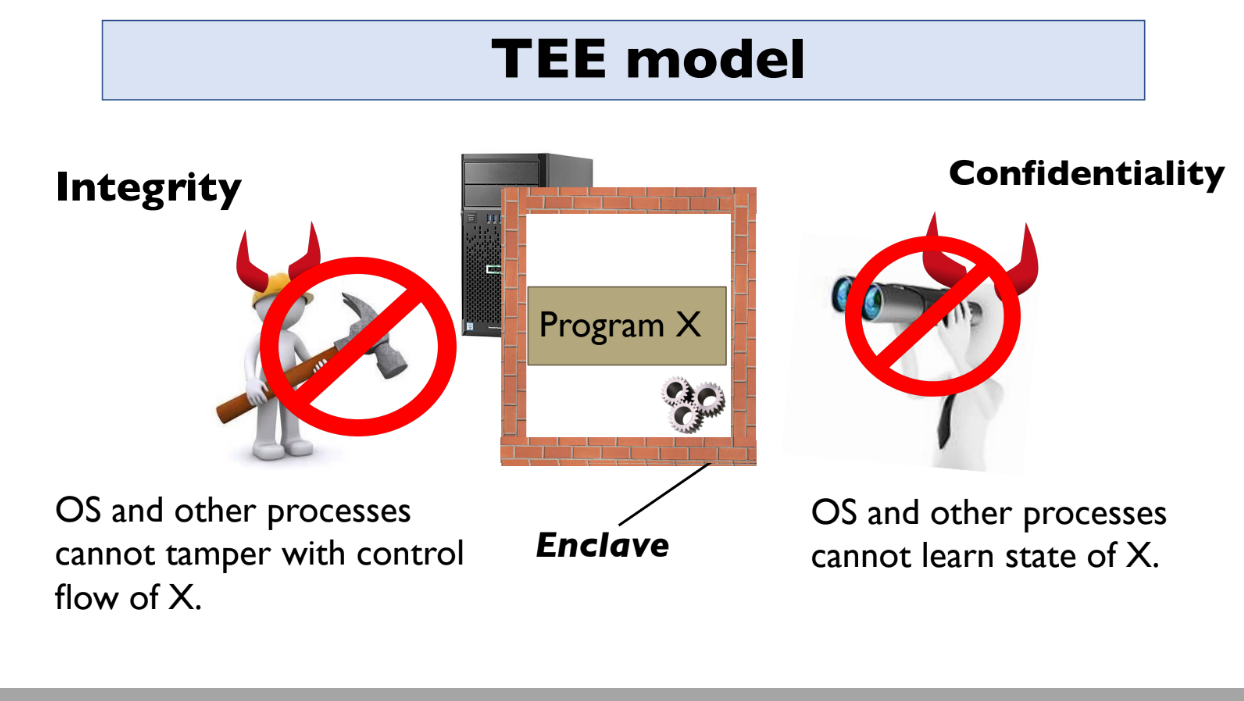

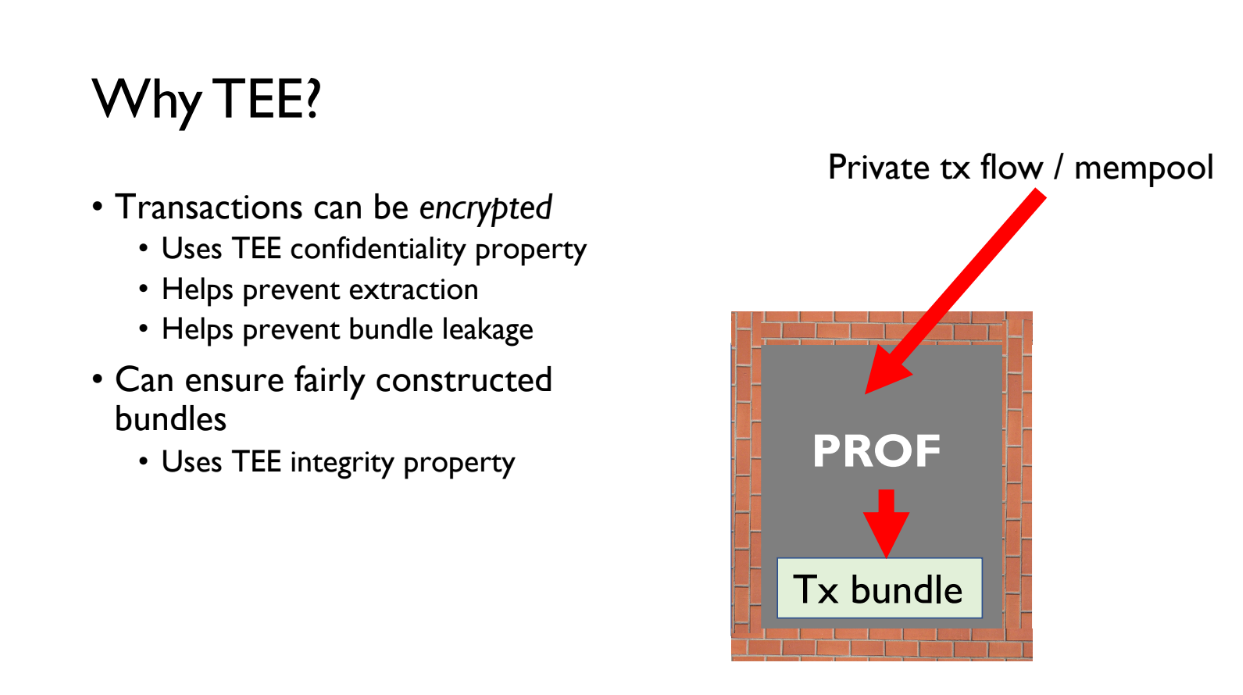

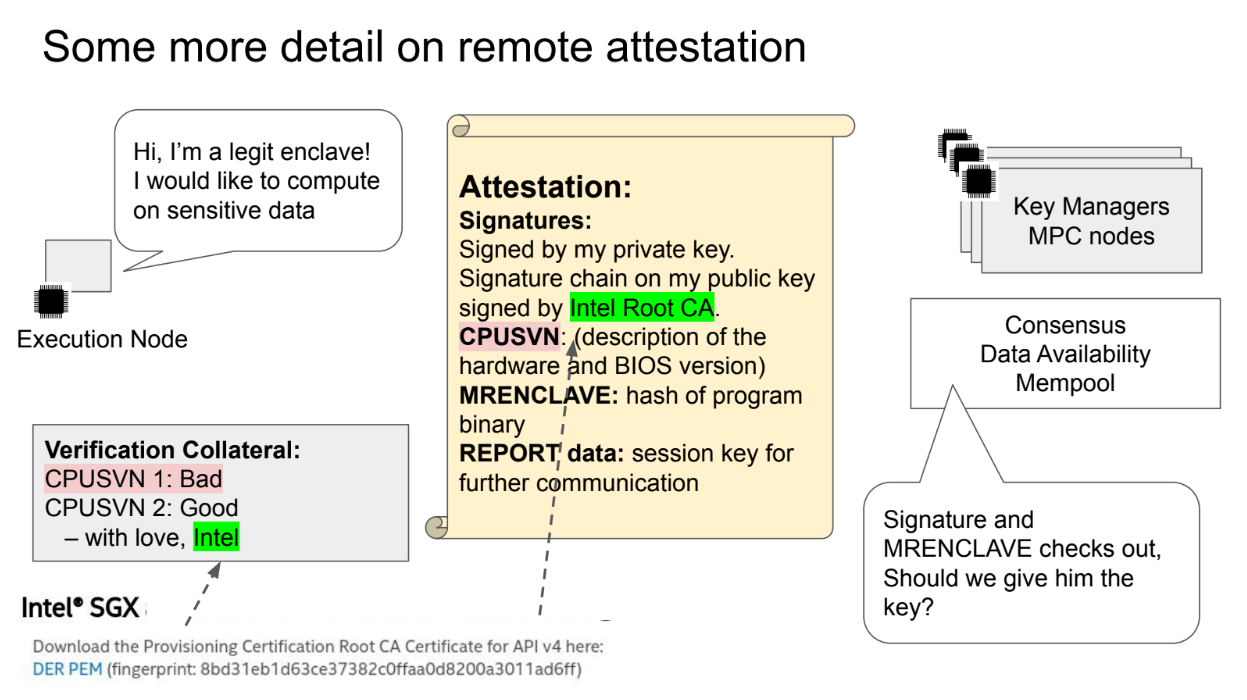

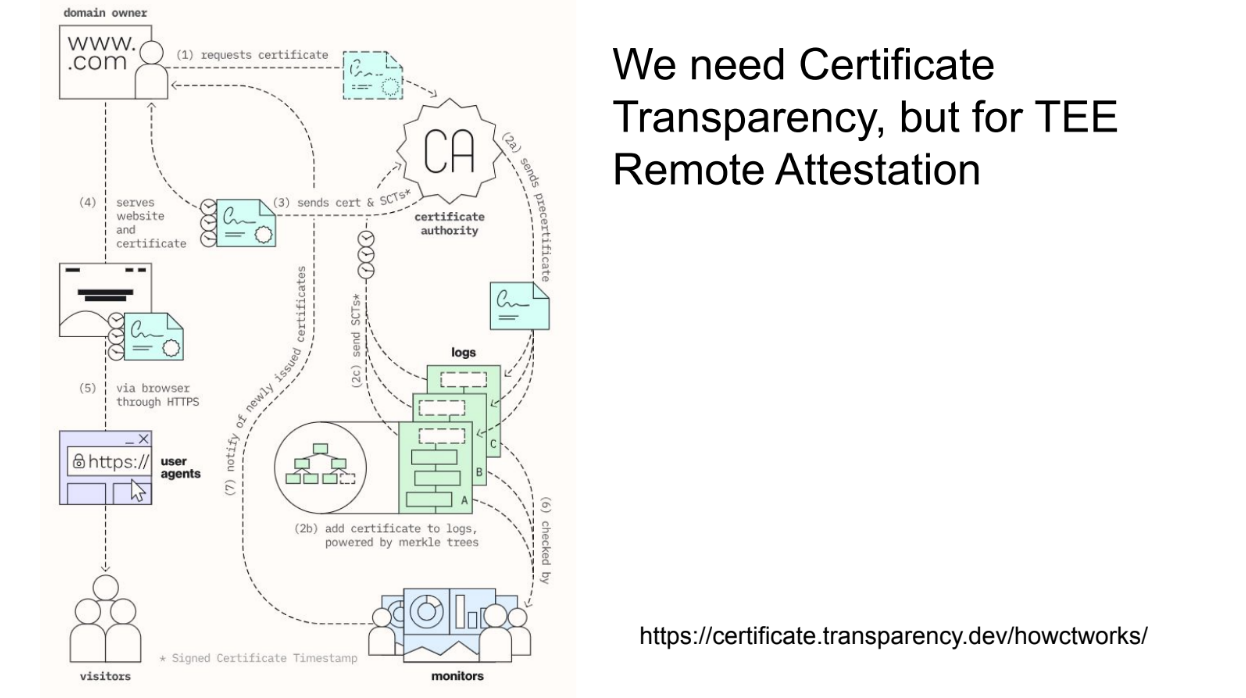

Pour ce faire, PROF s'appuie sur des environnements d'exécution de confiance (TEE) comme Intel SGX. Les TEE vous permettent d'exécuter des programmes de manière privée à l'intérieur d'un environnement protégé. Les propriétés clés des TEE sont:

- Intégrité - personne ne peut altérer le programme s'exécutant à l'intérieur

- Confidentialité - personne ne peut voir à l'intérieur du programme

- Attestation - Les TEE peuvent prouver aux utilisateurs qu'ils exécutent le bon programme

Examples : AWS Nitro, Intel SGX, AMD SEV, ARM TrustZone

En utilisant les TEE, le PROF peut exécuter un programme qui ordonne les transactions de manière équitable et sécurisée et les ajoute aux blocs.

Cela est différent des systèmes précédents car les TEE fournissent de meilleures garanties de confiance. Cependant, les TEE ont certaines limites en termes de disponibilité et d'attaques par canal auxiliaire.

Le TEE pour la construction de blocs

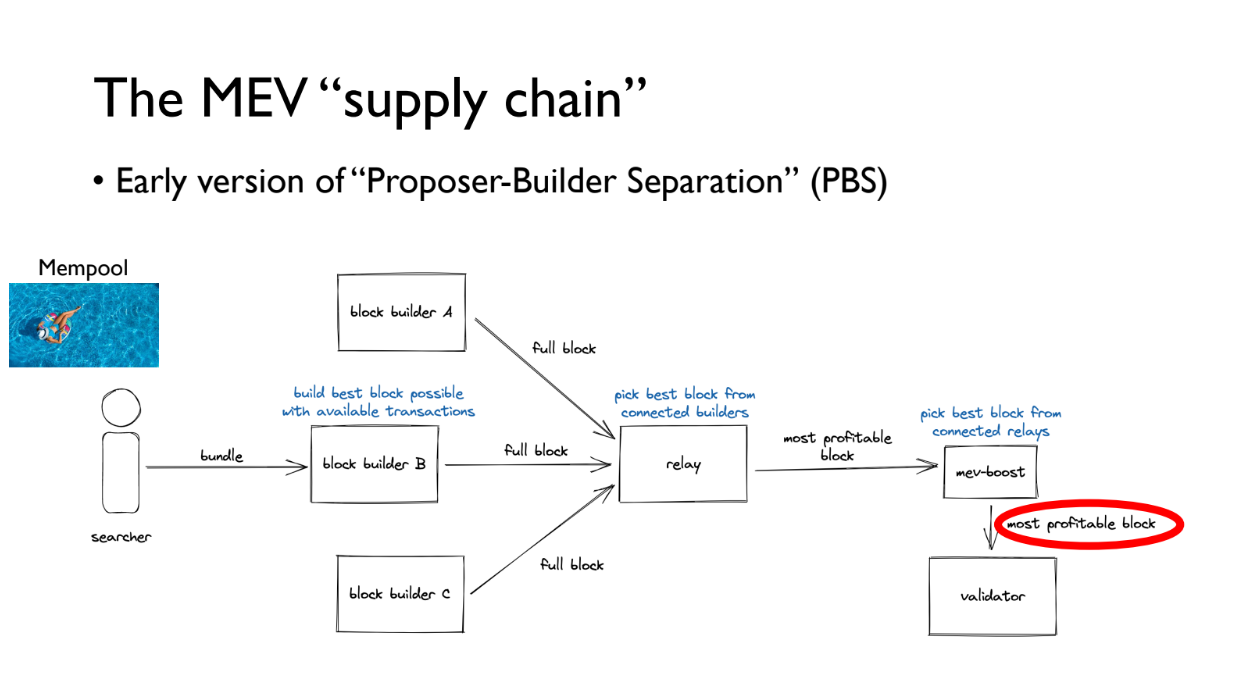

La "chaîne d'approvisionnement" de la MEV (4:00)

Comment fonctionne la chaîne d'approvisionnement de la MEV:

- Il y a un mempool public de transactions

- Les chercheurs de bloc (Searchers) trouvent des paquets de transactions rentables et les donnent aux constructeurs de blocs

- Les constructeurs de blocs (Builders) créent des blocs complets et les donnent aux relais

- Les relais mènent des enchères pour le bloc le plus rentable de manière équitable

- Le bloc le plus rentable va au plugin MEV-Boost

- MEV-Boost s'assure que les validateurs n'obtiennent le bloc qu'après s'être engagés à l'inclure

Ce système utilise déjà des TEE, car Flashbots exécute son constructeur dans un TEE. Cela dit, il y a des plans pour leur utilisation dans le PROF afin de permettre d'ajouter un paquet spécial de transactions ordonnées équitablement et protégées pour améliorer l'ordonnancement des transactions.

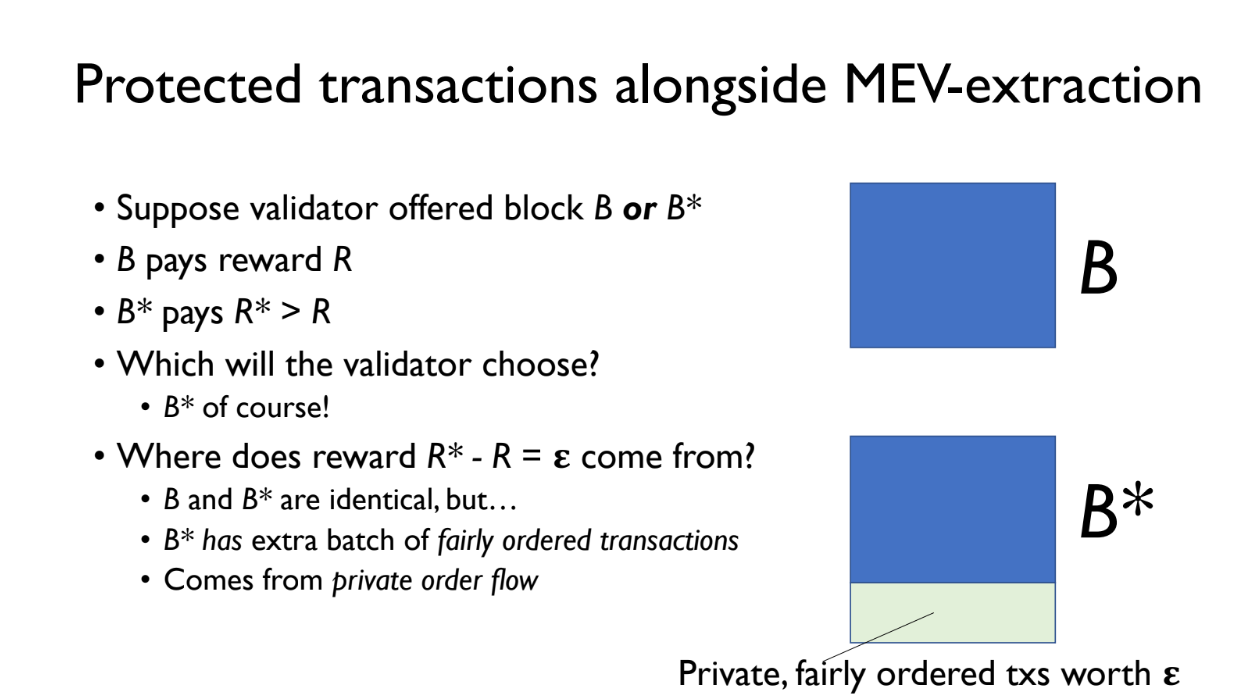

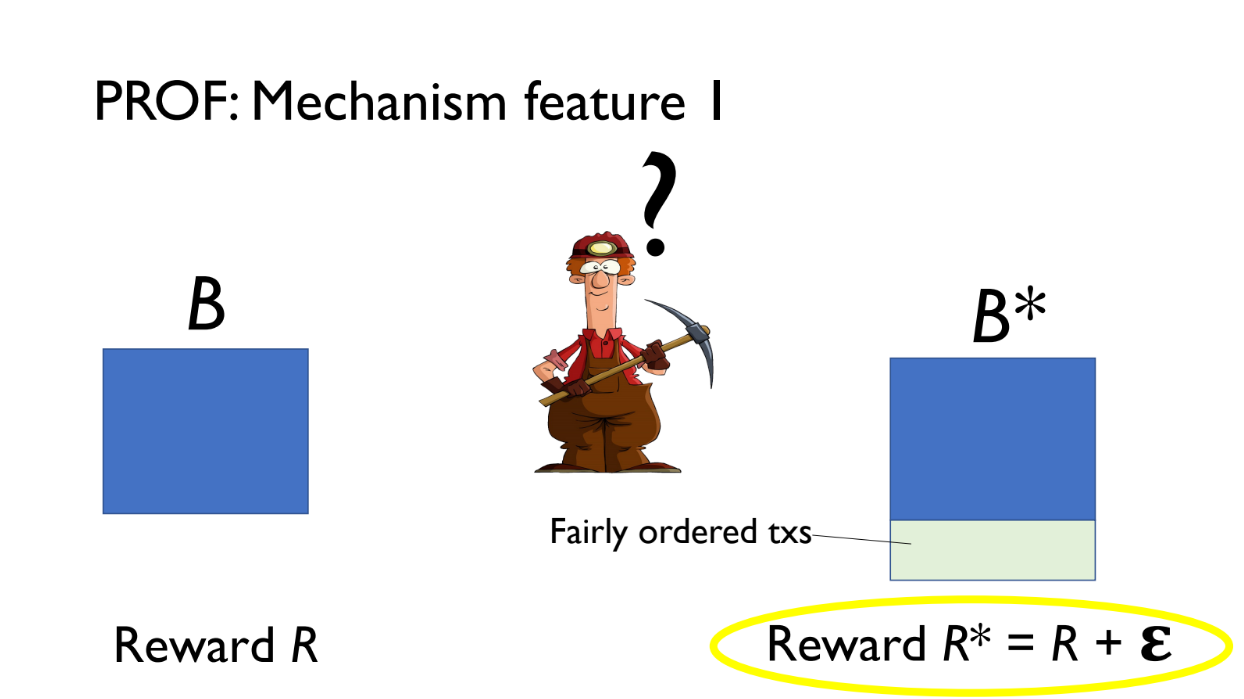

Transaction protégée aux côtés de l'extraction MEV (5:15)

Le PROF crée deux versions d'un bloc:

- B = bloc normal

- B* = B + un paquet (bundle) PROF supplémentaire de transactions

B et B* sont proposés au validateur.

- B paie la récompense R

- B* paie la récompense R + epsilon (frais supplémentaires du paquet PROF)

Le validateur choisira B* puisqu'il paie plus. Le revenu supplémentaire epsilon provient de petits frais payés par les transactions du PROF

Ces transactions PROF sont conservées confidentielles à l'aide du TEE afin que personne ne puisse en extraire le MEV.

Pourquoi le TEE ? (6:30)

Les TEE fournissent confidentialité et intégrité : les transactions sont chiffrées à l'intérieur du programme PROF, et il garantit que le paquet suit une politique équitable même si le PROF s'exécute sur des hôtes non fiables.

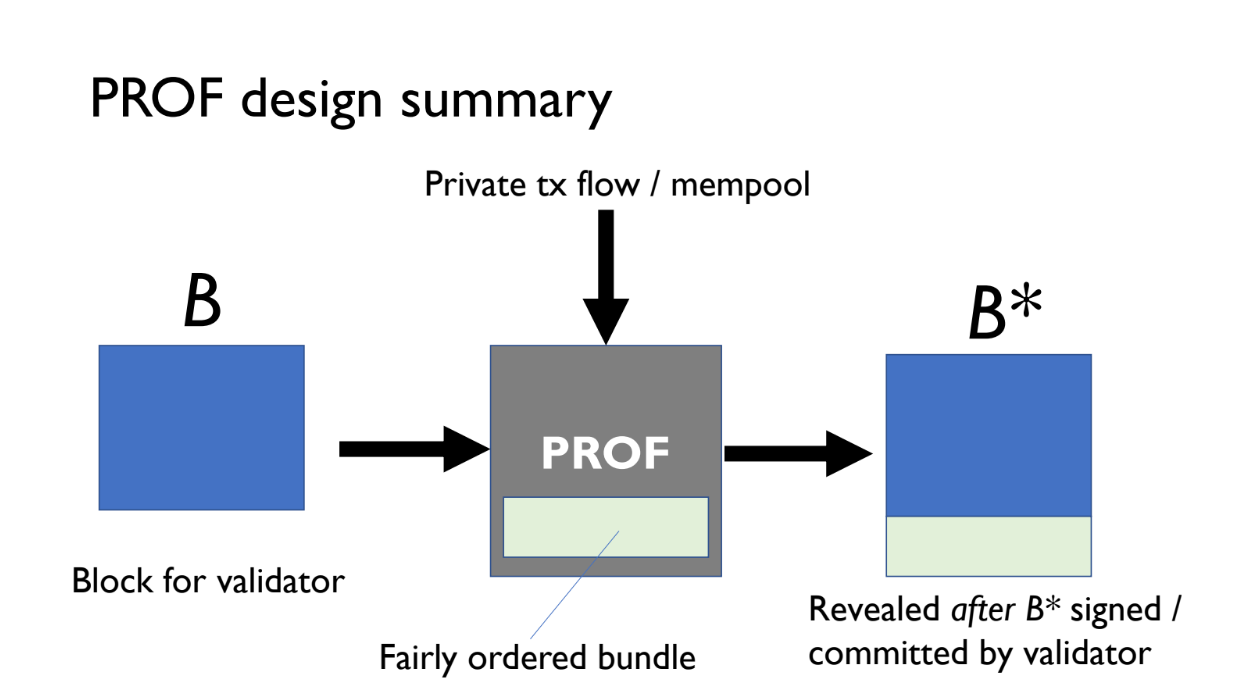

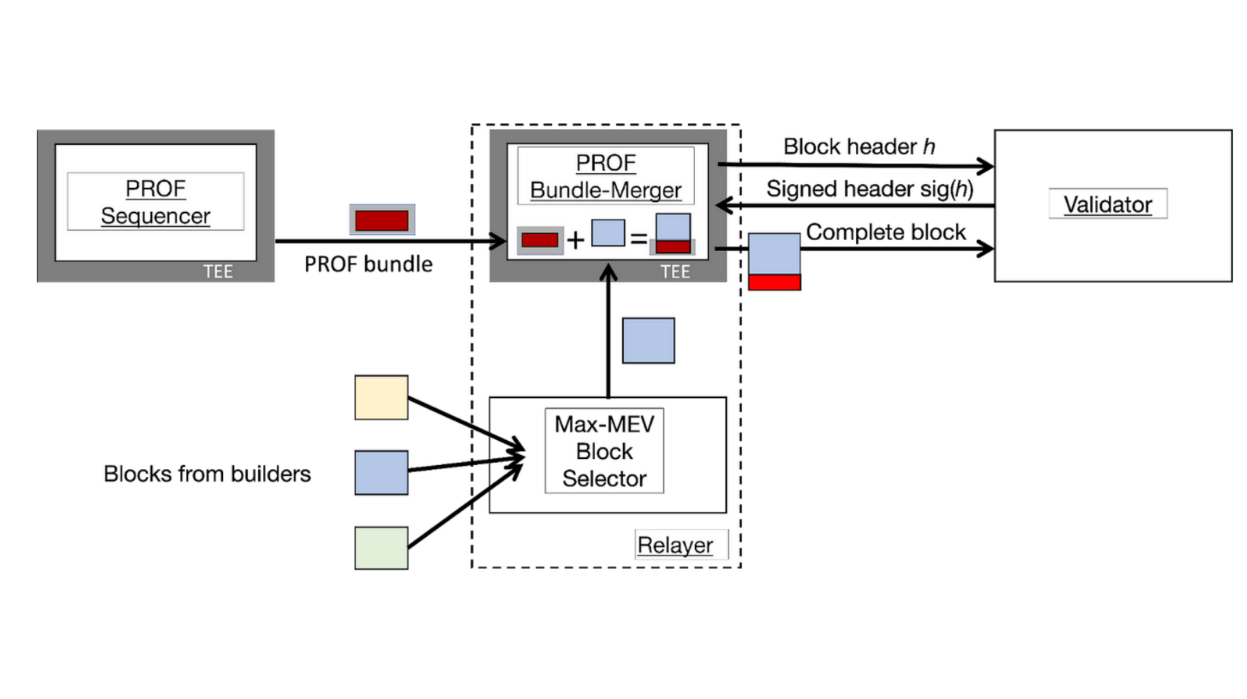

Le PROF comporte 2 composantes principales (7:30)

Séquenceur PROF

- Forme des paquets de transactions

- Peut appliquer différentes politiques d'ordonnancement

- Il peut y avoir plusieurs séquenceurs avec différentes politiques

- Le séquenceur chiffre le paquet pour protéger les transactions

Bundle Merger PROF

- S'exécute à l'intérieur d'un TEE chez le relais

- Le relais fait sa vente aux enchères normalement pour les blocs

- Le bloc gagnant est envoyé au Bundle Merger

- Le Merger ajoute le paquet chiffré du séquenceur au bloc

Le relais fonctionne normalement. Les composants PROF permettent d'ajouter un paquet spécial chiffré avec un ordonnancement équitable au bloc gagnant.

Le merger s'assure que le bloc complet n'est publié qu'après l'engagement du validateur.

Cette conception sépare la création de paquets de la fusion pour permettre des politiques flexibles et tire parti des TEE pour garder les transactions confidentielles.

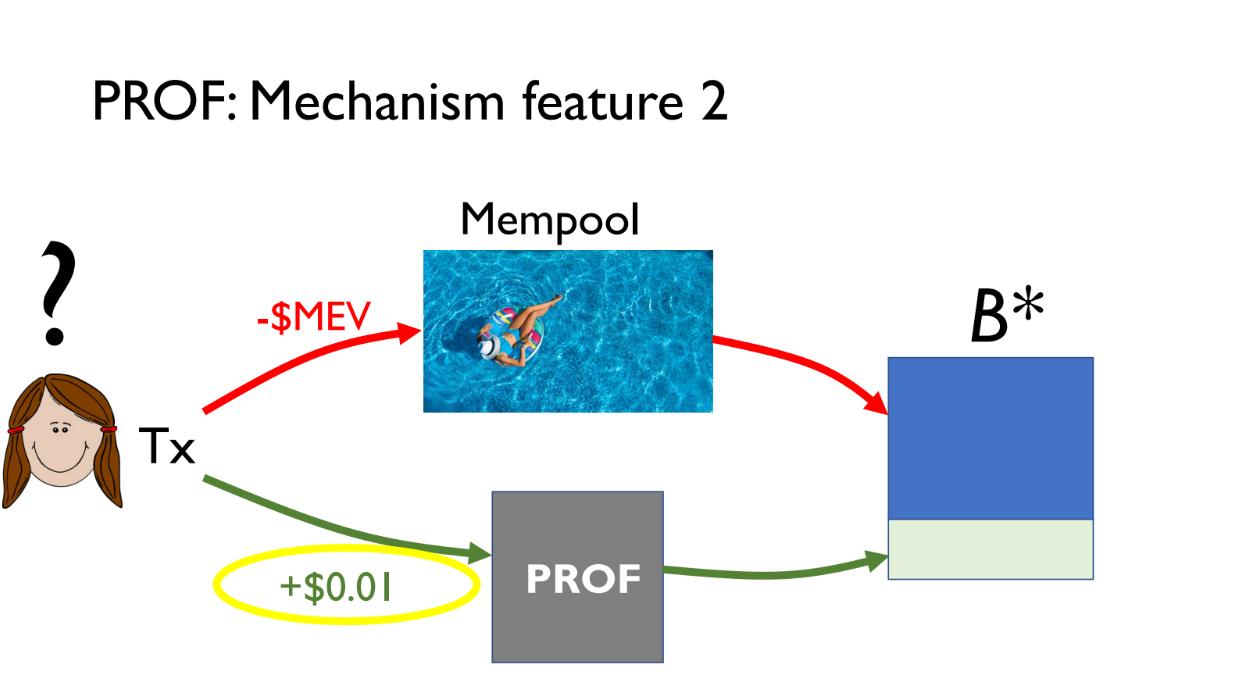

Fonctionnalités

Transactions équitablement ordonnées (9:15)

Les validateurs profitent davantage en incluant le paquet PROF, ils sont donc incités à l'utiliser.

Les relais se font concurrence pour que leurs blocs soient inclus par les validateurs. En exécutant le Bundle Merger, ils peuvent inclure des transactions PROF supplémentaires pour gagner plus de frais et être choisis plus souvent.

Le rôle des constructeurs de bloc n'est pas affecté. Le paquet PROF est ajouté après leur bloc, donc leur extraction de MEV reste identique

Les utilisateurs peuvent soit utiliser le mempool public et risquer l'extraction de MEV, soit payer de petits frais pour utiliser PROF pour un ordonnancement équitable et la confidentialité des transactions.

Points à bosser (11:30)

Le PROF est conçu pour que toutes les parties en bénéficient en l'adoptant. Mais il reste des questions ouvertes pour aligner les incitations de tout le monde :

- Le PROF devrait-il fonctionner chez les constructeurs ou les relais ? Cela implique des compromis en termes de sécurité et de latence.

- Comment gérer les paiements du PROF de manière efficace ?

- Peut-on avoir plusieurs séquenceurs PROF avec des politiques différentes ?

Il nous faut davantage d'analyses du mécanisme de conception et de comparaisons avec d'autres systèmes.

Les inquiétudes (12:30)

Kushal recommande de lire l'article de blog du PROF sur le site Web d'IC3 pour en savoir plus sur la conception et les considérations. Deux inquiétudes potentielles sont abordées :

- Le PROF peut utiliser différents schémas de commande équitables (premier arrivé, premier servi, ordonnancement causal où les transactions restent privées jusqu'à la chaîne, les deux ou aucun)

- Les environnements d'exécution de confiance (TEE) ont certaines limites comme les défaillances de disponibilité et les attaques par canal auxiliaire.

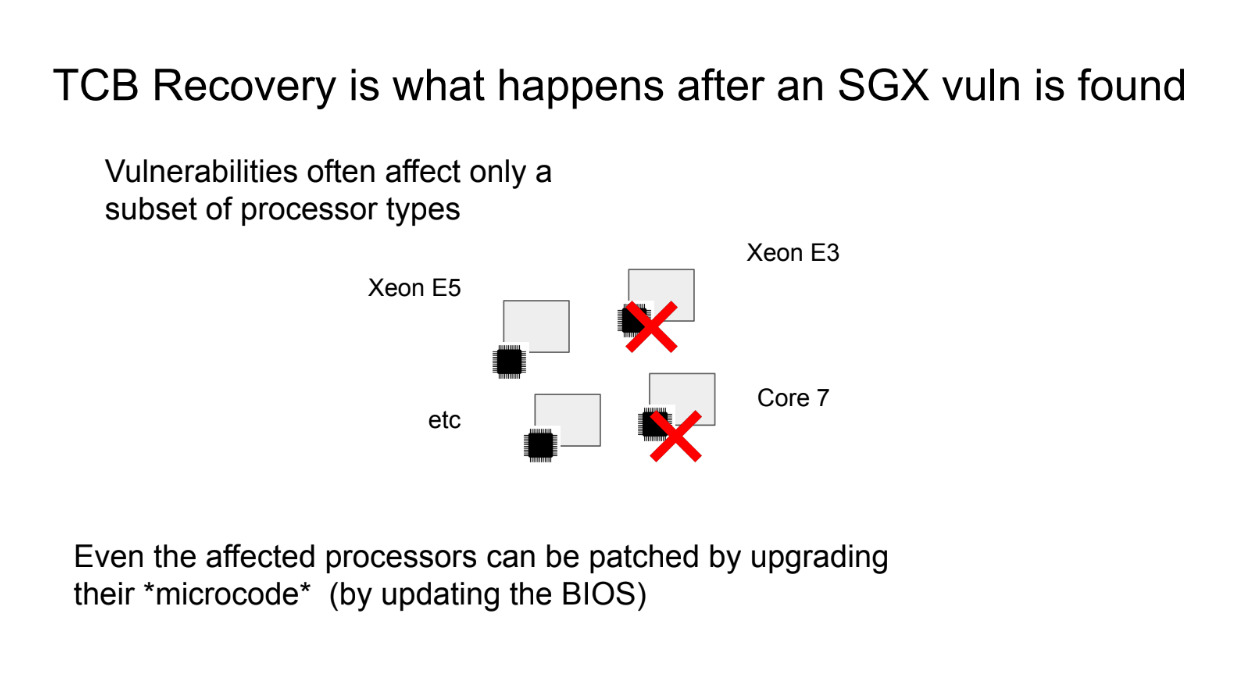

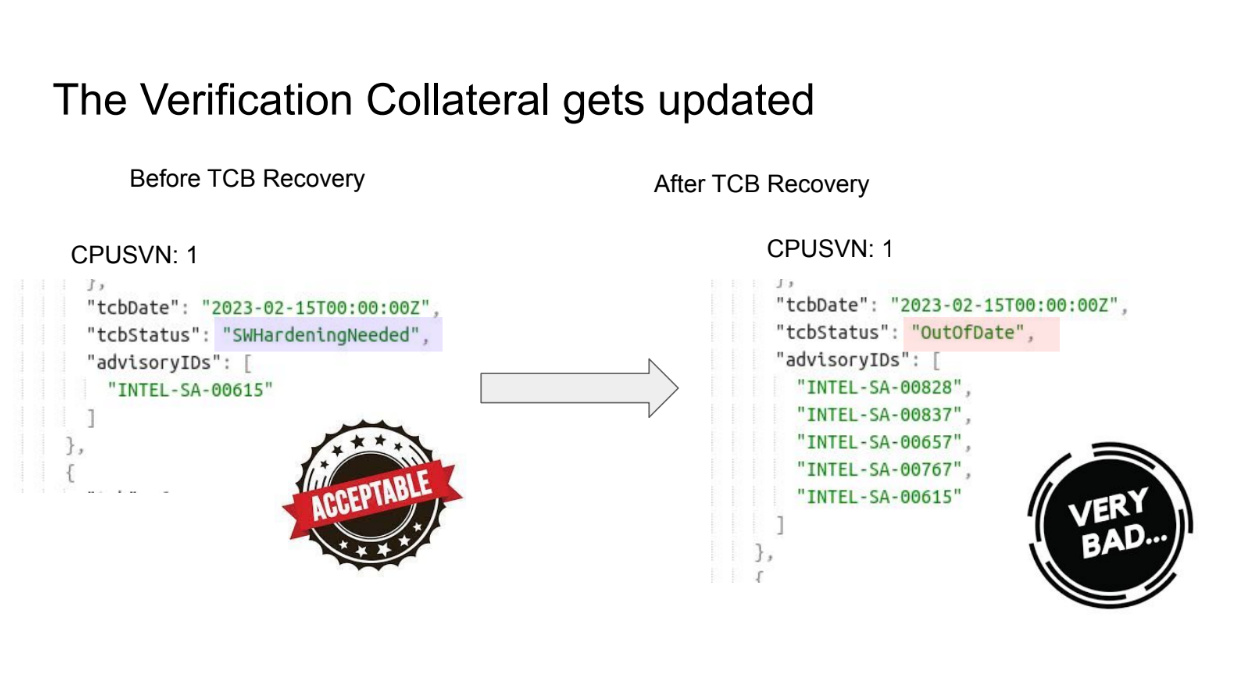

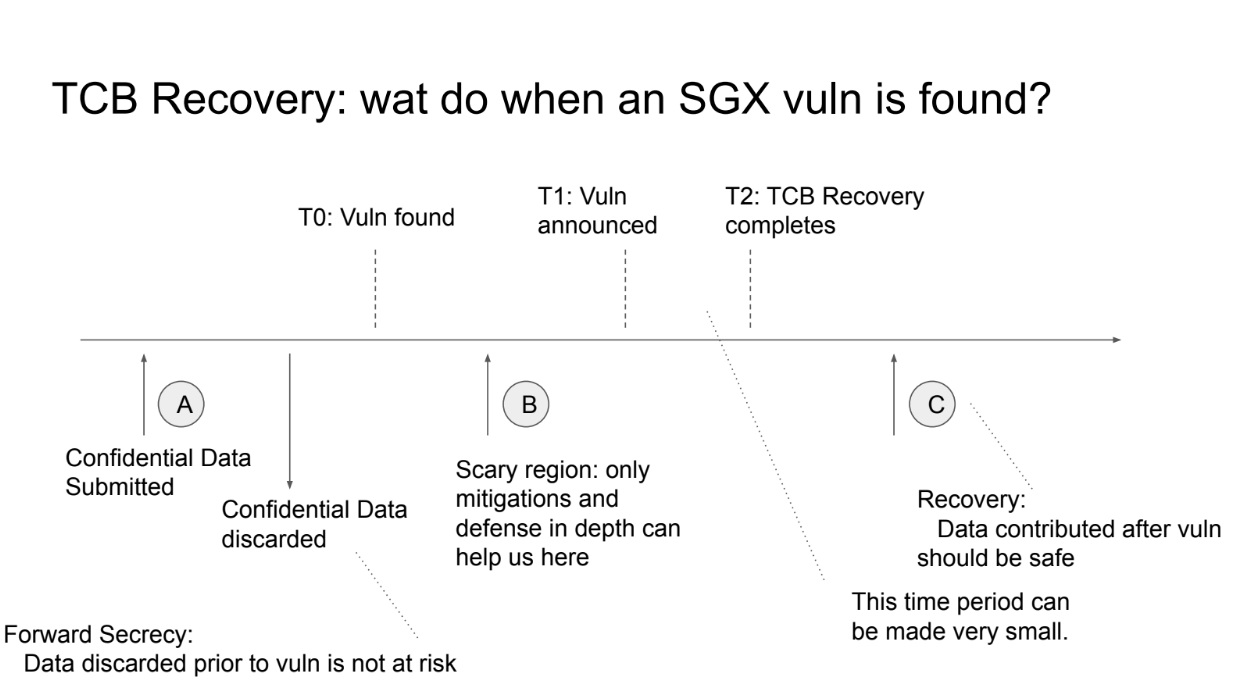

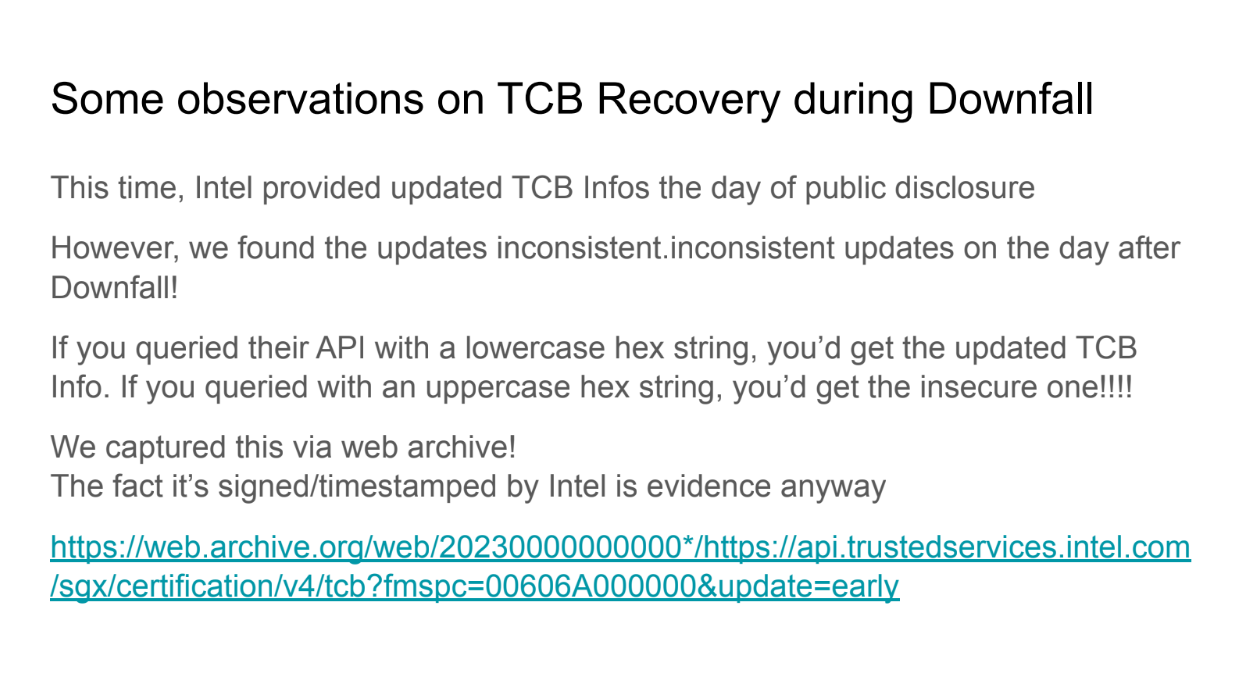

Titiller les TEEs (13:30)

Il y a de sérieuses limites à l'utilisation d'environnements d'exécution de confiance (TEE) comme Intel SGX. Il y a eu de nombreuses vulnérabilités de sécurité et attaques contre les TEE, en particulier autour de la confidentialité (attaque majeure en août 2022)

Mais sans les TEE, les transactions des utilisateurs n'ont de toute façon aucune protection et sont publiques. Les TEE fournissent une sécurité supplémentaire par rapport au statu quo.

Il existe également des moyens d'améliorer la sécurité des TEE :

- De nouvelles conceptions TEE et atténuations d'attaques sont à l'étude

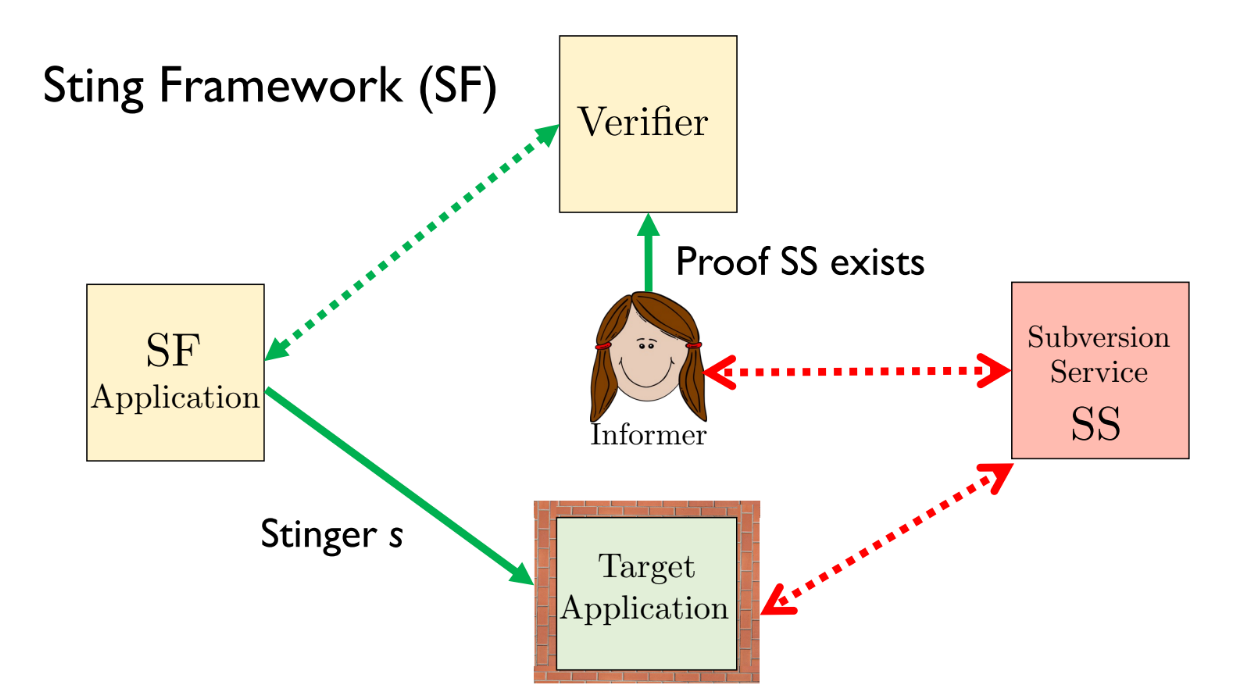

- Le cadre "Sting" est une approche pour se protéger contre les vulnérabilités des TEE.

FAQ

Actuellement, le relais doit construire un bloc complet et enchérir dessus pour participer. Comment le PROF change cela et s'il devrait fonctionner chez les constructeurs ou les relais ? (15:00)

La fusion de paquets se produit au niveau du relais dans la conception du PROF. Le flux de travail du constructeur ne change pas - ils font le même paiement aux validateurs.

L'enchère change car le bloc contient maintenant le paquet PROF supplémentaire, donc les validateurs voient une enchère plus élevée.

Il existe différentes façons de partager les bénéfices entre les validateurs, les relais et les constructeurs. Les TEE peuvent aider à appliquer des politiques autour du partage des bénéfices. L'objectif est que toutes les parties en bénéficient d'une manière ou d'une autre.

L'ajout d'un paquet PROF peut augmenter la latence, et une latence plus élevée signifie généralement une valeur inférieure. Comment inciter financièrement autour de la valeur et de la latence du bloc ? (16:15)

Le paquet PROF ne serait utilisé que lorsque les coûts de latence sont faibles vers la fin de la fenêtre d'enchères. Les relais peuvent exécuter des enchères normales et PROF en parallèle et prendre le bloc le plus rentable.

Pour les blocs à valeur élevée et à faible latence, les enchères normales seraient utilisées et les transactions PROF attendraient. Cela maximise la rentabilité globale.

Pensez-vous que les gens l'utiliseraient comme moyen de minimiser les pourboires (par rapport à l'utilisation du mempool public) ? (18:30)

L'utilisation du PROF nécessite toujours de payer un pourboire, mais protège contre l'extraction de MEV qui est un risque avec le mempool public.

Une autre personne a noté que les transactions PROF vont à la fin du bloc, on perd donc la priorité. Cela peut ne pas fonctionner pour l'arbitrage où notre but est justement d'avoir la priorité.

Kushal convient que PROF n'est pas pour les utilisateurs qui ont besoin d'une priorité maximale. C'est pour ceux qui sont d'accord pour que leurs transactions soient en bas. Les chercheurs de bloc explorent l'insertion de paquets plus tôt dans le bloc.

Y a-t-il une conception potentielle où vous pourriez soumettre des paquets privés qui incluaient des transactions du mempool public ? (20:00)

Nous pourrions le faire, mais les transactions en double sont supprimées lors de la fusion du paquet, donc ça peut ne pas réussir.

Les relais peuvent-ils potentiellement faire collusion avec les validateurs pour voler le bloc PROF du TEE sans le publier ? (20:30)

Si suffisamment de validateurs s'entendent, les attaques ne peuvent pas être empêchées. Mais avoir un quorum de validateurs honnêtes empêcherait cette collusion.

Comment le TEE sait quelles signatures de validateur il doit publier pour le bloc PROF ? (22:00)

Le TEE exécute quelque chose comme un client léger suivant les jeux de validateurs et l'état du réseau. Le contrôle et la protection contre le rollback aident à empêcher les attaques réseau contre la vue du TEE.

Intro

Phil argue que la décentralisation géographique est la propriété la plus importante pour les cryptomonnaies et la blockchain.

Les cryptomonnaies visent à être « décentralisées ». Mais la décentralisation doit être mondiale pour vraiment disperser le pouvoir. Les protocoles devraient être conçus de sorte que les nœuds puissent être exécutés à partir de n'importe où dans le monde, et non pas seulement dans des régions concentrées.

Gagner un prix nobel, ou plutôt faire genre (2:15)

Phil croit que la recherche sur les techniques de décentralisation géographique pourrait avoir autant d'impact que de gagner un prix Nobel. Même s'il n'y a pas de Nobel en informatique, on peut "faire genre" en faisant avancer ce domaine de recherche.

Pour les chercheurs en consensus, cela devrait être une priorité absolue, surtout pendant le « marché baissier » qui est un bon moment pour se concentrer sur la construction de technologies, plutôt que sur la spéculation.

Décentralisation géographique > Consensus (3:00)

Plutôt que d'étudier des modèles abstraits comme la tolérance aux pannes byzantines, les chercheurs devraient se concentrer sur la décentralisation géographique.

Car c'est le point principal qui rend des systèmes comme Ethereum vraiment décentralisés.

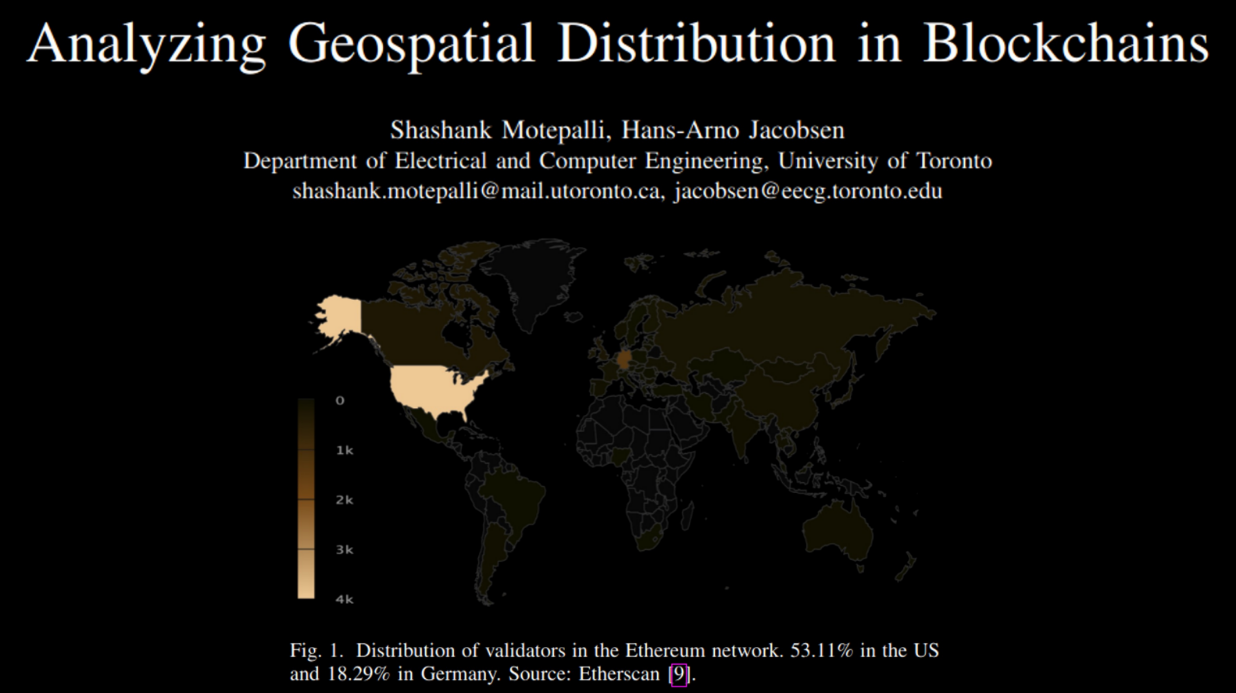

Distribution géospatiale (5:00)

Actuellement, 53,11% des validateurs Ethereum se trouvent aux États-Unis et 18,29% en Allemagne. Cela signifie qu'Ethereum n'est pas aussi décentralisé que les gens pourraient le penser, puisqu'un grand pourcentage de nœuds sont concentrés dans un seul pays.

Le fait d'avoir des nœuds regroupés dans quelques régions rend le réseau plus vulnérable - si des pannes d'internet ou d'électricité se produisent dans ces zones, une grande partie du réseau pourrait se déconnecter. Étaler les nœuds dans différents pays et continents améliore la résilience et la tolérance aux pannes du réseau.

...Mais pourquoi est-ce important ? (6:55)

La décentralisation mondiale est importante pour de nombreuses raisons, même si c'est techniquement difficile :

- Pour se conformer aux réglementations des différents pays. Si tous les noeuds exécutant une cryptomonnaie se trouvent dans un seul pays, celle-ci peut ne pas être conforme aux réglementations d'autres pays.

- Pour être « neutre » et éviter d'avoir à prendre des décisions éthiques difficiles. Il existe une idée dans la tech selon laquelle les systèmes devraient être neutres et éviter les dilemmes éthiques. Comme la Suisse est perçue comme neutre.

- Pour des cas d'utilisation comme les paiements transfrontaliers qui nécessitent une décentralisation géographique pour fonctionner sans heurts.

- Pour résister aux catastrophes ou aux conflits. Si tous les noeuds sont au même endroit, une catastrophe pourrait détruire le système. Les répartir dans le monde entier rend le système plus résilient.

- Pour l'équité. Si tous les noeuds sont dans une région, les gens d'ailleurs perdent la maîtrise et le contrôle. Les répartir globalement permet une participation plus équitable.

- Pour les effets de réseau et la coopération. Un système décentralisé au niveau mondial permet plus de coopération et de croissance du réseau.

La recette

- La décentralisation géographique, c'est quoi ? (formellement)

- Y a t'il des mesures empririques à étudier ?

- Comment concevoir/évaluer des nouveaux protocoles ?

La décentralisation géographique, c'est quoi ? (11:00)

Phil croit que le type de décentralisation le plus important pour les systèmes crypto/blockchain est la décentralisation du pouvoir, en particulier du pouvoir économique.

Les formes techniques de décentralisation (comme le nombre de validateurs) ne comptent que dans la mesure où elles ont un impact sur la décentralisation du pouvoir économique.

Une mesure à étudier(12:25)

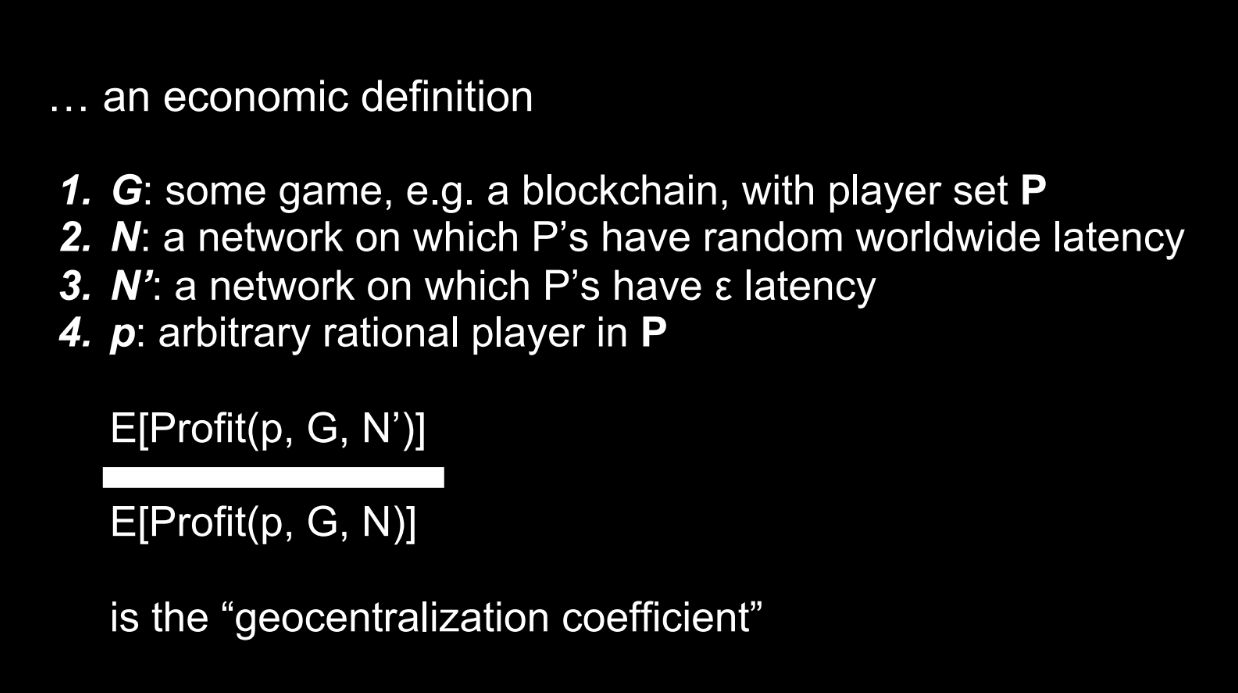

Quelques termes :

- G = un jeu/mécanisme économique

- P = l'ensemble des joueurs dans le jeu G

- N = un réseau où les joueurs subissent des latences du monde réel

N' = un réseau où les joueurs ont une latence minimale entre eux - p = un joueur rationnel arbitraire dans P

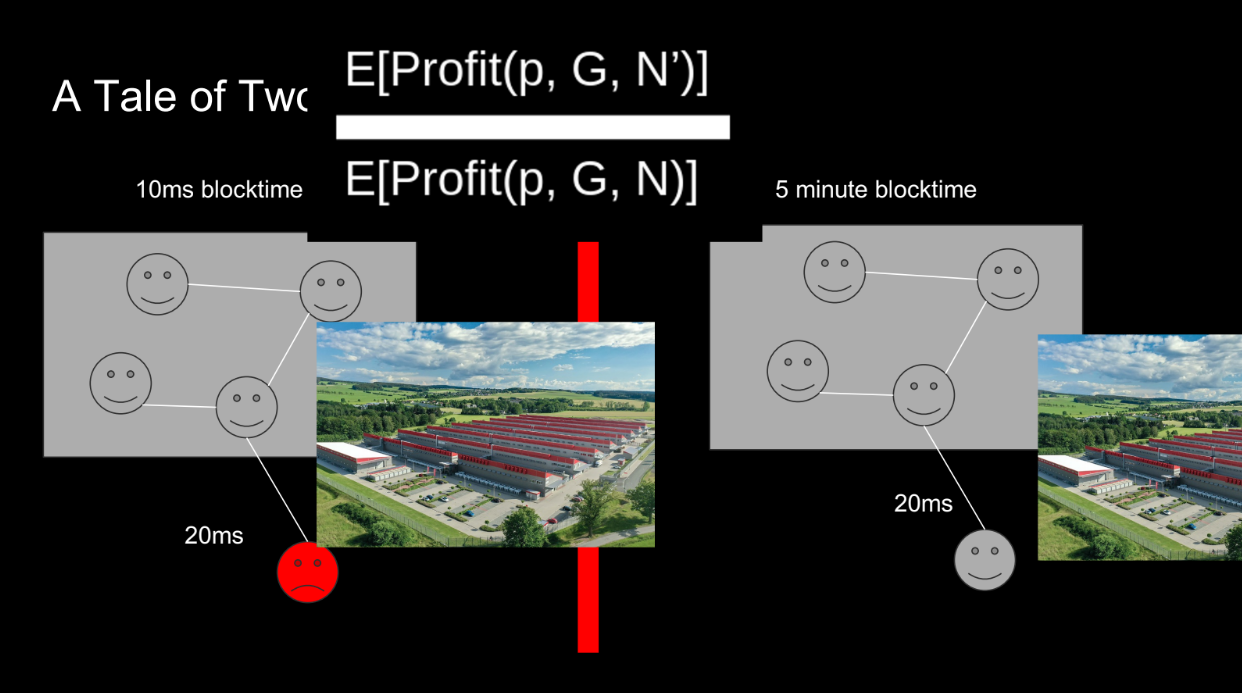

Le « coefficient de géocentralisation » fait référence au rapport entre le profit attendu d'un joueur dans le réseau à latence minimale N' et le réseau à latence du monde réel N.

Un coefficient élevé signifie qu'il y a plus d'incitation pour que les joueurs soient géographiquement co-localisés. L'objectif est de garder ce coefficient faible, pour réduire les incitations à la centralisation géographique.

Quelques exemples

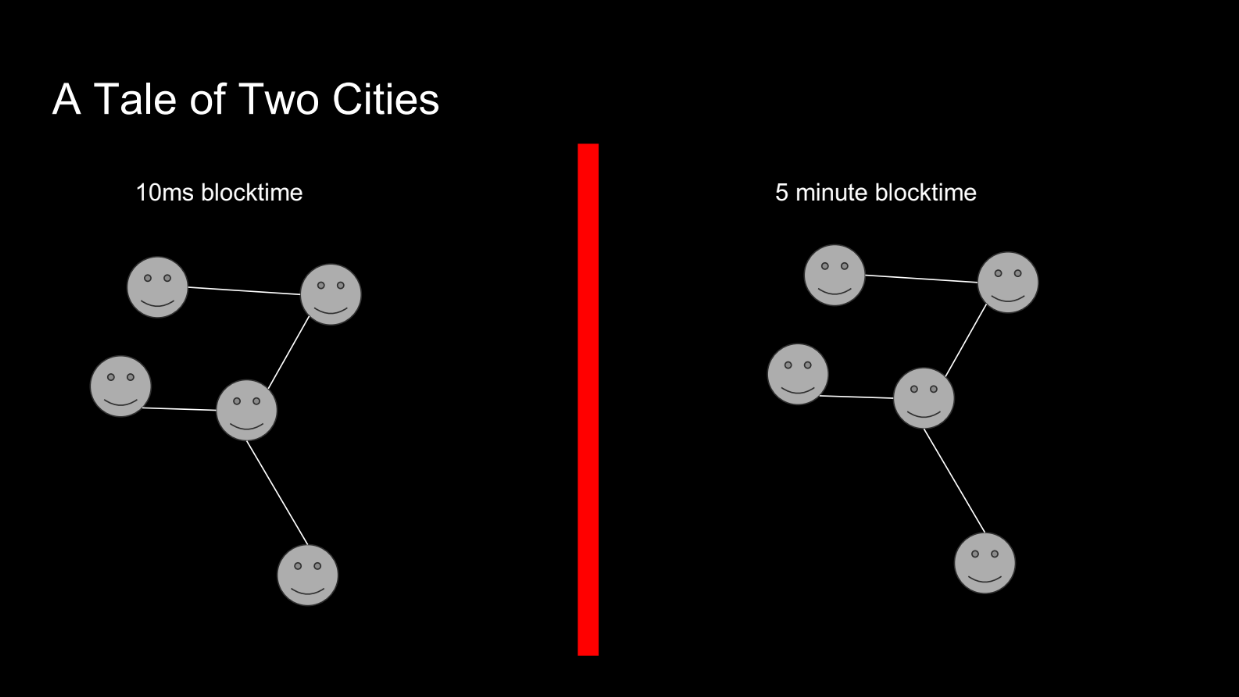

Les blockchains rapides ont un coefficient plus élevé (14:00)

Prenons un exemple comparant 2 blockchains : l'une avec des blocs rapides de 10ms, l'autre avec des blocs de 5 min :

- Dans la blockchain rapide, un nœud avec seulement 20ms de latence supplémentaire ne peut pas participer, donc son profit est nul.

- Dans la blockchain plus lente, 20ms ne change pas grand-chose. Les profits sont similaires.

Par conséquent, la blockchain rapide a un «coefficient de géocentralisation» plus élevé - plus d'incitation à la centralisation géographique. Donc une blockchain rapide comme Solana est moins décentralisée géographiquement qu'une blockchain plus lente comme Ethereum.

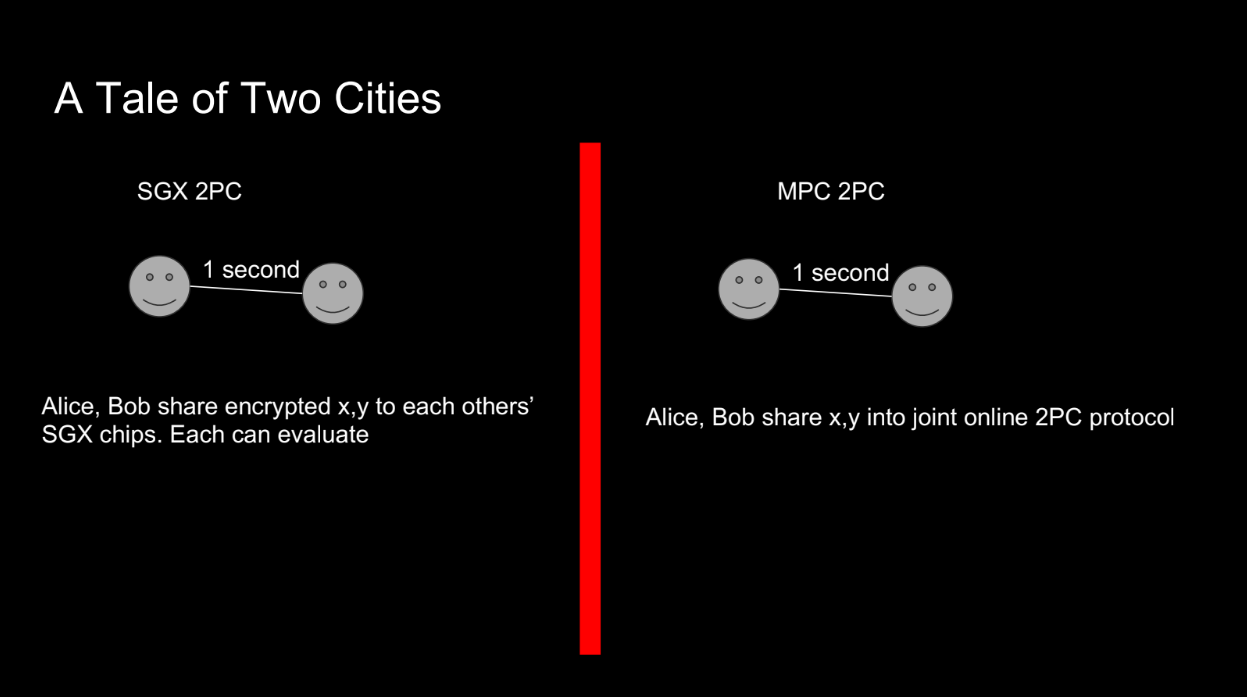

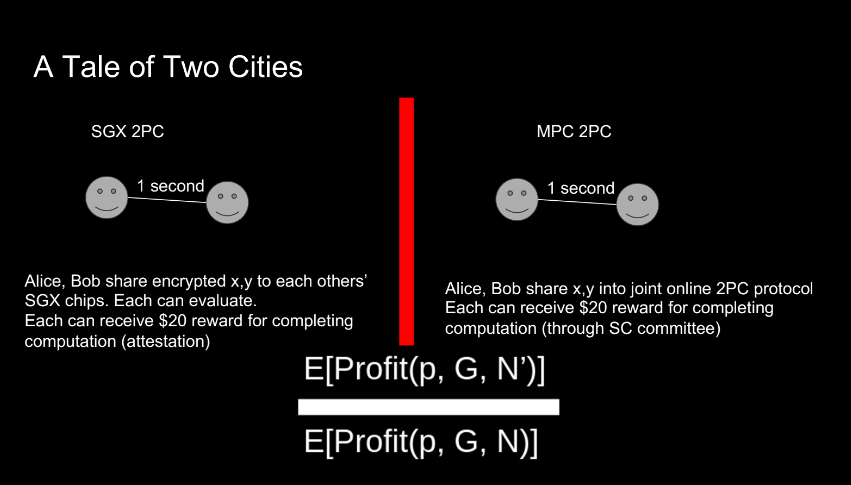

SGX et MPC (16:45)

Prenons un autre exemple avec 2 parties essayant de calculer un résultat et d'obtenir chacune 20$ :

- Les protocoles MPC nécessitent plusieurs cycles de communication entre les acteurs pour calculer un résultat de manière sécurisée. Avec une latence réseau plus élevée entre les parties, le temps pour terminer le protocole MPC augmente.

- En utilisant SGX, ils peuvent chiffrer les entrées et obtenir la sortie rapidement en 1 cycle de messagerie. La latence n'a pas beaucoup d'importance.

Ajouter du MPC aux systèmes de blockchain peut être utile, mais les protocoles doivent être conçus avec soin pour éviter une pression accrue de centralisation géographique.

Le SGX c'est mieux ? (19:00)

Phil conclut que les protocoles SGX peuvent être plus décentralisés géographiquement que les protocoles MPC.

C'est contre-intuitif, puisque l'opinion générale préfère le MPC. Mais le SGX a des besoins de latence inférieurs aux protocoles MPC, donc le SGX a un «coefficient de géocentralisation» plus faible, c'est-à-dire moins d'incitation à la centralisation géographique.

FAQ

Comment la nature physique réelle de l'Internet influence-t-elle ce concept de distribution géographique ? (20:15)

L'internet lui-même n'est pas uniformément réparti dans le monde. Cela limite à quel point les cryptomonnaies construites au-dessus peuvent être décentralisées.

Davantage de recherche est nécessaire sur la façon dont l'internet physique a un impact sur la décentralisation.

La preuve de travail serait-elle considérée comme supérieure à la preuve d'enjeu pour la décentralisation géographique ? (22:15)

Les cryptomonnaies à preuve de travail (PoW) peuvent être plus décentralisées géographiquement que la preuve d'enjeu (PoS), car les mineurs PoW ont intérêt à se situer à proximité de l'électricité bon marché.

Cependant, le PoW a aussi des problèmes comme les monopoles miniers. Donc, il n'est pas clair si le PoW est finalement mieux pour la décentralisation géographique.

Êtes-vous d'accord pour dire que plus les temps de bloc sont courts, plus la décentralisation peut être importante sur le marché des constructeurs ? (24:00)

Des temps de bloc plus courts peuvent aider à décentraliser le « marché des constructeurs » - ce qui signifie que plus de développeurs peuvent participer à la construction de chaînes. Mais c'est une question de recherche ouverte, pas un avantage définitif.

Êtes-vous au courant de recherches sur la façon d'inciter à la décentralisation géographique ? (26:30)

Une sorte d'expérience très précoce était un protocole de géolocalisation basé sur SGX et ensuite, éventuellement, la mise en place d'incitations par-dessus ce protocole. Mais Phil n'a pas de réponse ici.

Que pensez-vous de la viabilité de l'amélioration de l'infrastructure physique du réseau, comme la fourniture de bases de données décentralisées ou d'incitations pour les validateurs individuels ? (29:00)

Améliorer l'infrastructure physique comme les bases de données décentralisées pourrait aider la décentralisation.

Les gouvernements devraient envisager de subventionner les centres de données pour réduire les coûts de calcul. Cela facilite la propagation des réseaux décentralisés au niveau mondial. C'est important non seulement pour les blockchains mais aussi pour les technologies émergentes comme l'IA. Les ressources de calcul seront très précieuses à l'avenir.

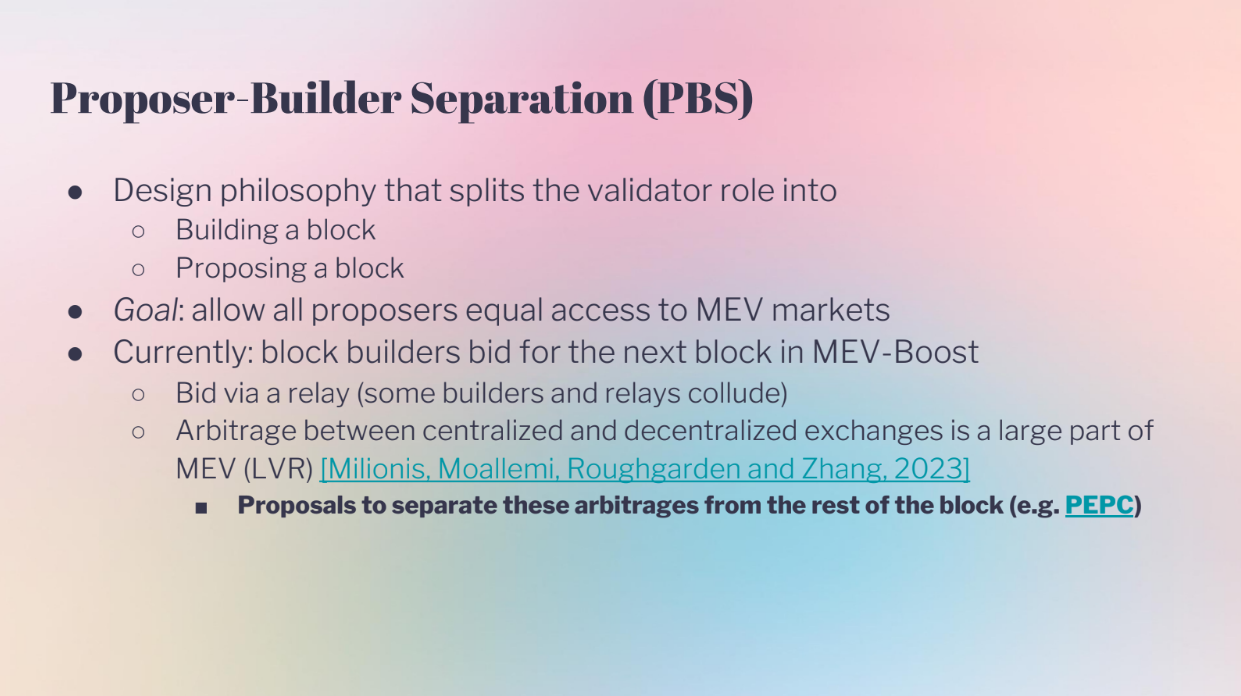

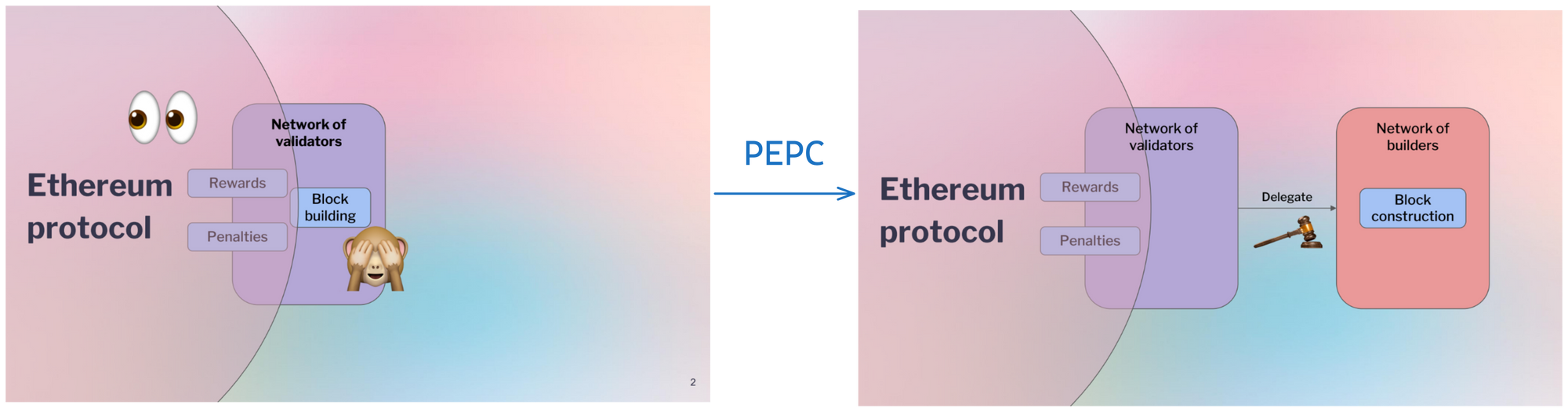

Proposer Builder Separation "PBS" (0:00)

Le PBS sépare le rôle des validateurs en 2 rôles distincts : proposant de blocs (Proposer) et constructeur de blocs (Builder). Cela aide à décentraliser Ethereum en permettant à quiconque de proposer des blocs, tout en gardant la construction de blocs complexes à des spécialistes. L'objectif est de permettre un accès égal au MEV (valeur extractible maximale).

Mais actuellement, les enchères PBS comme MEV-Boost ont des problèmes :

- Les offres se font par le biais de relais qui pourraient faire collusion ou avoir des avantages de latence.

- L'arbitrage entre les plateformes d'échange centralisées est une grande source de MEV.

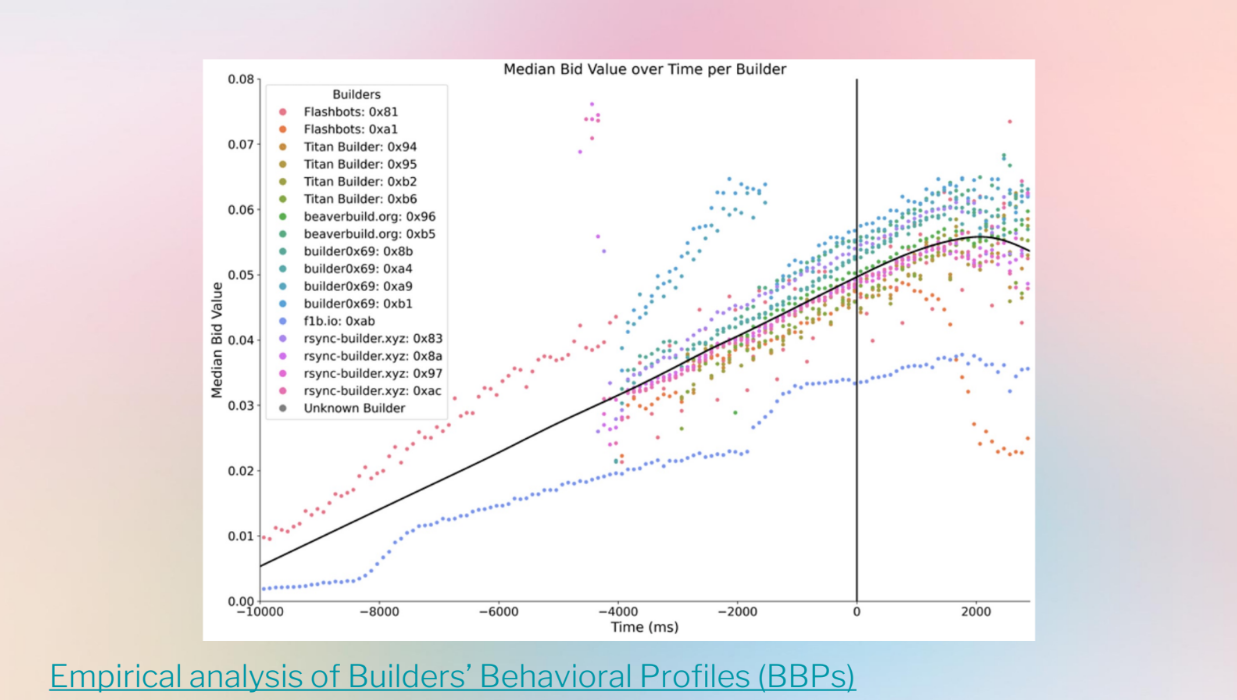

- Les données d'enchères montrent des stratégies d'enchères désordonnées et variables entre les constructeurs.

Goals (2:30)

Robust Incentives Group va parler des recherches sur la modélisation théorique de PBS pour comprendre les dynamiques à long terme, et pas seulement les données actuelles désordonnées. Ils examinent :

- Comment la latence des enchérisseurs (Bidders) affecte les profits et les revenus des enchères

- Les stratégies d'enchérisseurs sans modéliser la centralisation ou les risques d'inventaire.

L'objectif est d'améliorer les enchères PBS comme MEV-Boost en modélisant de manière dynamique les comportements des enchérisseurs. Cela pourrait aider à rendre l'accès au MEV plus égal et décentralisé à long terme.

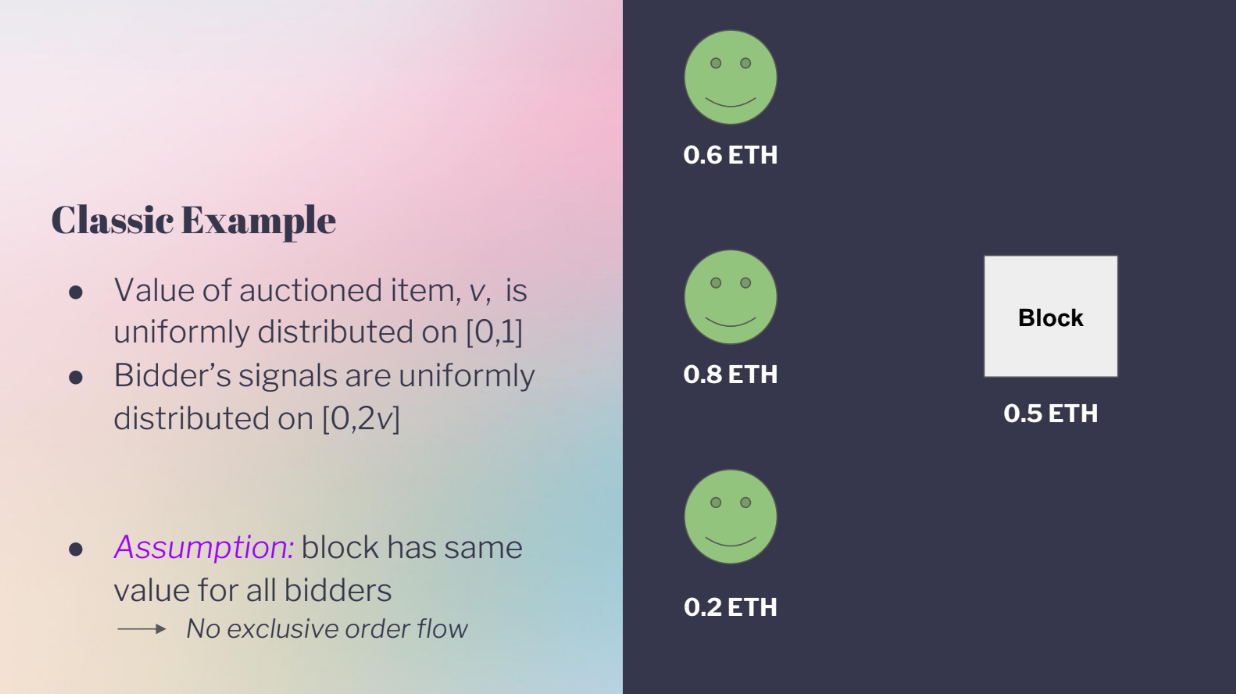

Exemple classique (3:10)

L'exemple classique est le suivant :

- Il y a un article aux enchères.

- Tous les enchérisseurs s'accordent sur la valeur de l'article, mais ne connaissent pas la valeur exacte.

- Chaque enchérisseur obtient un "signal" (ou une estimation) de ce que pourrait être la valeur.

- Certains enchérisseurs pourraient surestimer ou sous-estimer la valeur réelle.

Cela modélise une enchère PBS où les constructeurs enchérissent pour le MEV dans un bloc, car la valeur MEV réelle est inconnue pendant l'enchère, et les constructeurs ont des estimations différentes de ce qu'un bloc vaudra.

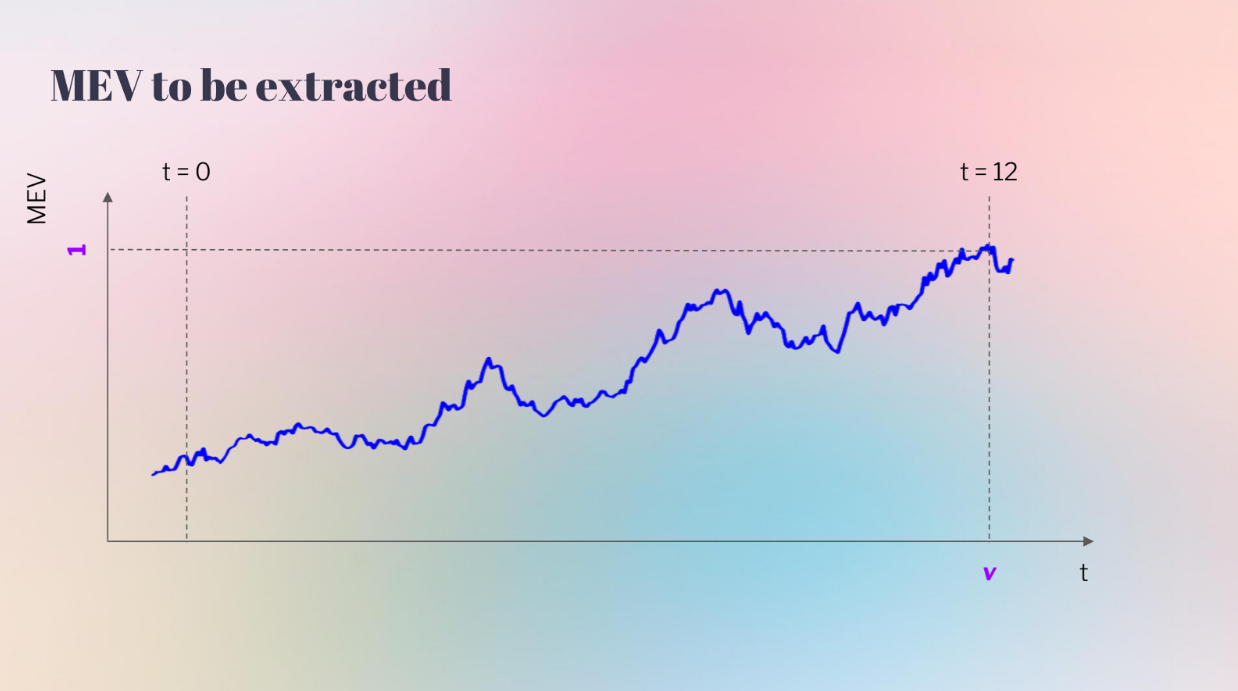

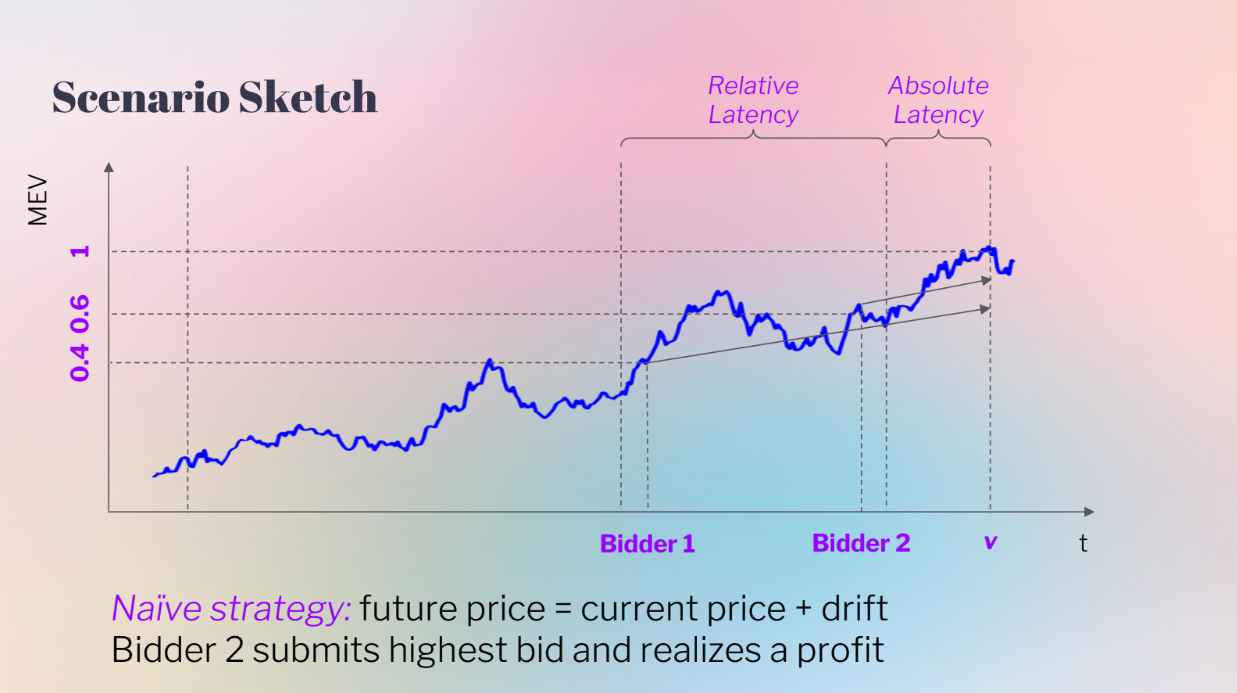

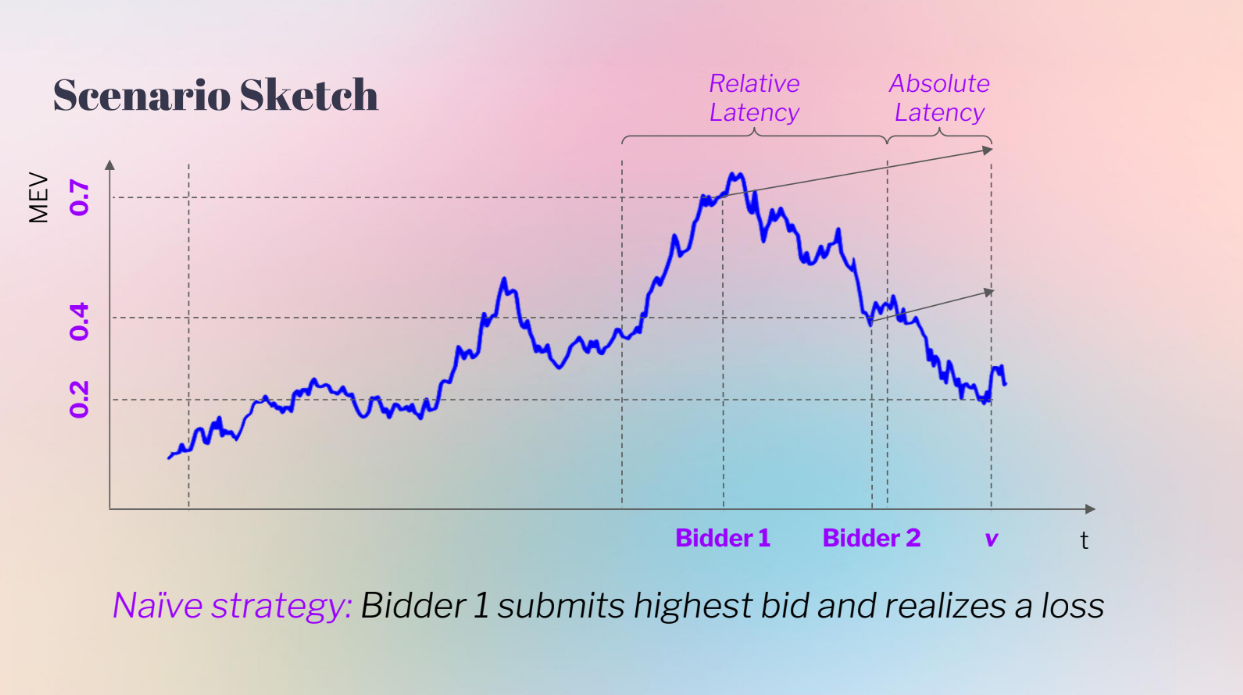

Mais ce modèle n'inclut pas la latence des enchérisseurs. Un modèle plus réaliste montre la valeur MEV qui évolue tout au long du temps de bloc :

- Au début (t0) la valeur MEV est incertaine

- À la fin (t12) la valeur réelle est connue (on choisit t12 car le temps de bloc d'Ethereum est de 12 secondes)

- Les enchérisseurs plus rapides peuvent attendre plus longtemps pour enchérir, plus près de la vraie valeur.

Ainsi, l'enchérisseur 2 qui peut enchérir plus tard (latence inférieure) a un avantage sur l'enchérisseur 1 qui doit enchérir plus tôt avec plus d'incertitude. Cela se traduit par des profits plus élevés pour les enchérisseurs à faible latence.

Processus stochastique des prix (5:00)

La valeur MEV change au hasard au fil du temps, comme un processus stochastique. Elle peut augmenter en raison de plus de transactions entrantes, et peut diminuer en raison de facteurs externes comme l'évolution des prix.

C'est différent d'un modèle d'enchère classique où la valeur mise aux enchères est fixe et les enchérisseurs obtiennent des signaux conditionnés sur cette valeur fixe.

Différences avec l'exemple classique (5:30)

- Les signaux ne sont pas conditionnels à la valeur.

- La distribution de la valeur dépend du signal de chaque enchérisseur. Les enchérisseurs à faible latence ont plus confiance dans leurs signaux, les enchérisseurs à latence élevée ont des intervalles de confiance plus larges.

- Les enchérisseurs obtiennent deux signaux : le dernier prix de la MEV observé et leur propre latence.

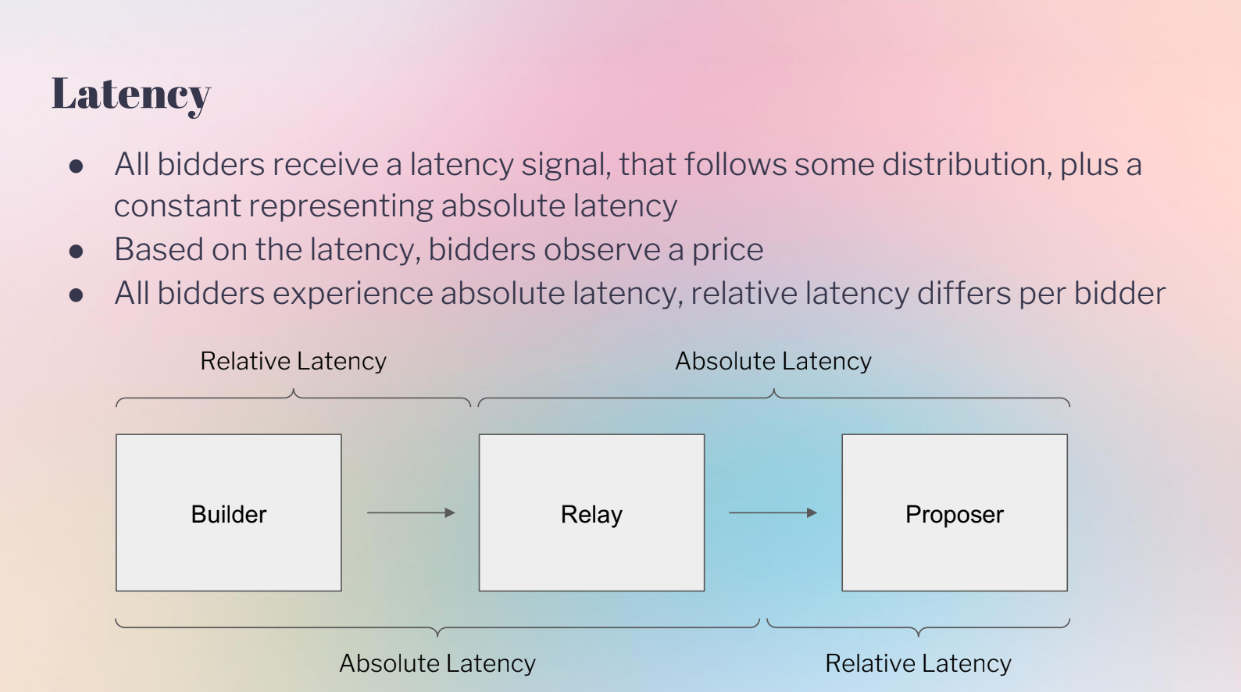

Latency (6:25)

Le modèle considère deux types de latence :

- Latence absolue : Affecte tous les enchérisseurs de manière égale, comme la vitesse du réseau.

- Latence relative : Avantage certains enchérisseurs par rapport à d'autres, comme la colocalisation.

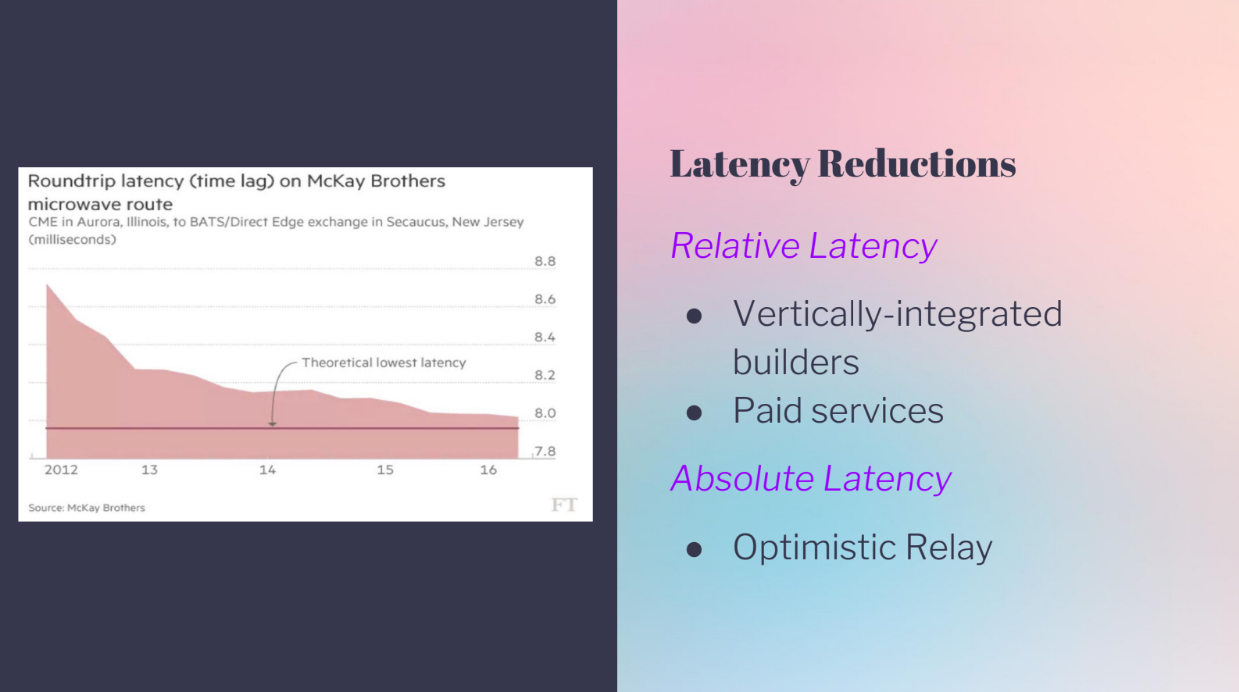

Ce que nous voyons maintenant, c'est qu'il y a beaucoup de réductions de latence :

- Un réseau de relais a plus de latence absolue.

- Les constructeurs intégrés ont des avantages de latence relative.

- Le relais optimiste améliore la latence absolue pour tous.

Dans le PBS Ethereum, même la latence absolue minimale pourrait être beaucoup améliorée par de meilleurs systèmes, et de nombreuses réductions de latence récentes aident certains enchérisseurs par rapport à d'autres. Donc, modéliser à la fois la latence absolue et relative est important pour comprendre les avantages des enchérisseurs.

Comportement des enchérisseurs, avec latence absolue et relative (8:15)

Le modèle considère la latence absolue et relative :

- Latence absolue : Affecte tous les enchérisseurs de manière égale à la fin.

- Latence relative : Avantage antérieur pour l'enchérisseur 2.

- Les enchérisseurs utilisent une stratégie d'enchères naïve : ils observent le prix MEV actuel, et l'enchère = prix actuel + changement prévu.

À gauche, l'enchérisseur 2 voit un prix actuel plus élevé, donc l'enchérisseur 2 enchérit plus haut et gagne.

À droite, l'enchérisseur 1 voit un prix actuel beaucoup plus élevé. L'enchérisseur 1 enchérit très haut sur la base de son attente mais la valeur réelle finit beaucoup plus basse, donc l'avantage de latence de l'enchérisseur 2 évite la surenchère.

En d'autres termes, avoir moins d'informations signifiait que l'enchérisseur 2 a réalisé plus de bénéfices en enchérissant moins.

Les enchérisseurs peuvent-ils mieux faire ? (10:30)

L'enchérisseur 1 peut améliorer sa stratégie en tenant compte de la « malédiction du gagnant » :

La malédiction du gagnant fait référence à la situation où gagner l'enchère signifie qu'on a probablement misé plus qu'on aurait du, parce que vos informations étaient incomplètes par rapport aux enchérisseurs perdants plus pessimistes. Les gagnants doivent en tenir compte dans leur stratégie d'enchères.

- Si vous gagnez, cela signifie que les autres enchérisseurs avaient des infos moins bonnes

- Donc gagner signifie que vos informations étaient probablement surestimées.

- L'enchérisseur 1 peut ajuster son offre à la baisse pour tenir compte de cela.

Implications pour PBS (11:15)

Des enchères plus stratégiques peuvent être nécessaires dans les enchères PBS. Une latence relative plus faible réduit ces coûts de sélection adverse, et une latence absolue plus faible réduit également les coûts.

Application aux enchères de flux d'ordres (12:45)

Les enchérisseurs sont en concurrence pour les opportunités d'arbitrage au fil du temps, et ils sont toujours confrontés à la malédiction du gagnant en fonction de leur latence.

Les plateformes d'échange décentralisées paient une partie des revenus aux enchérisseurs pour tenir compte de leurs coûts de sélection adverse.

Donc modéliser la malédiction du gagnant et les avantages de latence est important pour comprendre les stratégies des enchérisseurs et les revenus dans les enchères MEV.

Conclusion (13:30)

Dans les enchères PBS, les avantages de latence affectent les stratégies des enchérisseurs et les revenus comme une épée à double tranchant : Cela vous aide à remporter des enchères, mais gagner avec une latence élevée signifie que vous avez probablement surenchéri.

Les enchérisseurs doivent équilibrer les optimisations de latence avec des enchères stratégiques pour tenir compte de la malédiction du gagnant. De plus, un accès équitable aux améliorations de latence peut profiter à l'ensemble de l'enchère PBS.

FAQ

Outre l'arbitrage, quels autres facteurs externes affectent les offres MEV à la baisse ? (15:00)

Pour l'instant, l'arbitrage est le plus gros facteur. À l'avenir, d'autres types de MEV pourraient devenir plus importants à mesure que les mécanismes PBS évoluent.

En quoi l'offre groupée scellée diffère-t-elle de l'enchère ouverte PBS en termes d'implications de la malédiction du gagnant ? (15:45)

Le modèle examine les évaluations des enchérisseurs indépendamment des offres ouvertes ou scellées. Dans les deux cas, les enchérisseurs doivent tenir compte du risque que d'autres enchérissent après eux.

Pouvez-vous expliquer plus en détail comment une latence inférieure conduit à une sélection adverse ? (17:00)

Si vous enchérissez tôt (latence élevée) et gagnez, cela signifie qu'un enchérisseur ultérieur a vu des informations qui l'ont poussé à moins enchérir. Donc, gagner signifie que vous avez probablement misé plus que de raison par manque d'infos.

L'avantage de l'enchérisseur ultérieur entraîne des coûts de sélection adverse pour le gagnant à latence supérieure.

Intro (0:00)

Traditionnellement, la résistance à la censure signifiait que les transactions valides finissaient par être ajoutées à la blockchain. Mais pour certaines transactions comme celles des oracles ou des arbitragistes, l'inclusion éventuelle ne suffit pas - elles doivent arriver rapidement sur la chaîne pour être utiles.

Mallesh argue que nous avons besoin d'une nouvelle définition de la résistance à la censure : une qui garantit l'inclusion en temps opportun des transactions, pas seulement l'inclusion éventuelle. Cela permettrait de nouveaux mécanismes comme les enchères on-chain. Cela pourrait aussi aider les rollups et améliorer les protocoles de blockchain en général.

Vitalik en a déjà parlé en 2015, mais Mallesh préconise que la communauté revisite le sujet maintenant, car l'inclusion opportune des transactions débloque de nouvelles capacités.

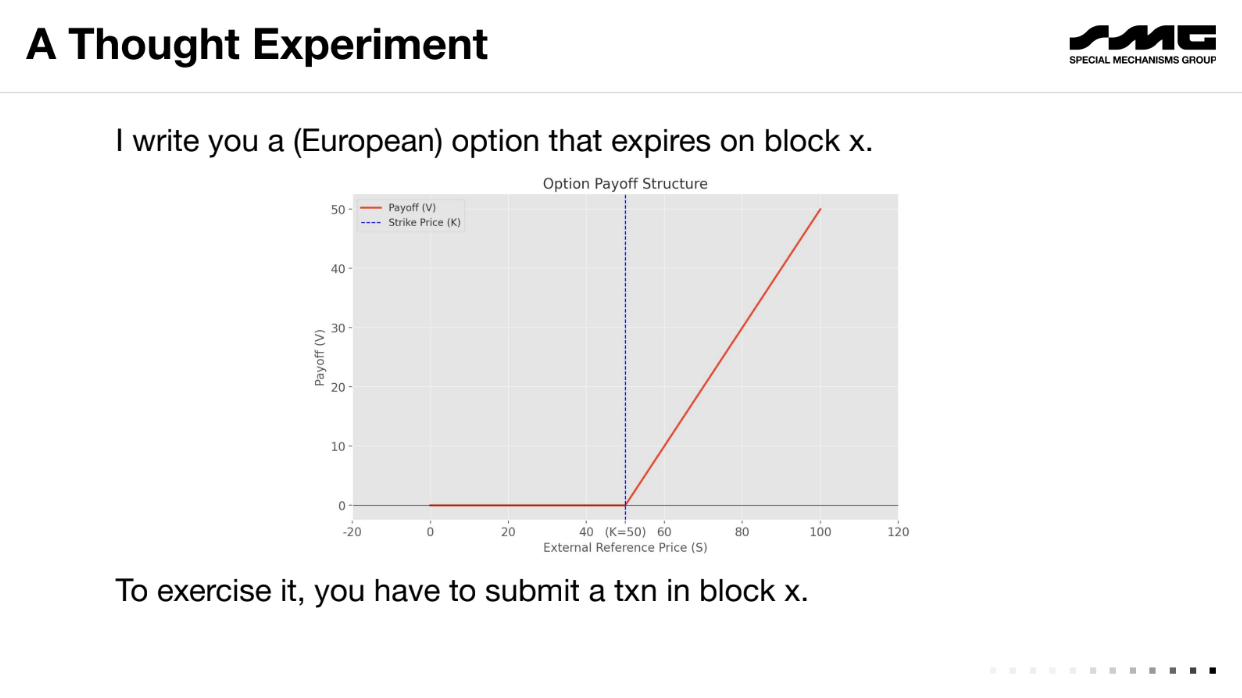

Une expérience de pensée (2:30)

Prenons l'exemple d'une "option européenne", un contrat financier où un utilisateur accepte de payer la différence entre un prix de référence (disons 50$) et le prix du marché d'un actif à une date future (bloc X), si le prix du marché est plus élevé.

Au bloc X, si le prix est de 60$, l'utilisateur doit au détenteur 10$ (la différence entre le prix au bloc X et le prix de référence). Le détenteur serait prêt à payer jusqu'à 10$ pour faire inclure la transaction dans la blockchain afin d'exercer l'option. Mais l'utilisateur a également intérêt à payer jusqu'à 10$ pour censurer la transaction et éviter de payer.

À la date d'expiration, il y a une incitation pour les deux parties à payer des frais élevés soit pour exécuter soit pour censurer la transaction. Cela crée une enchère implicite pour l'espace dans le bloc où la transaction finira par aller à celui qui est prêt à payer plus en frais.

Le côté obscur du PBS (4:20)

Le modèle d'enchère de frais existant permet la censure. En payant des frais élevés, vous pouvez bloquer des transactions valides sans que les autres le sachent.

Ce n'est pas seulement théorique, car le Special Mechanisms Group a démontré le problème quelques semaines avant la présentation : en achetant un bloc qui ne contenait que leur propre transaction promotionnelle, ils auraient pu censurer silencieusement les autres en incluant certaines transactions valides mais pas toutes.

Les problèmes clés :

- Les options et autres transactions DeFi sensibles au temps créent des incitations pour que les participants s'engagent dans des guerres d'enchères de blocage/censure. Cela extrait de la valeur plutôt que d'en créer.

- Le modèle d'enchère de frais existant permet l'extraction de valeur par le biais d'une censure silencieuse en omettant des transactions sans que cela soit visible.

Définition économique de la résistance à la censure (5:50)

Mallesh introduit le concept de "tableau d'affichage public" pour modéliser abstraitement la résistance à la censure de la blockchain. Ce modèle a deux opérations :

- Lire : Toujours réussi, pas de coût. Vous permet de lire le contenu du tableau.

- Écrire : Prend des données et un pourboire "t". Réussi et coûte t, ou échoue et ne coûte rien.

La résistance à la censure est définie comme une fonction de frais, c'est-à-dire le coût pour un censeur de faire échouer une écriture. Des frais plus élevés indiquent une plus grande résistance.

Quelques exemples (7:45)

- Bloc désigné unique : Le frais de censure est d'environ t. Un censeur peut surenchérir le pourboire de transaction pour le bloquer.

- EIP-1559 : Résistance potentiellement pire puisque les frais de base sont brûlés. Le censeur n'a besoin que de surenchérir t-b où b est le frais de base.

L'objectif est d'atteindre des frais de censure élevés quelle que soit la valeur de t, grâce à une meilleure conception de blockchain, comme des emplacements consécutifs multiples.

Meilleure résistance à la censure (9:15)

Avoir plusieurs créneaux consécutifs avec différents producteurs augmente les frais de censure.

Un censeur doit payer chaque producteur pour bloquer une transaction, ce qui coûte k*t pour k créneaux au pourboire t. Mais cela augmente également la latence de lecture - on doit attendre k blocs.

Enchères On-Chain (10:45)

Une faible résistance à la censure limite les mécanismes on-chain comme les enchères. Par exemple, considérons une enchère au deuxième prix en 1 bloc avec N+1 enchérisseurs :

- Les enchérisseurs 1 à N sont honnêtes, soumettent des offres b_i et des pourboires t_i

- L'enchérisseur 0 est un censeur. Il attend les offres, fais une offre de censure au producteur p pour exclure certaines offres.

- Le producteur voit toutes les offres/pourboires, et l'offre de censure p. Il décide quelles transactions inclure.

- L'enchère s'exécute sur les offres incluses.

Un censeur peut perturber l'enchère en bloquant les offres. Cela exploite la faible résistance à la censure d'un seul bloc.

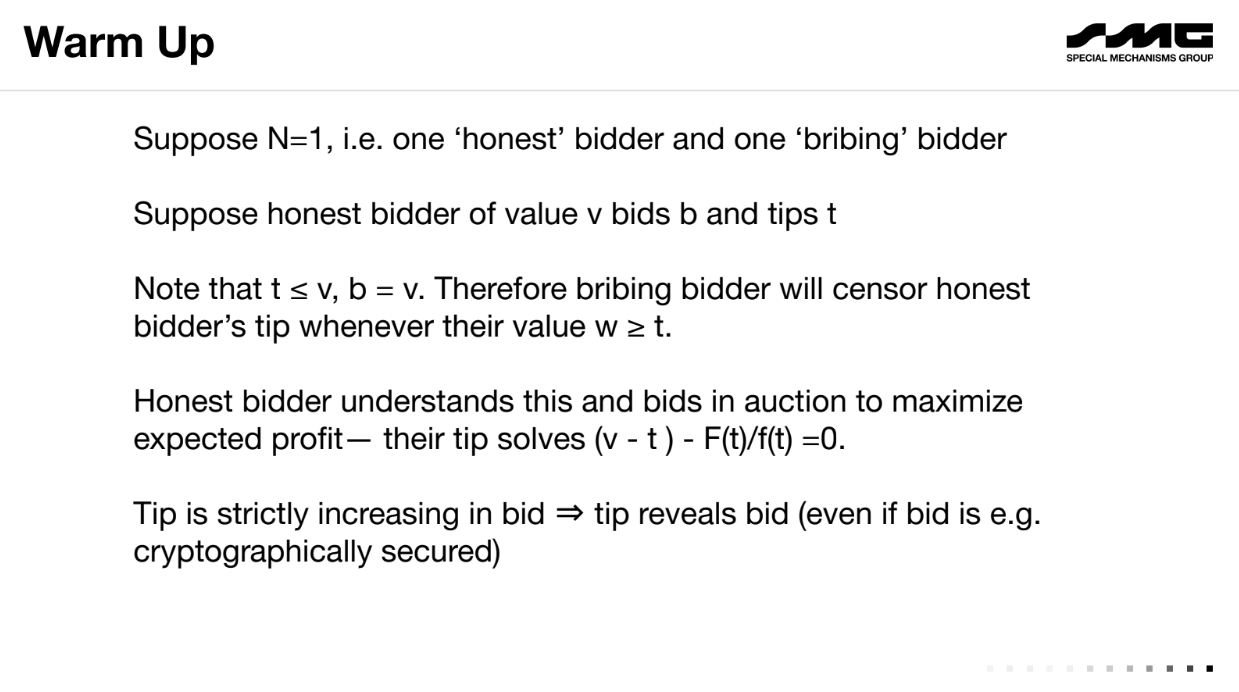

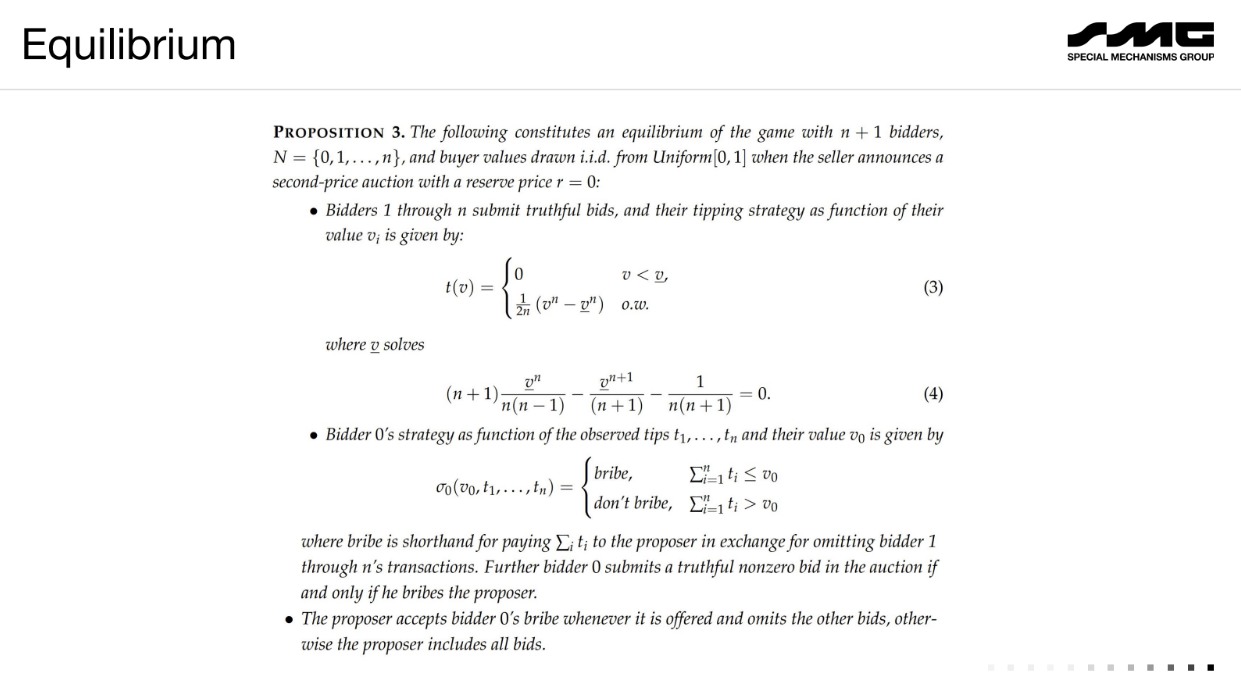

Échauffement (13:50)

Supposons une enchère au deuxième prix avec seulement 1 enchérisseur honnête et 1 enchérisseur censeur :

- L'enchérisseur honnête mise sa valeur v. Son pourboire t doit être < v, sinon il paie trop même s'il gagne.

- Le censeur voit que t est inférieur à v, donc il censurera à chaque fois que sa valeur w > t. Il paie légèrement plus que t au producteur pour exclure l'offre de l'enchérisseur honnête.

- Sachant cela, l'enchérisseur honnête choisit t pour maximiser son profit, résultant en une formule reliant t à v.

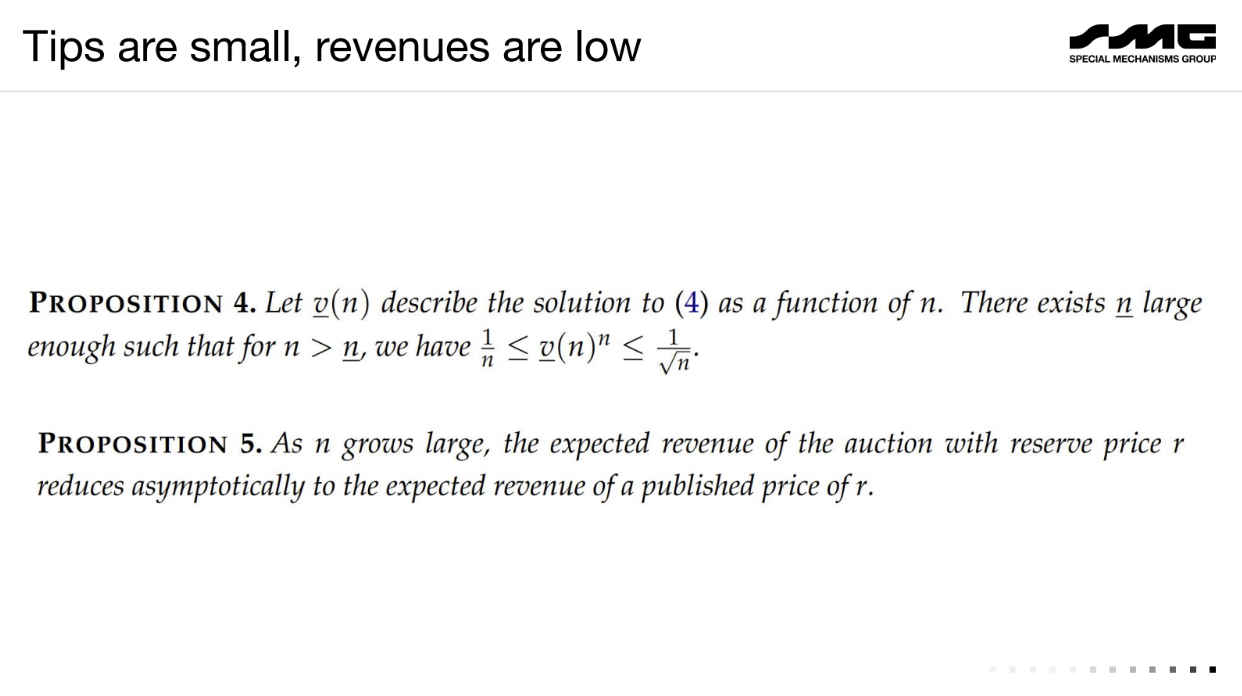

Avec N+1 enchérisseurs :

Les enchérisseurs honnêtes enchérissent leur valeur mais ont un faible pourboire en raison du risque de censure. Le censeur trouve souvent profitable d'exclure toutes les autres offres et de gagner gratuitement.

En conséquence, le revenu de l'enchère s'effondre : le censeur obtient l'article à bas prix. S'il y a plusieurs censeurs, le producteur qui dirige l'enchère extrait la plupart de la valeur.

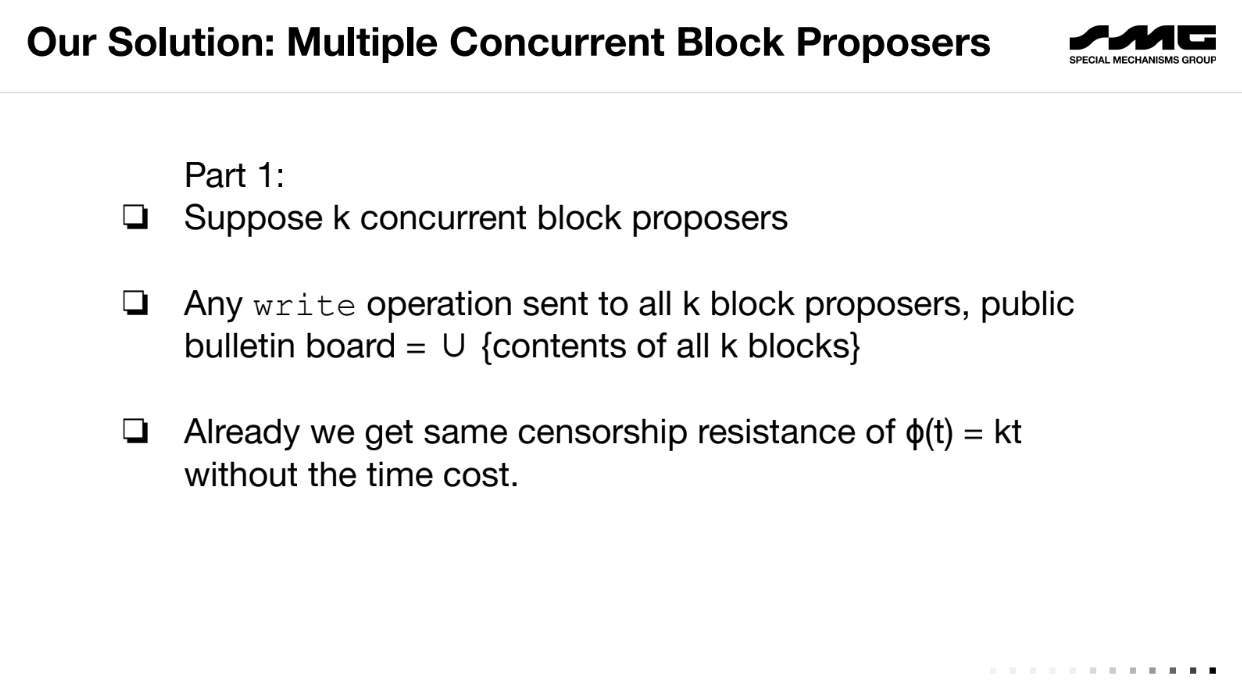

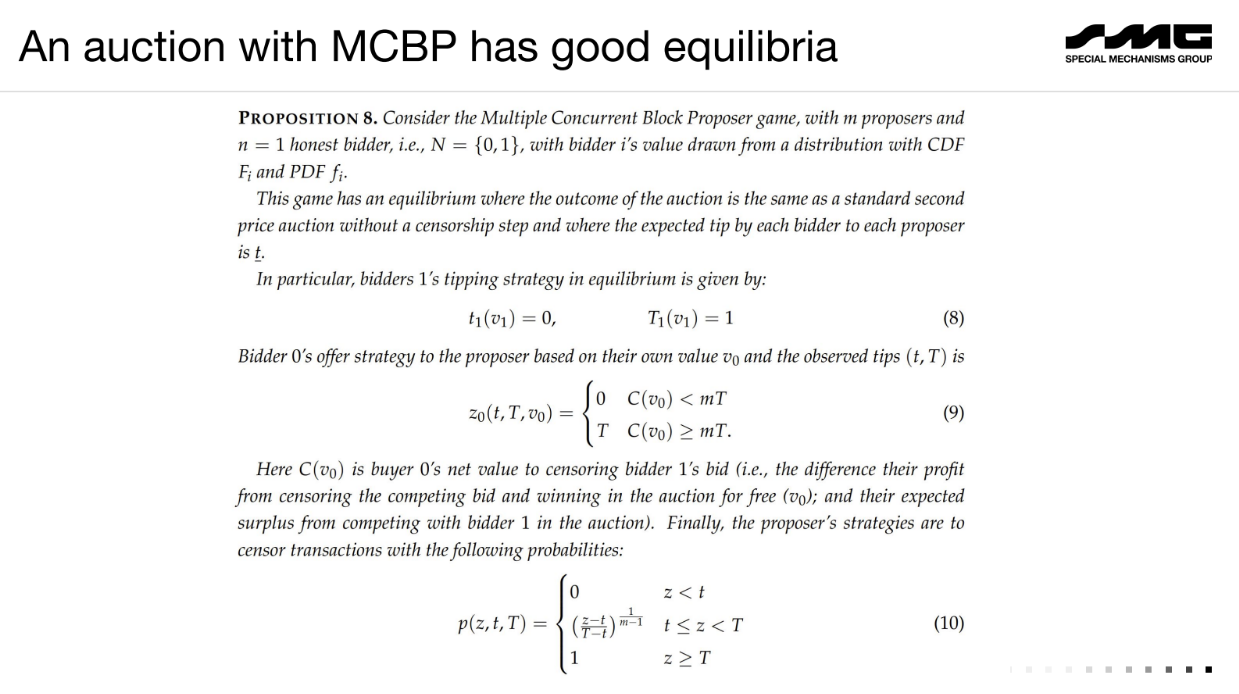

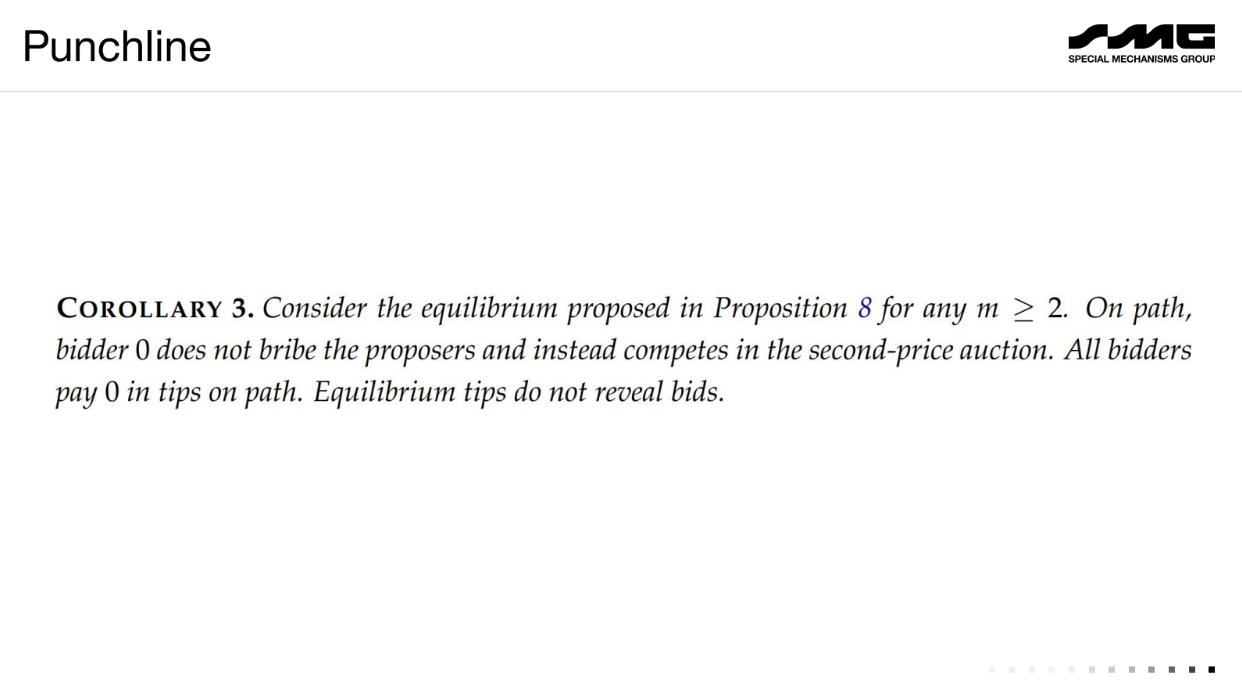

Solution proposée : Plusieurs proposants de blocs concurrents (18:00)

Mallesh propose une solution au problème de censure de la blockchain en utilisant plusieurs producteurs de blocs concurrents plutôt qu'un producteur monopoliste.

Avoir k producteurs de blocs qui peuvent tous soumettre des blocs simultanément. La blockchain contient l'union de tous les blocs.

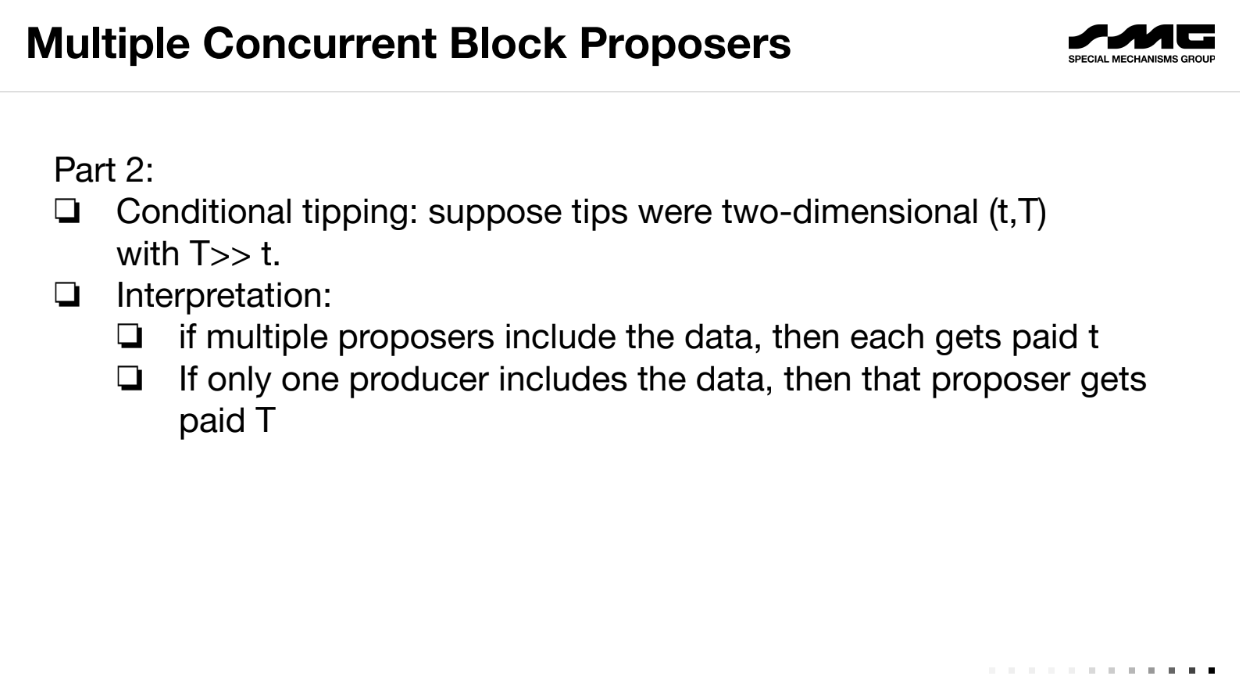

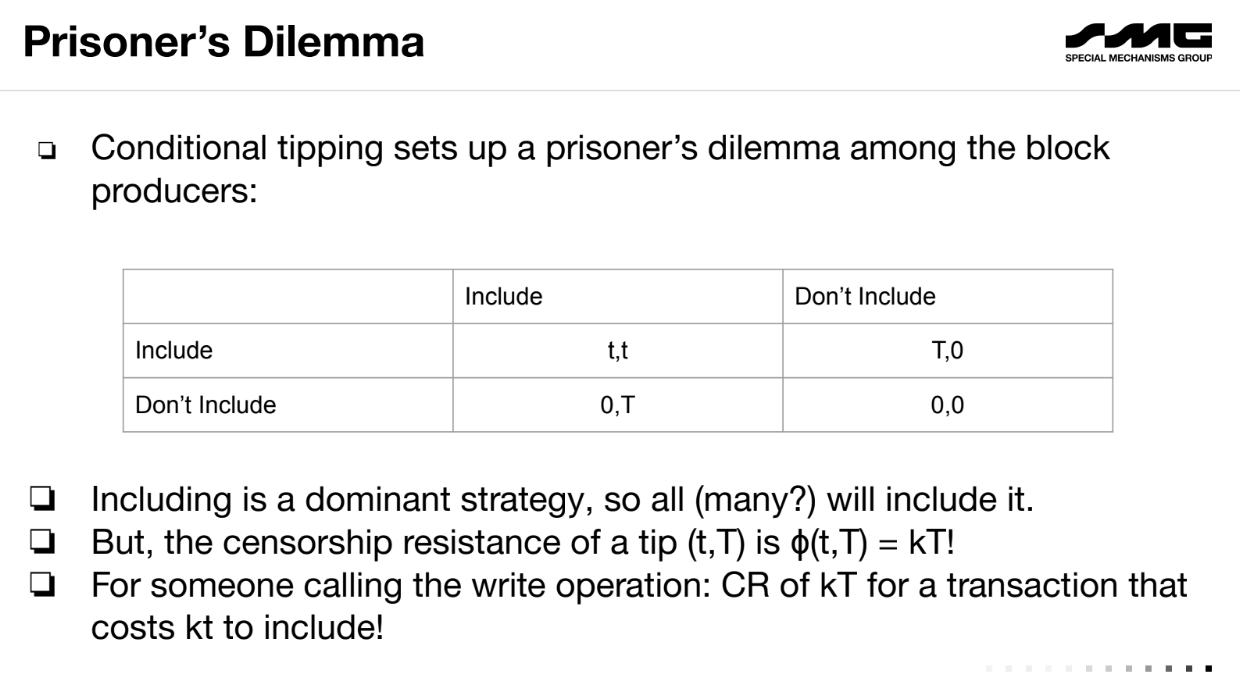

Les pourboires sont conditionnels : petit pourboire t si inclus par plusieurs producteurs, gros pourboire T si inclus par un seul.

Cela crée un "dilemme du prisonnier" pour les producteurs - inclure est une stratégie dominante pour obtenir plus de pourboires.

Le coût de l'inclusion est faible (kt) mais la résistance à la censure est élevée (kT) avec le bon t et T. Par conséquent, un censeur trouve que soudoyer tous les producteurs est trop cher et les enchérisseurs honnêtes peuvent participer équitablement.

Réflexions finales (20:20)

Avantages :

- Supprime le pouvoir monopolistique du producteur sur la censure.

- Réduit les exigences de pourboire pour l'inclusion.

- Permet plus de mécanismes on-chain comme les enchères résistant aux attaques de censure.

Mais la communauté doit réfléchir à ce qu'elle veut adopter/prioriser/optimiser.

FAQ

Que se passe-t-il si les multiples producteurs de blocs se concertent off-chain pour n'en avoir qu'un seul qui inclut une transaction, et partagent le gros pourboire ? (22:00)

Empêcher la collusion est difficile. Cette approche suppose que les producteurs suivent des stratégies dominantes, pas de collusion. La collusion est un problème même avec des producteurs uniques.

Pour faire des pourboires conditionnels, vous devez voir d'autres propositions on-chain. Cela ne crée-t-il pas un problème de censure pour ces données ? (22:45)

Les pourboires peuvent être traités dans le bloc suivant en utilisant les informations de tous les flux de proposition du tour précédent. Les propositions seraient une connaissance commune on-chain

Avoir plusieurs propositions fait perdre l'efficacité de l'ordonnancement des transactions. Comment abordez-vous cela ? (24:30)

Cette approche est optimale pour les mécanismes insensibles à l'ordre comme les enchères. Il faut plus de recherche sur l'ordre avec plusieurs flux.

Pouvez-vous vraiment garantir l'exercice d'une option on-chain étant donné des ressources blockchain limitées ? (26:00)

Il y aura toujours des limites liées à la congestion d'un réseau. Mais l'économie change - les frais de transaction sont basés sur la valeur, pas sur le coût de l'espace dans le bloc. Cela améliore mais ne résout pas complètement les garanties.

Quintus veut apporter une nouvelle perspective sur la façon de penser le "MEV" ou "maximum extractable value" dans les systèmes de blockchain comme Ethereum.

Pour comprendre les solutions potentielles, nous devons d'abord comprendre la source fondamentale de l'injustice et de l'inefficacité.

C'est une vision centrée sur Ethereum, mais il pense que les points s'appliquent aussi à d'autres systèmes de blockchain.

Les problèmes de la MEV (1:10)

- Asymétrie de pouvoir : Les mineurs/validateurs gagnent beaucoup d'argent des activités MEV alors que les utilisateurs réguliers n'en gagnent pas. Certains voient cela comme injuste.

- Inefficacité économique : Certaines activités MEV imposent des "taxes" supplémentaires aux utilisateurs, rendant les échanges plus chers.

- Inefficacité technique : Le MEV peut provoquer des problèmes comme des transactions échouées, des messages de protocole supplémentaires et des rendements inégaux des validateurs. Cela conduit à des problèmes techniques comme des incitations à reorganiser et à centraliser.

- Partage des revenus : Les applications veulent capturer une partie de la valeur MEV qu'elles créent, ce qui se rapporte au problème d'équité.

Quintus veut se concentrer principalement sur les problèmes d'asymétrie de pouvoir et d'inefficacité économique dans cet exposé.

Asymétrie informationnelle

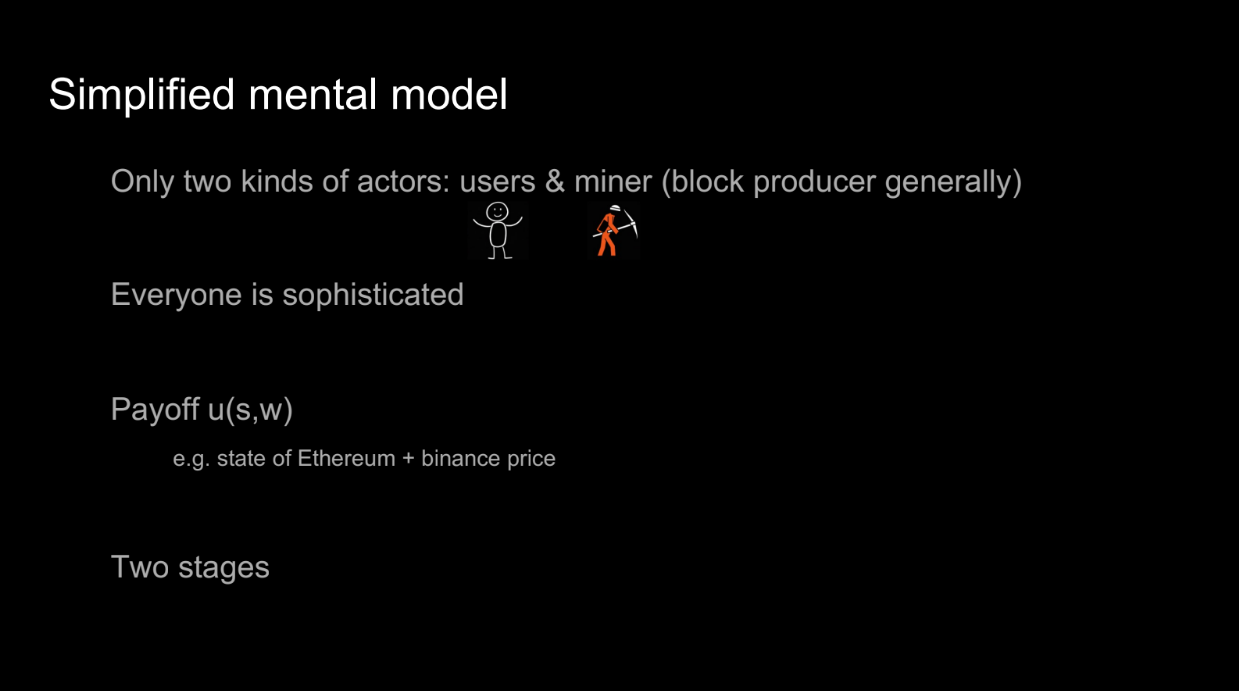

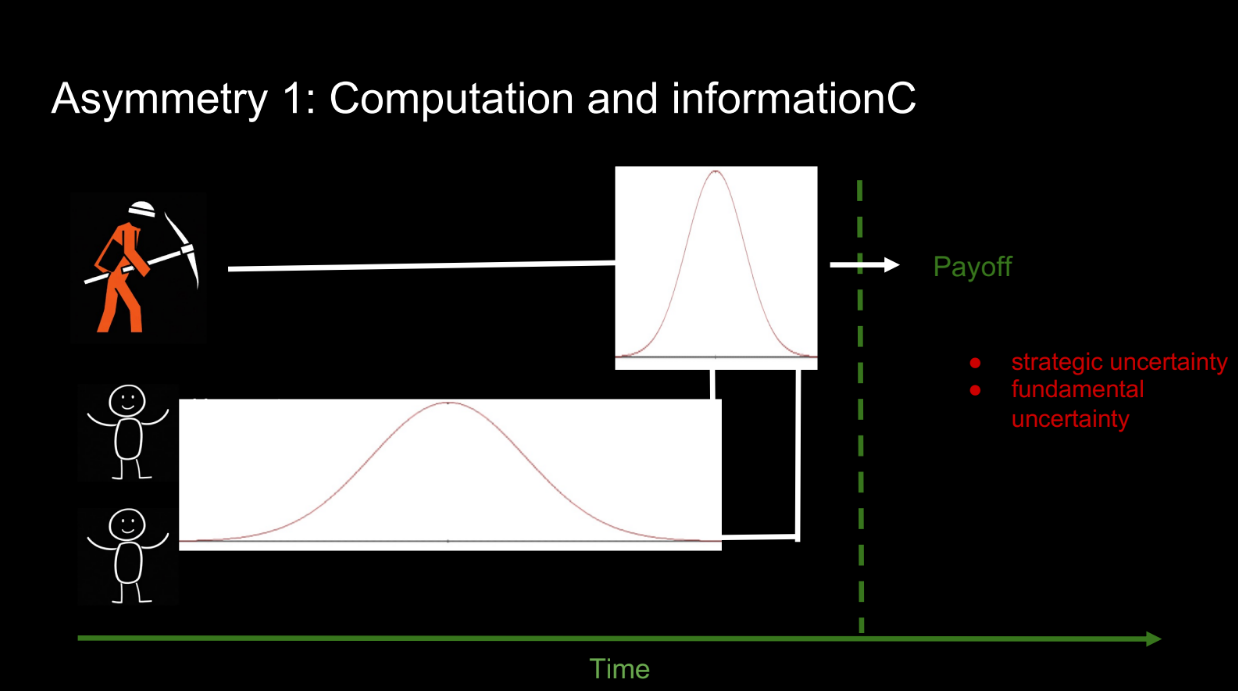

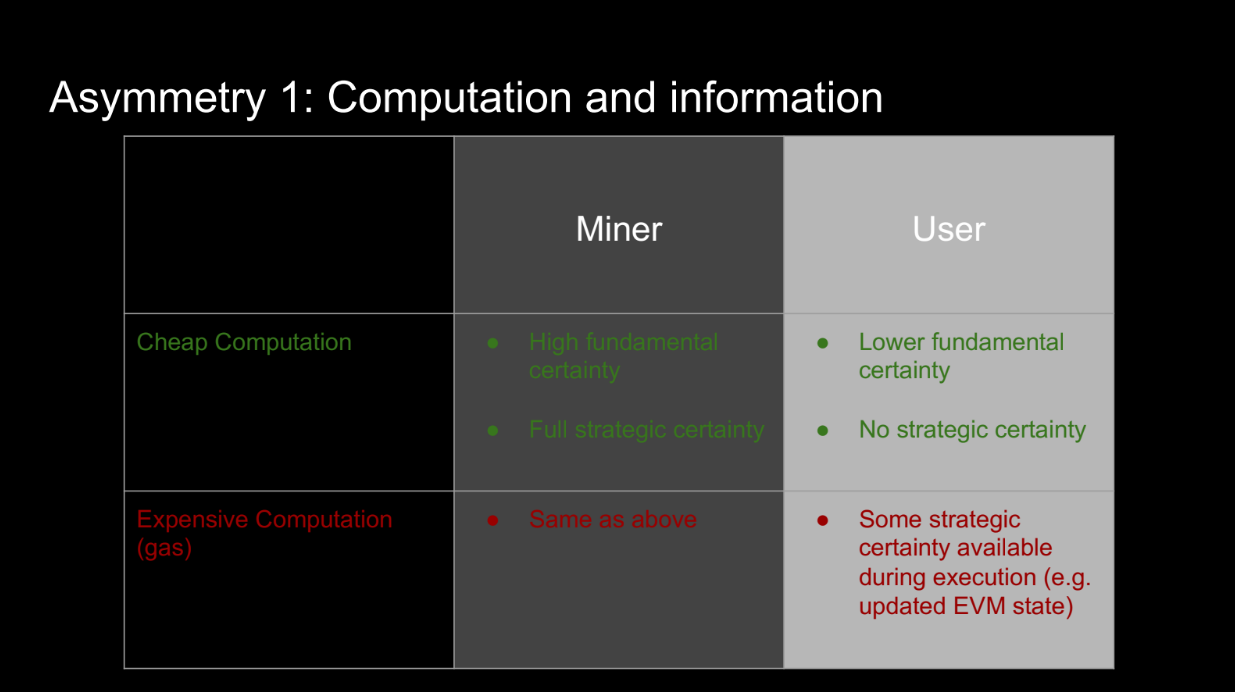

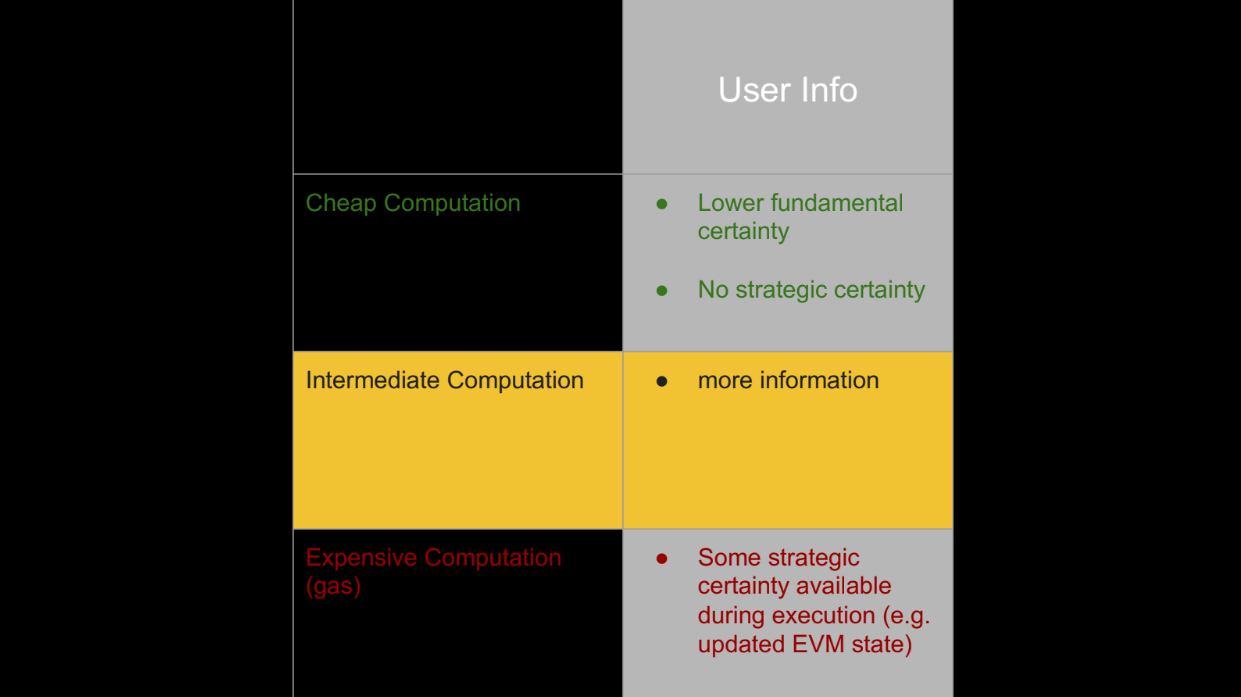

Calcul et information (2:30)

Quintus veut expliquer le problème fondamental derrière l'injustice et l'inefficacité de la MEV. Utilisons un modèle simple avec 2 acteurs :

- Le mineur (représente n'importe quel producteur de blocs)

- Les utilisateurs

Les mineurs et les utilisateurs veulent maximiser leurs profits lorsque le prochain bloc est produit. Leurs profits dépendent :

- Du contenu du bloc

- De l'état externe (comme les prix des plateforme d'échange)

Il y a 2 étapes :

- Les utilisateurs soumettent des transactions

- Le mineur ordonne les transactions et produit le bloc

Cela montre une asymétrie :

- Les utilisateurs font face à beaucoup d'incertitude quant aux autres transactions et à l'état externe

- Le mineur a beaucoup moins d'incertitude car il voit toutes les transactions et produit le bloc plus tard

Il existe deux types d'incertitude :

- Stratégique - Ce que font les autres personnes

- Fondamentale - État externe comme les prix

Les utilisateurs ont ces deux incertitudes par rapport au mineur. Cette asymétrie d'information avantage donc le mineur. De plus, le mineur peut effectuer des calculs localement et à bas prix avec des informations complètes, et les utilisateurs doivent payer du gaz pour les calculs avec moins d'informations.

Même si les utilisateurs peuvent effectuer des calculs sur la chaîne, cela est coûteux. La capacité du mineur à effectuer des calculs locaux bon marché avec des informations complètes les avantage encore plus

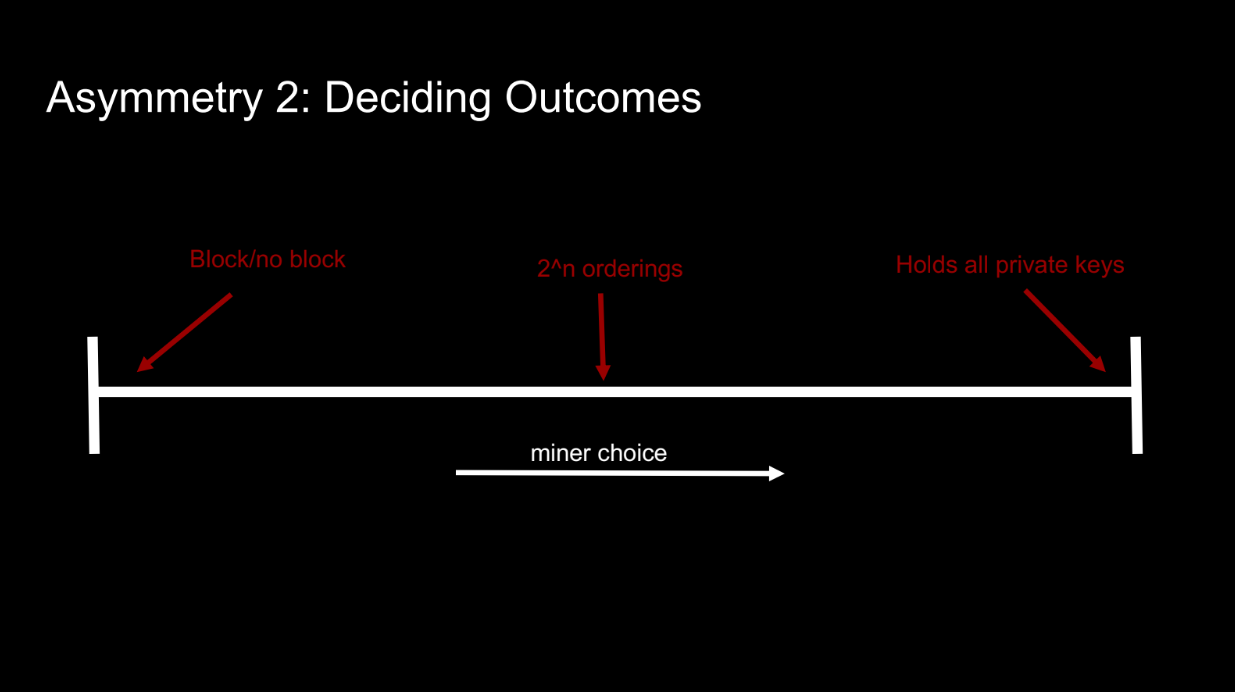

Asymétrie d'information

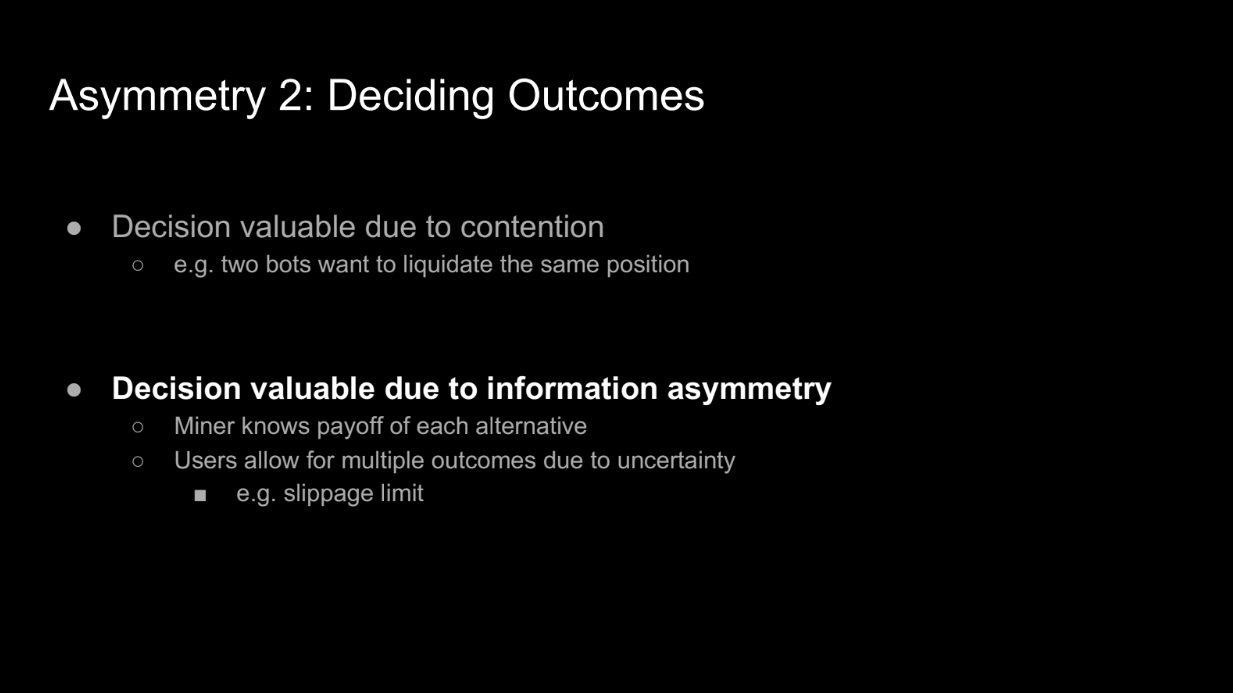

Décider des résultats (5:50)

Une autre asymétrie est la capacité du mineur à choisir entre différents résultats de bloc. Par exemple :

- Produire des blocs vides ou pleins

- Ordonner les transactions différemment

- Contrôler toutes les clés privées (comme un exchange centralisé)

Deux facteurs principaux affectent la valeur de la capacité de prise de décision du mineur :

- La contention fondamentale - des situations comme les opportunités d'arbitrage auxquelles les utilisateurs se disputent l'accès. Le mineur peut décider du gagnant.

- L'asymétrie d'information - Le mineur connaît la valeur de chaque résultat. Mais plus important encore, les utilisateurs manquent d'informations, donc ils envisagent de multiples résultats via des choses comme des limites de glissement. Cela donne au mineur de nombreuses options parmi lesquelles choisir.

Donc l'asymétrie d'information permet la précieuse capacité de prise de décision du mineur. Sans elle, il y aurait moins d'options parmi lesquelles choisir.

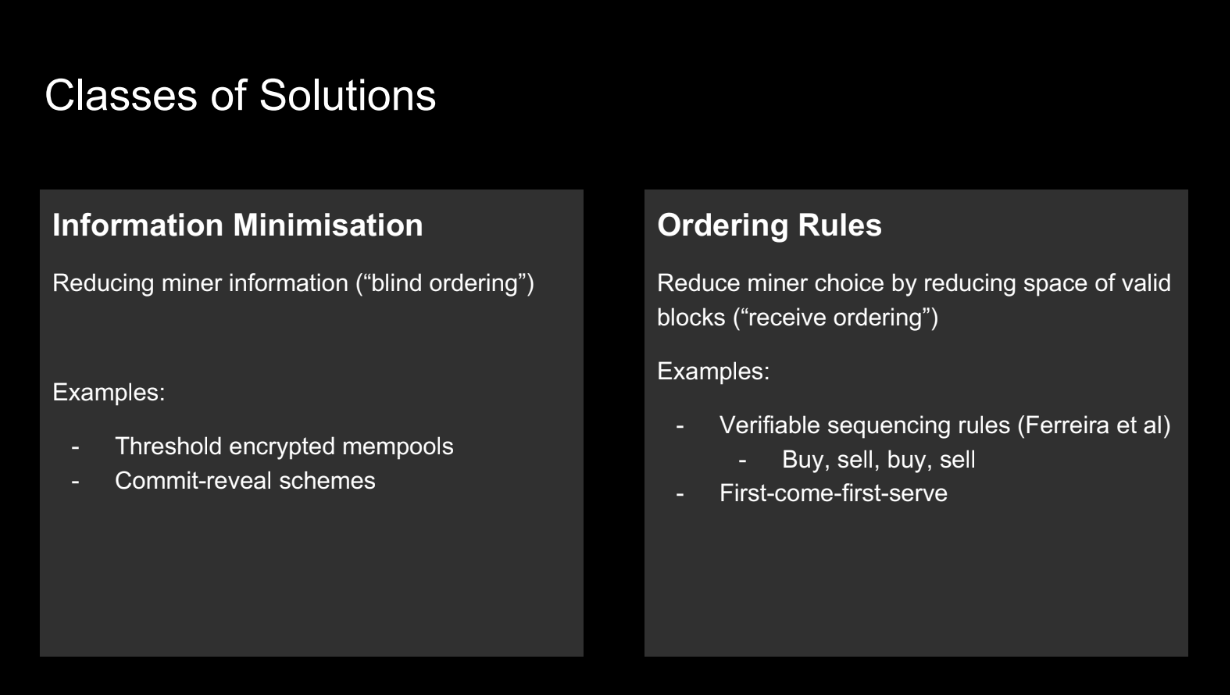

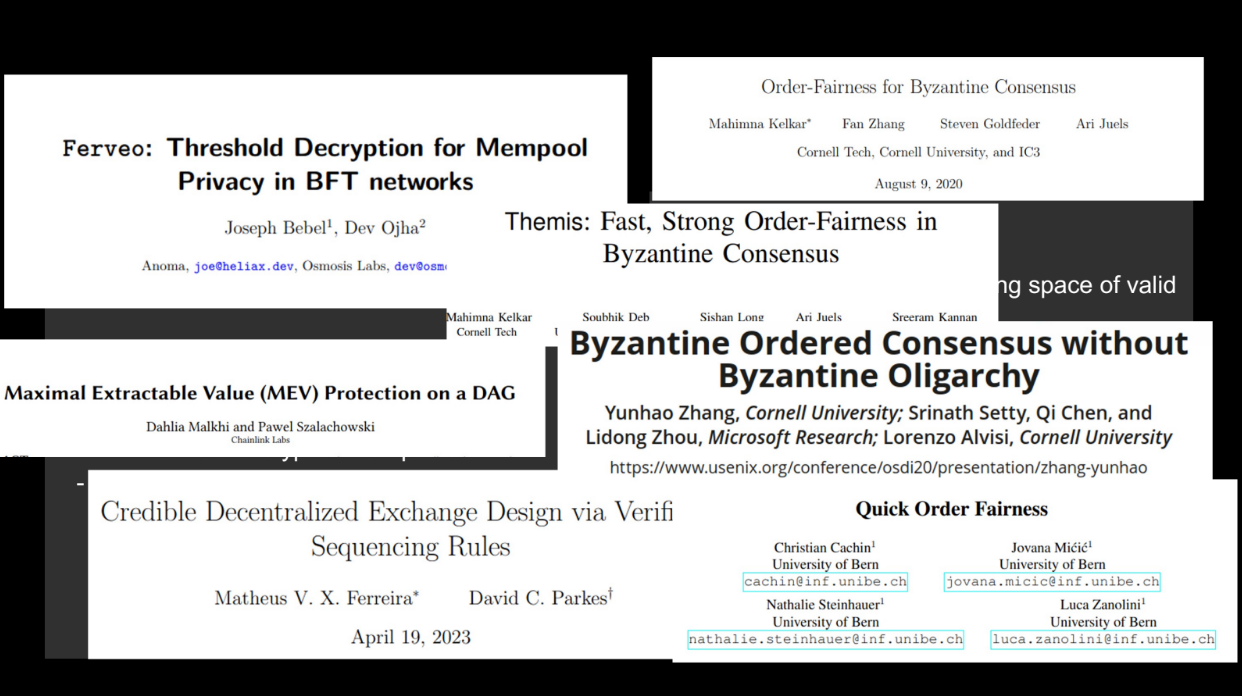

Classes de solutions (8:15)

Les solutions passées à cette asymétrie se sont concentrées sur :

- Minimiser les informations des mineurs - des techniques comme le chiffrement par seuil et les schémas d'engagement-révélation.

- Réduire le choix du mineur - des règles de classement comme le premier arrivé, premier servi qui limitent l'espace de bloc valide.

Donc les principales approches consistaient à minimiser les informations des mineurs et à limiter les choix que les mineurs peuvent faire. Cela visait à remédier à l'asymétrie injuste.

Mais ces solutions passées ne reflètent pas ce qui se passe dans la pratique sur des blockchains comme Ethereum. Au lieu de cela, nous voyons émerger de nombreux services intermédiaires qui donnent aux utilisateurs plus d'informations et de capacités de calcul.

Calcul Intermédiaire

Donc une approche différente est nécessaire, améliorant les capacités des utilisateurs plutôt que de simplement limiter les mineurs. Cela permet aux utilisateurs et aux mineurs de mieux concurrencer sur un pied d'égalité.

Plutôt que de réduire les informations/actions du mineur, une nouvelle approche émerge : améliorer les informations des utilisateurs et rendre le calcul moins cher via des services "intermédiaires".

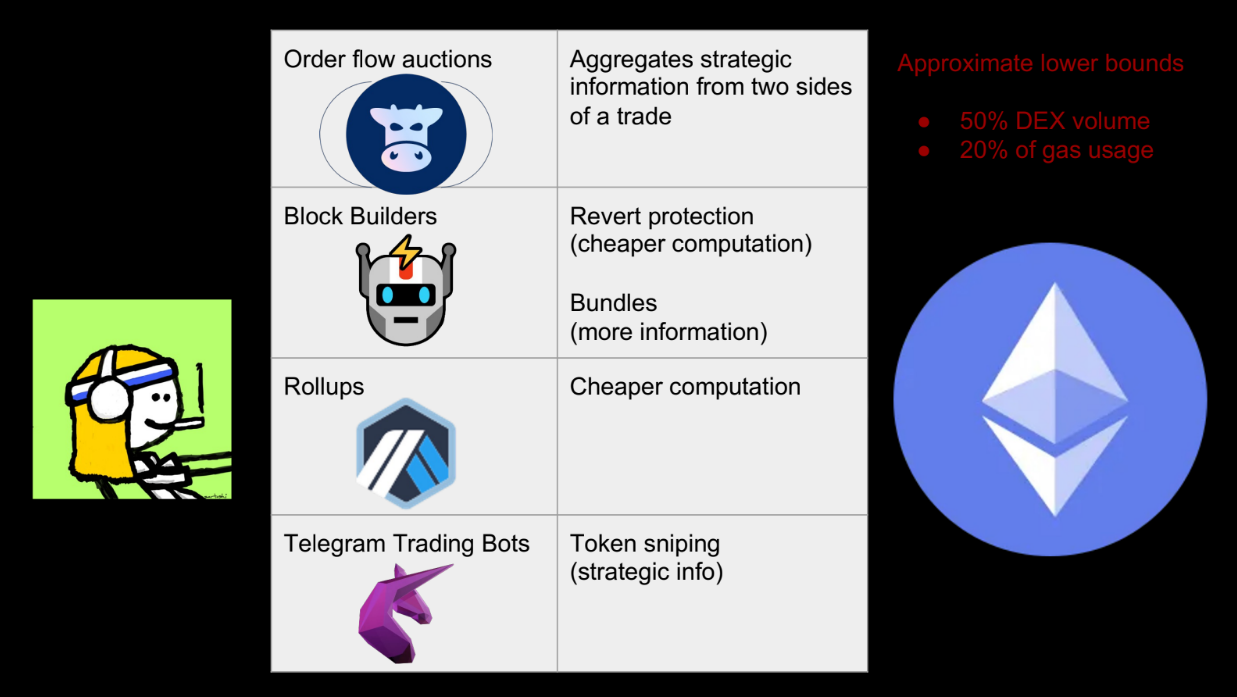

Quelques exemples (9:45)

- Enchères de flux d'ordres (comme CowSwap) : regrouper les ordres hors chaîne pour de meilleurs prix

- Constructeurs de blocs : fournir une protection contre l'annulation afin que les utilisateurs puissent essayer plusieurs échanges

- Bundles : séquencer les transactions pour que les suivantes puissent utiliser les infos des précédentes

- Rollups : moyen moins cher de trouver des échanges optimaux

- Bots Telegram : regrouper les informations des utilisateurs pour les échanges/snipes

Ces services donnent aux utilisateurs plus d'informations et des calculs moins chers. Plus de 50% du volume DEX passe par ces services.

Nouveaux intermédiaires à venir(12:40)

Le modèle de fonctionnement de la blockchain tel qu'on l'imaginait auparavant avec seulement des mineurs et des utilisateurs est limitante. Nous ne pouvons plus penser à seulement deux acteurs.

La pirouette mentale est d'accepter que des intermédiaires émergent entre les mineurs et les utilisateurs. Cela reflète mieux la réalité et le fonctionnement des blockchains dans la pratique.

Nouveaux problèmes

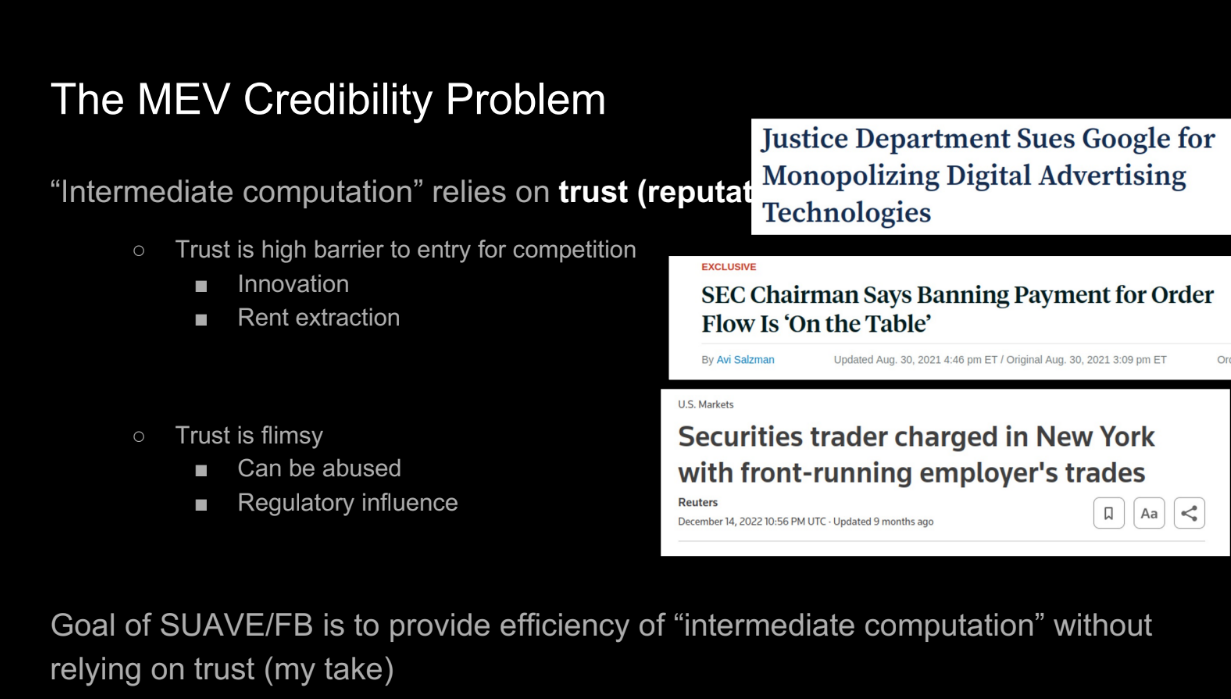

La crédibilité de la MEV (13:10)

Ces services intermédiaires résolvent certains problèmes de MEV, mais ils reposent sur la confiance et la réputation, pas sur la cryptographie. En résolvant certains problèmes, on en a créé d'autres :

- Barrière à l'entrée élevée. Les nouveaux services doivent établir la confiance et la réputation. Moins de concurrence signifie un potentiel de monopoles, d'extraction de rente et de stagnation.

- La confiance est fragile. Elle peut être abusée ou perdue soudainement. Nous voulons des systèmes où les propriétés sont garanties par conception, pas par les décisions des acteurs.

- Les intermédiaires de confiance peuvent encore abuser de leur pouvoir ou être manipulés. Nous voulons du "ne peut pas être malveillant" et non du "ne soit pas malveillant".

Des exemples comme la finance traditionnelle montrent que les intermédiaires de confiance ne suffisent pas à prévenir les abus. L'objectif est l'efficacité grâce aux services intermédiaires, mais avec des propriétés garanties cryptographiquement, pas via la confiance.

Questions ouvertes (16:25)

En résumé, il y a trois questions clés à prendre en compte pour la suite :

- Le problème de crédibilité/confiance : Comment pouvons-nous obtenir les avantages des services intermédiaires sans compter sur la confiance et la réputation ?

- Étudier les asymétries formellement : L'orateur a discuté des asymétries d'information et de calcul de manière informelle. Comment pouvons-nous étudier celles-ci formellement et rigoureusement ?

- Implications pour la conception de blockchain : Si nous supposons que des intermédiaires vont émerger, comment cela change-t-il les propriétés souhaitées de choses comme l'ordonnancement des transactions ? Atteignent-ils encore leurs objectifs visés ?

Quintus espère que cet exposé a inspiré les gens à travailler sur ces problèmes et a fourni une perspective utile sur les intermédiaires et la MEV.

FAQ

Lorsque les intermédiaires sont en concurrence dans les enchères PBS, comment empêchons-nous qu'ils poussent tous les revenus vers le proposeur de bloc (validateur) en se faisant concurrence ? (18:00)

Quntus précise que "tous les revenus" allant au proposeur fournit une valeur accessible à tous. Si les mineurs construisaient le bloc directement, ils pourraient aussi accéder à cette valeur.

Le coût de la MEV

Quantifier l'(in)équité économique dans le monde décentralisé

Pouvons-nous vraiment définir la MEV ?

Il y a eu de nombreux exposés discutant des aspects qualitatifs et quantitatifs de la MEV, mais cet exposé adoptera une approche plus formelle.

Il y a un défi à définir correctement le MEV puisque de nombreuses définitions et formalismes différents ont été proposés, chacun avec son propre ensemble d'hypothèses et de résultats, ce qui rend difficile la comparaison ou la compréhension commune.

Que voulons-nous vraiment ? (1:40)

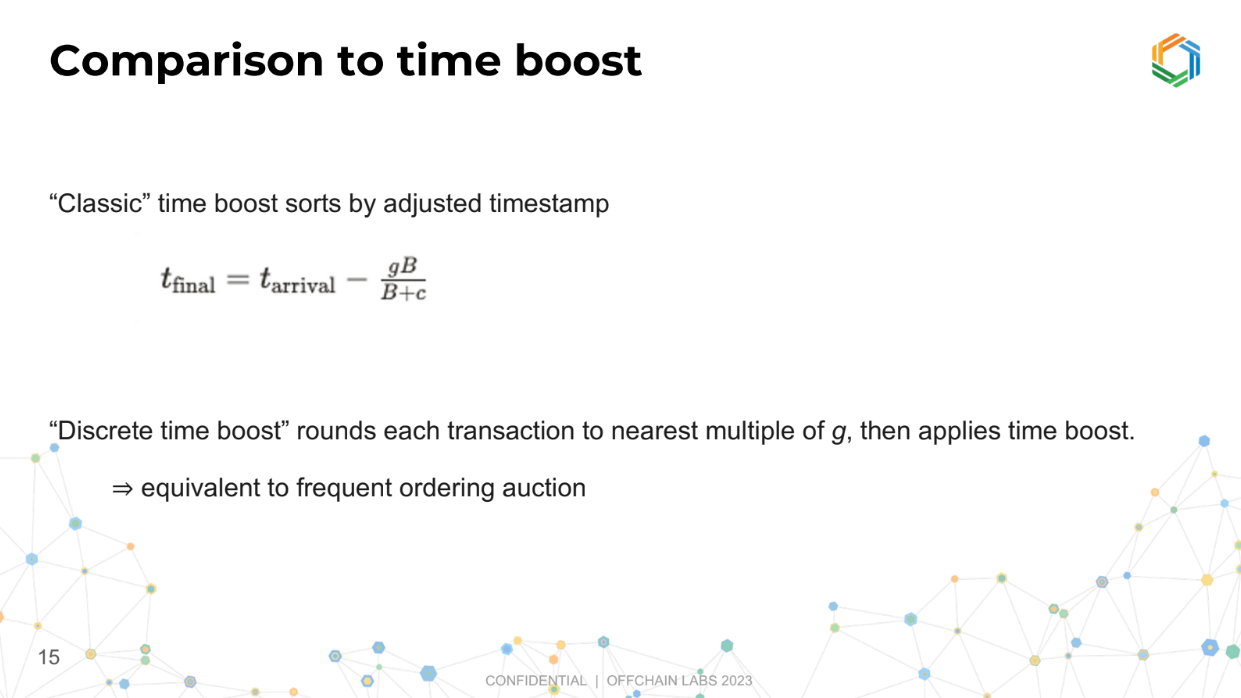

Certaines méthodes de classement équitables (comme FCFS - Premier arrivé, premier servi) n'ont pas été à la hauteur des attentes. Tarun mentionne également vouloir explorer et comparer de nouveaux concepts comme Suave et Time Boost de manière rigoureuse.

Une question clé est de savoir à quel point un ensemble de classements est "plus équitable" qu'un autre en termes de paiements effectués aux validateurs. Nous définissons "équitable" comme signifiant que le pire paiement de validateur n'est pas trop éloigné du paiement moyen.

L'exposé vise à explorer l'équité entre différents mécanismes de classement, en particulier en termes de paiements aux validateurs.

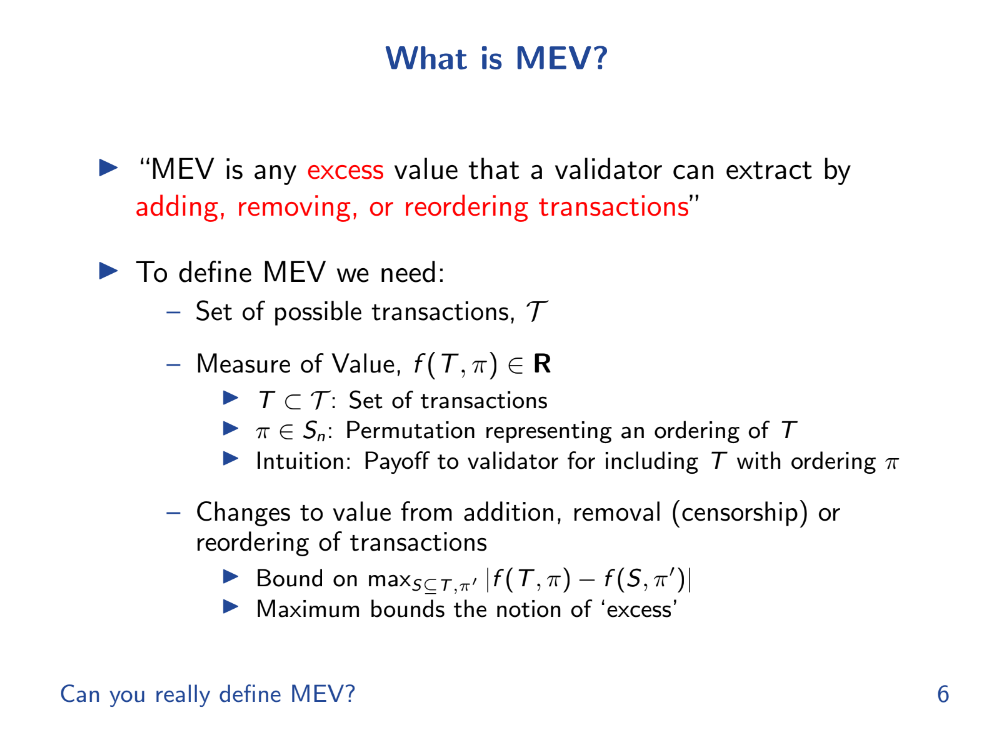

Qu'est-ce que la MEV (formellement) ? (2:50)

Le MEV est toute valeur excédentaire qu'un validateur peut extraire en ajoutant, supprimant ou réorganisant des transactions.

Pour décrire un cadre mathématique formel pour définir et analyser concrètement le MEV, 4 choses sont nécessaires :

- Un ensemble de transactions possibles nommé T

- Une fonction de gain f qui assigne une valeur à un sous-ensemble de transactions T et à un ordonnancement π. Cela représente le gain pour les validateurs.

- Analyser comment f change sur T et π pour définir le "excès" MEV.

- Des moyens d'ajouter, supprimer ou réorganiser des transactions que les validateurs peuvent exploiter.

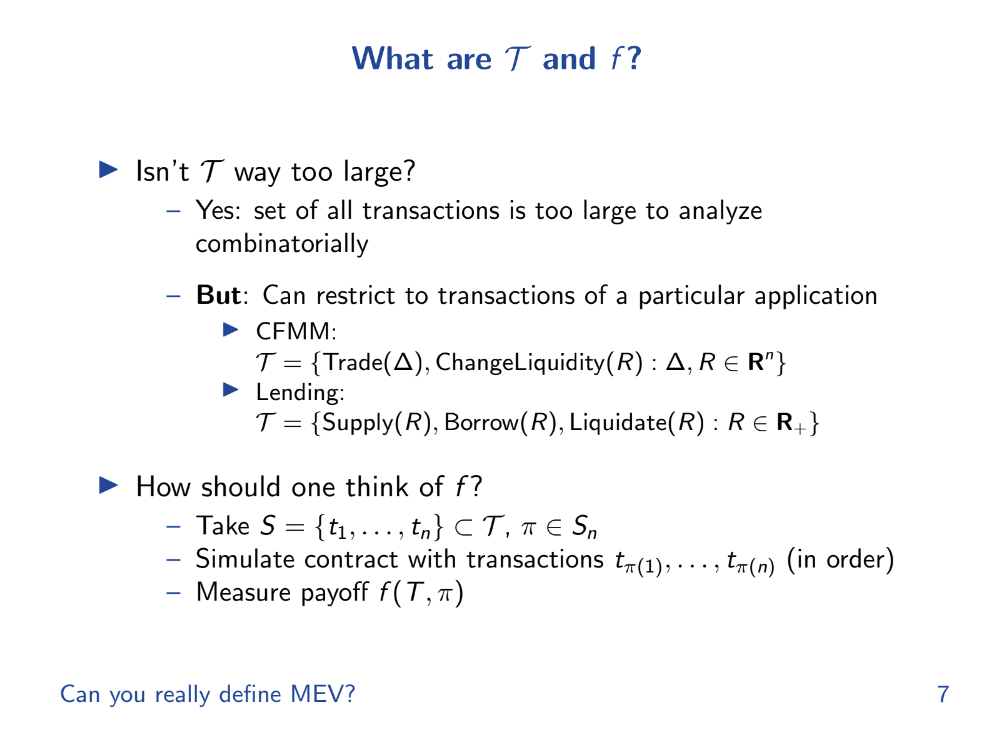

T pourrait être extrêmement grand, rendant l'analyse difficile. Mais pour des cas d'utilisation spécifiques, T peut être restreint pour rendre l'analyse faisable.

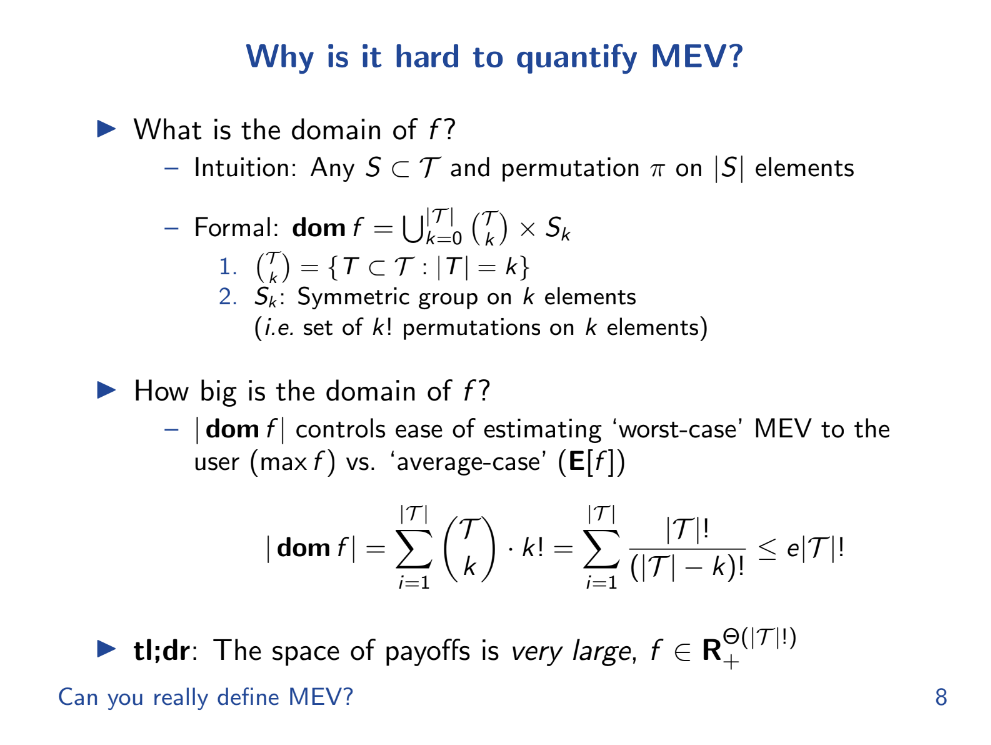

Pourquoi est-il difficile de quantifier la MEV ? (5:40)

Plusieurs raisons pour lesquelles il est difficile de quantifier la MEV :

- Espace de transaction très vaste. La MEV dépend de l'ensemble de toutes les transactions possibles (T) qui pourraient être incluses dans un bloc. Cet ensemble est extrêmement vaste, d'autant plus que le nombre d'utilisateurs de blockchain augmente. Quantifier la MEV nécessite d'examiner tous les sous-ensembles possibles et les ordonnancements de T.

- Évaluation complexe. La MEV dépend également de la fonction d'évaluation (gain) f qui attribue une valeur à chaque sous-ensemble de transactions et ordonnancement. Cette fonction peut être très complexe et déterminée par les conditions du marché. Il est difficile de la modéliser précisément.

- Informations privées. Les validateurs disposent d'informations privées sur les transactions en attente et l'évaluation de l'ordre des transactions auxquelles les observateurs externes n'ont pas accès.

- Conditions changeantes. f dépend des conditions de marché dynamiques. L'évaluation des transactions change constamment au fur et à mesure de l'évolution des conditions du marché. Autrement dit, nous devons quantifier une cible mouvante.

- Nouveaux types de transactions. À mesure que de nouveaux smart contracts et types de transactions sont introduits, cela étend l'espace de transaction et complique l'évaluation

Équité

Nous utilisons le terme "gain" (payoff) pour représenter le bénéfice ou le résultat que quelqu'un obtient d'un certain arrangement (comme l'ordre des transactions).

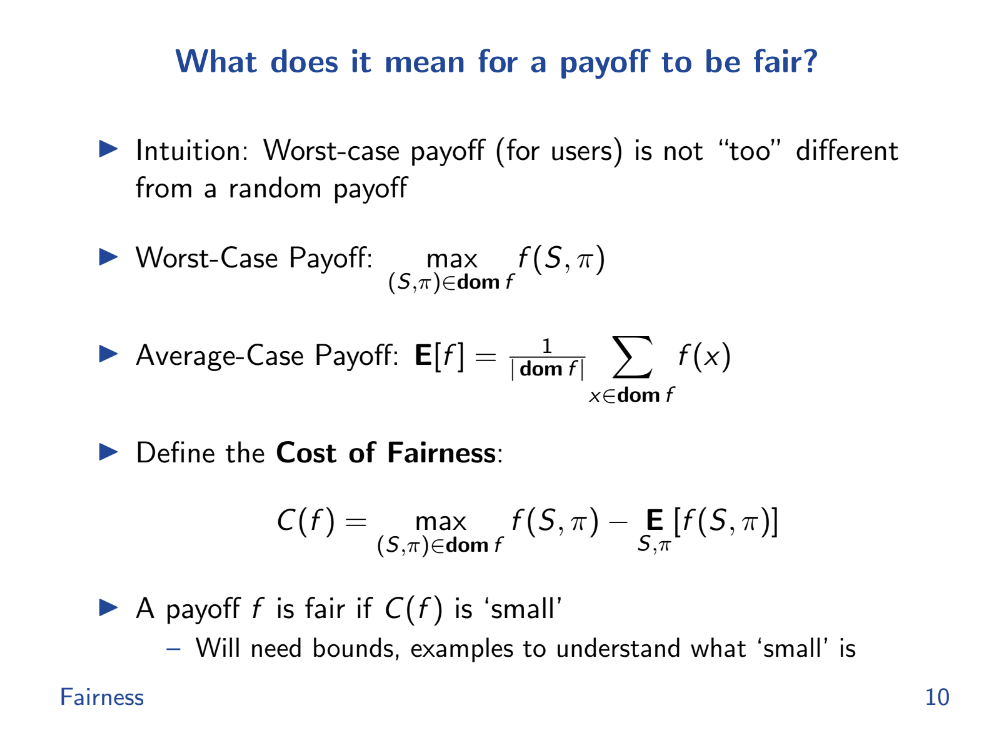

Que signifie qu'un gain soit équitable ? (6:40)

Selon Tarun, l'"équité" est lorsque le pire cas de gain n'est pas trop éloigné du gain aléatoire moyen. Cela représente l'incapacité d'un validateur à censurer ou réorganiser des transactions.

- Pire cas de gain : Imaginons que quelqu'un triche et arrange le paquet à son avantage ; ce scénario lui donne le gain le plus élevé possible. C'est le mieux qu'il puisse faire en trichant.

- Cas moyen : C'est ce qui se produit généralement lorsque personne ne triche ; c'est le résultat moyen sur de nombreuses occurrences

- Coût de l'équité : C'est comme une mesure de ce que quelqu'un peut gagner en trichant. C'est la différence entre les gains du pire cas et du cas moyen.

Une situation est plus "équitable" si ce coût de d'équité est faible, ce qui signifie qu'il y a peu à gagner en trichant.

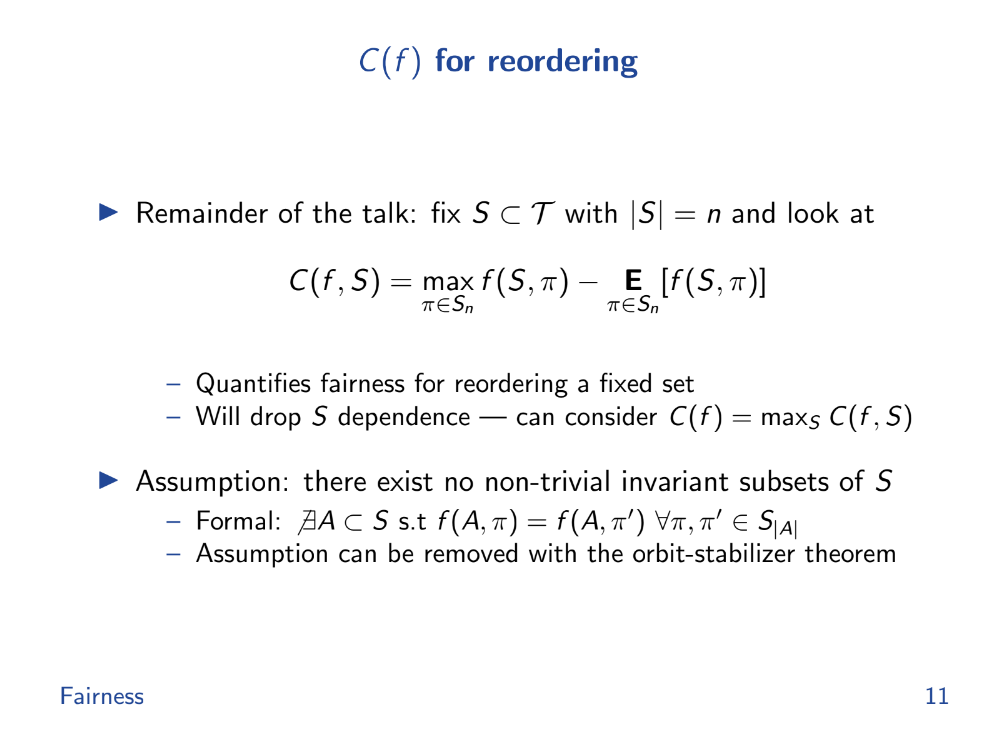

Coût d'équité pour le réordonnancement (7:50)

Nous voulons quantifier combien ils peuvent extraire en plus. Les hypothèses sont les suivantes :

- Ensemble fixe de transactions possibles

- Se concentrer uniquement sur le réordonnancement pour l'instant

- Pas de sous-groupes de permutation qui laissent le gain invariant

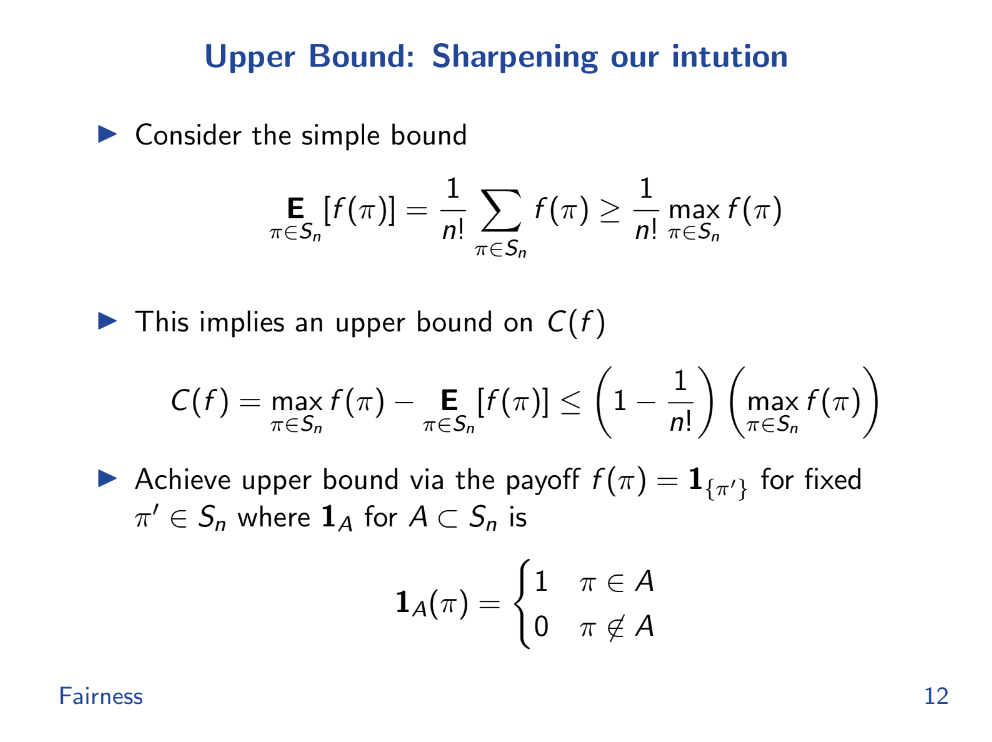

Borne supérieure (8:45)

Avec ces hypothèses :

- L'injustice maximale possible se produit lorsque le gain est de 1 pour un ordre, 0 pour tous les autres.

- En général, l'injustice est limitée par :

(Gain maximal - Gain moyen) < Gain maximal * (1 - 1/n!)

où n est le nombre de transactions.

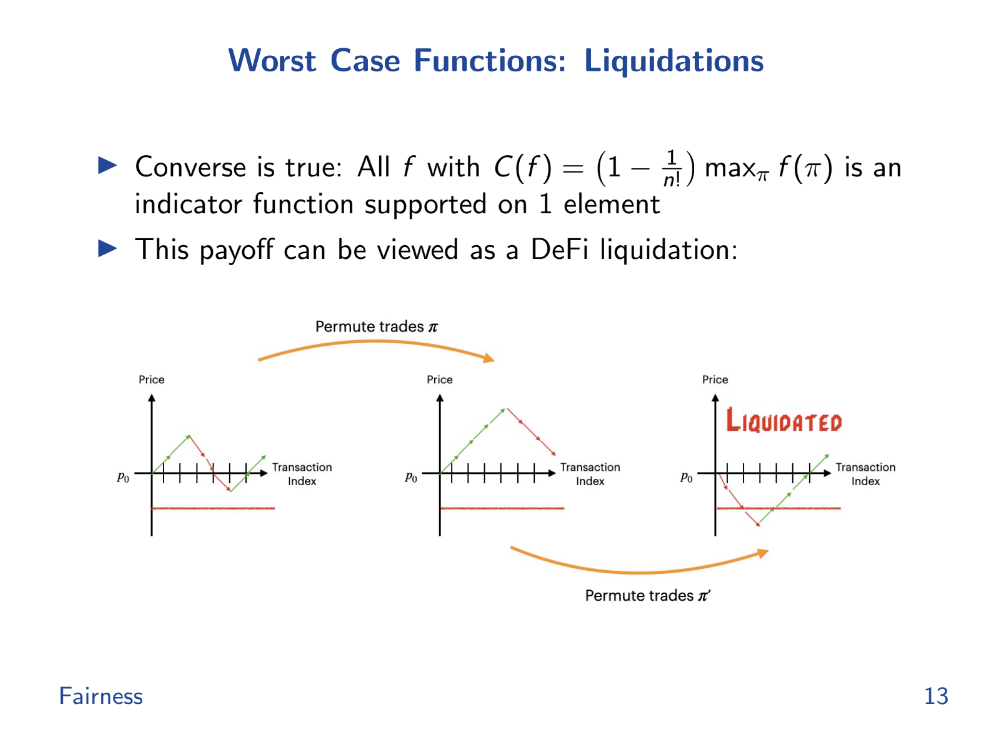

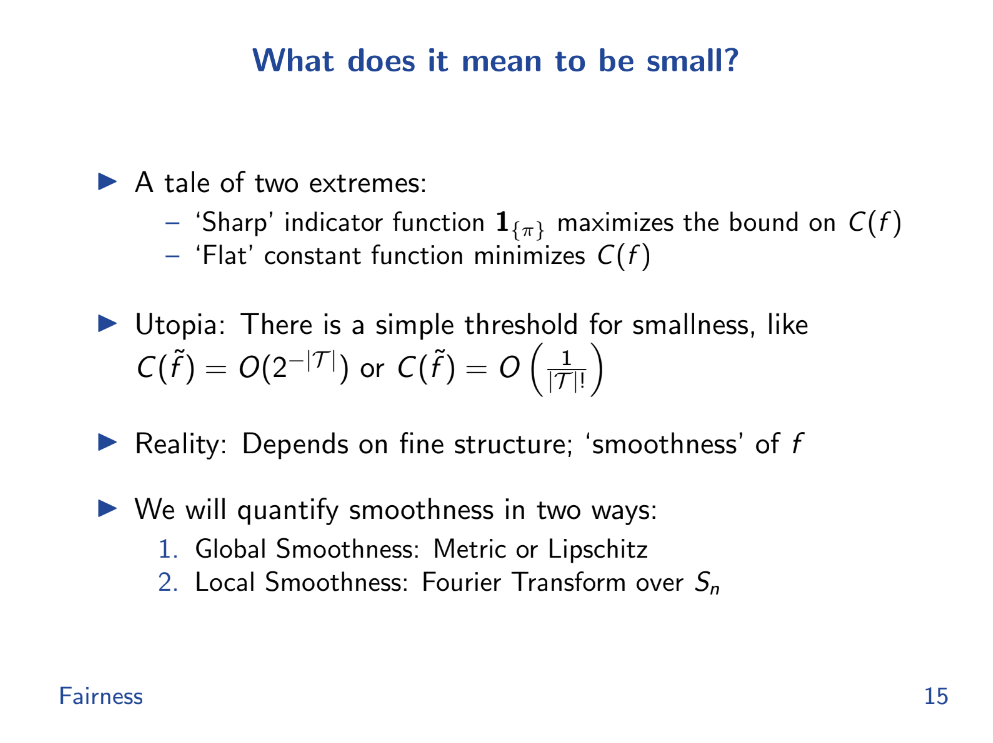

Fonctions du pire cas (9:30)

Les liquidations DeFi représentent une sorte d'ensemble de base de fonctions de gain qui génèrent des coûts d'équité élevés.

L'ordre dans lequel vous exécutez ces échanges peut affecter si vous perdez beaucoup d'argent en une fois (être liquidé) ou non. Différents ordres ou "permutations" d'échanges ont des résultats différents, et certains peuvent atteindre un point où vous êtes liquidé, tandis que d'autres non.

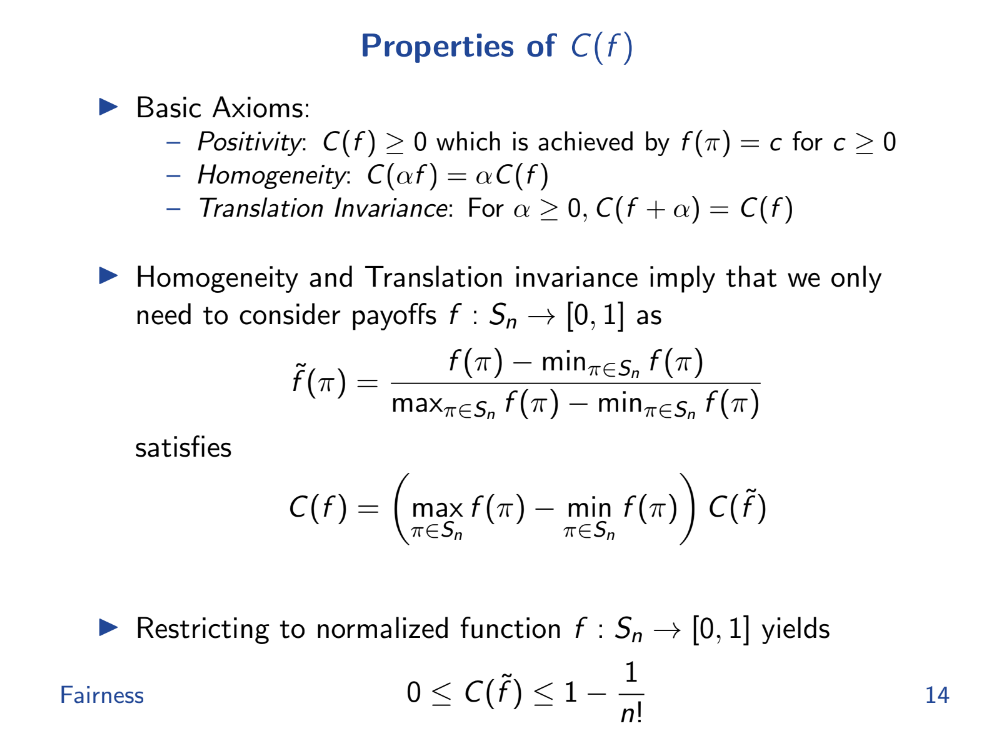

Propriétés du coût d'équité (10:25)

- L'équité est définie comme la différence entre les gains du pire cas et du cas moyen.

- Parfaitement équitable signifie le même gain pour n'importe quel ordre.

- Parfaitement inéquitable signifie un gain uniquement pour un ordre.

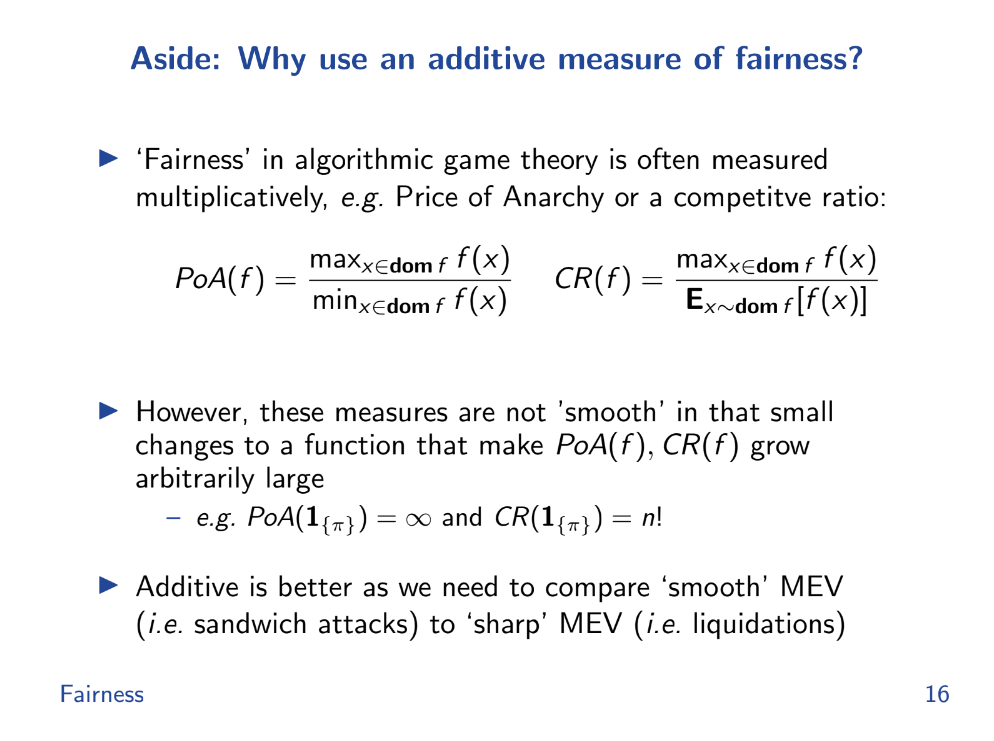

Pourquoi utiliser une mesure additive d'équité ? (12:20)

Le problème est que les mesures de ratio comme max/min ou max/moyenne peuvent devenir exagérées ou non bornées pour des fonctions de gain extrêmes comme les liquidations. Nous avons donc besoin de mesures additives d'équité qui quantifient la variation du gain entre les différents ordonnancements.

Additif signifie différence entre max et moyenne. En utilisant une mesure additive, il est plus facile d'analyser et de comprendre les variations de gain et donc le niveau d'équité dans le système, ce qui en fait une méthode plus fiable dans de tels contextes.

Fonctions lisses

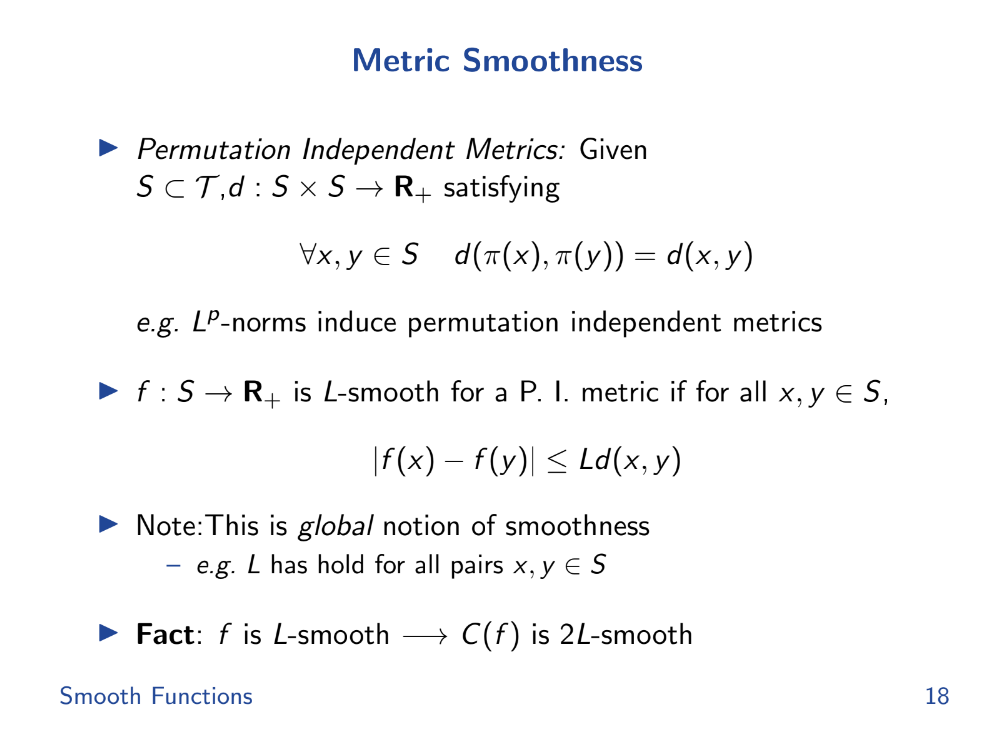

Lissage métrique (13:20)

En calcul, il existe un concept appelé lissage de Lipschitz qui aide à mesurer cette prévisibilité. Si une fonction est lisse de Lipschitz, la variation de sa valeur est limitée, la rendant plus prévisible.

Nous pouvons définir des métriques de "lissage" similaires pour les AMM basées sur la variation de leurs prix en réponse aux échanges.

Exemples (14:15)

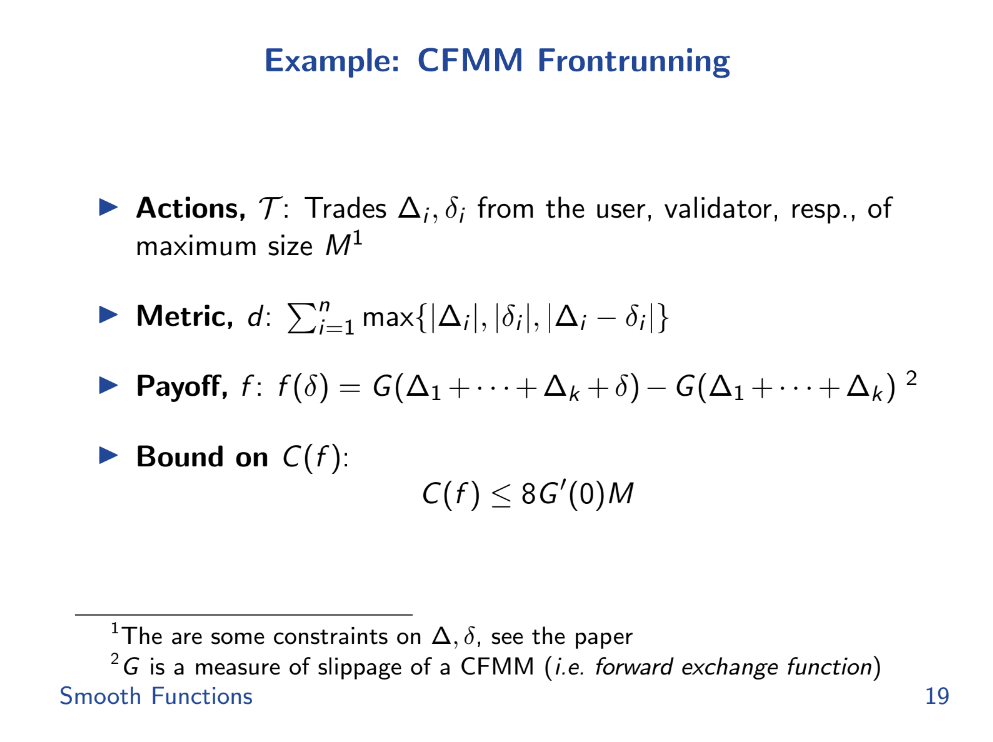

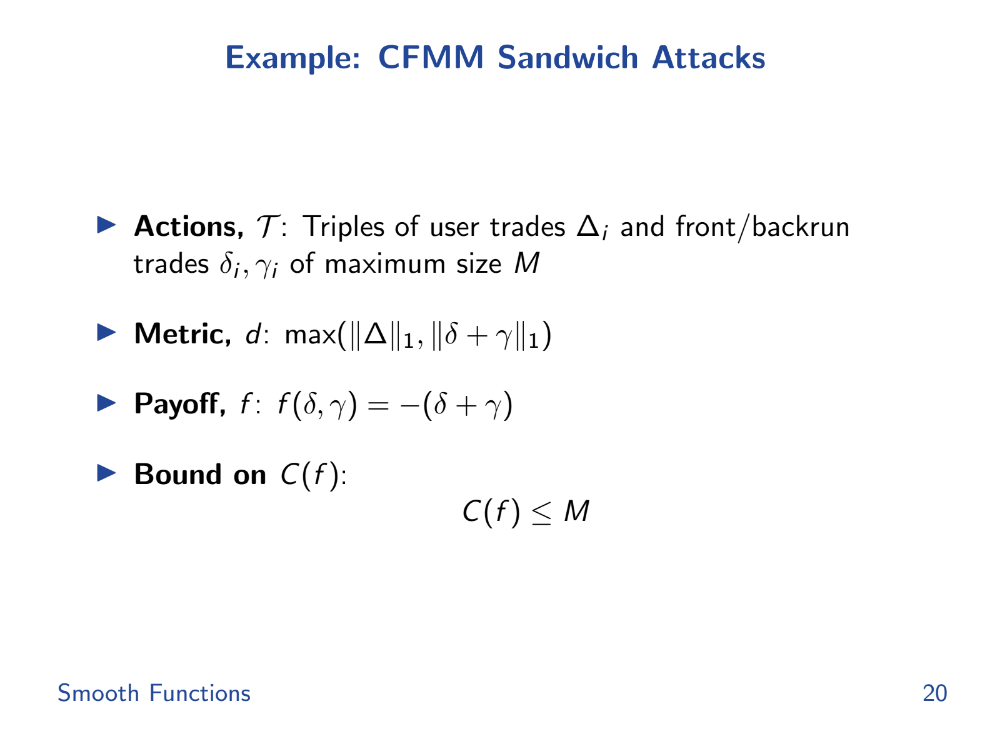

Intuitivement, un AMM avec des variations de prix plus lisses (gradient plus faible) devrait être moins vulnérable aux attaques comme le front-running qui exploitent les fluctuations rapides des prix. Nous pouvons mathématiquement borner supérieurement l'injustice ou la manipulation potentielle dans un AMM par sa métrique de lissage

Pour le front-running, la fonction de tarification lisse de l'AMM contrôle directement l'écart d'équité max-min. Mais, fait surprenant, les attaques sandwich ont en fait de meilleures limites (plus basses) que le pire des cas de front-running dans certains AMM comme Uniswap.

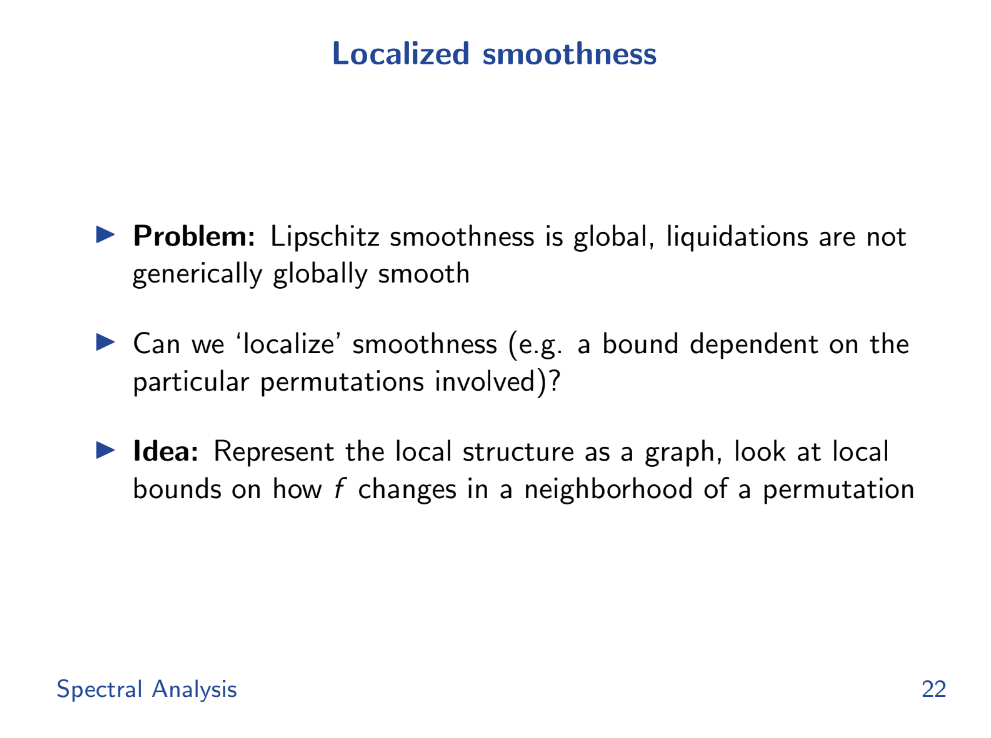

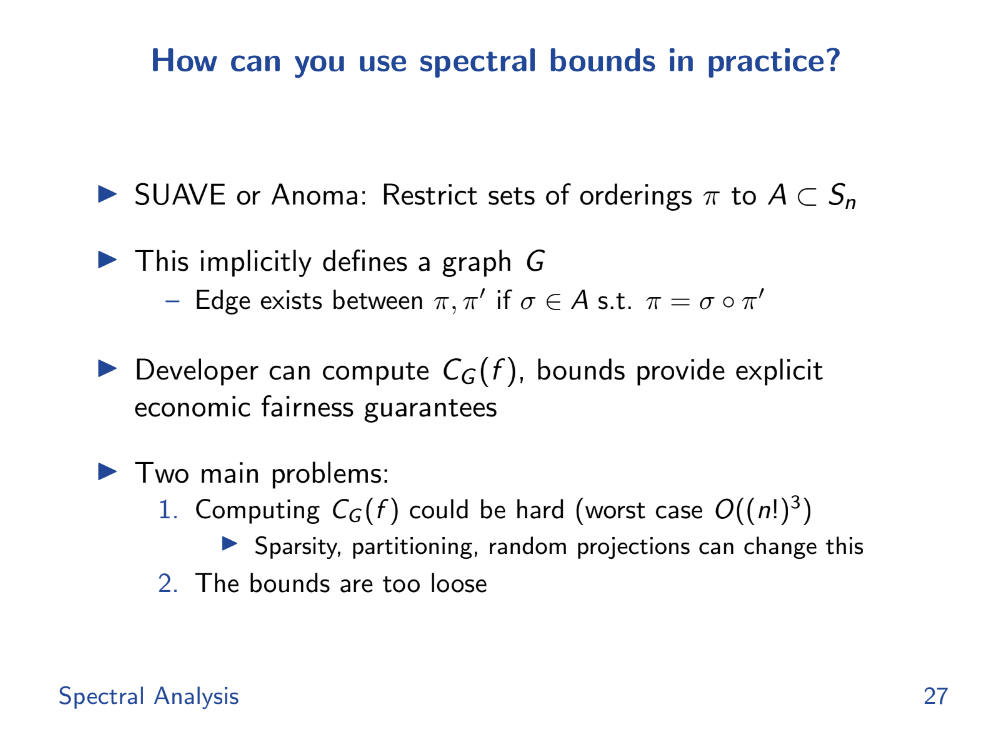

Analyse Spectrale

Lissage localisé (15:35)

Nous passerons des métriques de "lissage" globales à des métriques plus locales. Les métriques globales comparent tous les ordonnancements possibles de transactions, mais les métriques locales ne regardent que les petits changements.

Cela importe car dans les systèmes réels comme les blockchains ou les canaux d'état, vous ne vous souciez souvent que de l'équité locale - comme la comparaison entre deux transactions, pas toutes les transactions globalement.

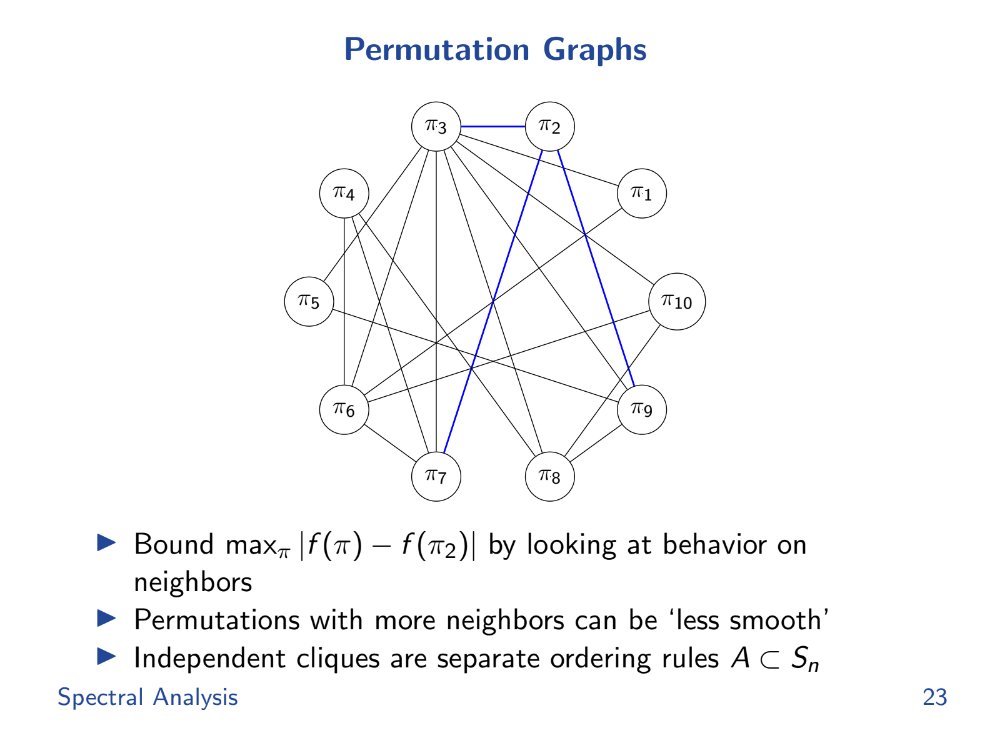

Graphes de permutation (16:30)

Pour aider à étudier ce lissage local, Tarun introduit un domaine des mathématiques appelé théorie spectrale des graphes. Il envisage les ordonnancements de transactions valides comme un graphe, avec des arêtes pour les transitions autorisées entre les ordonnancements.

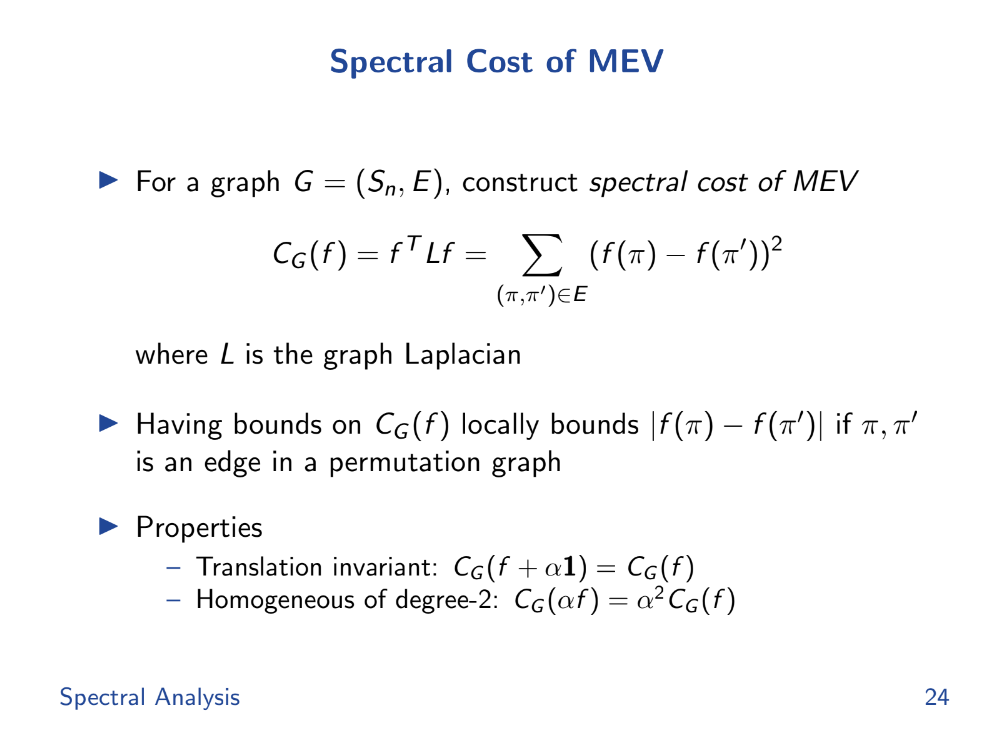

Coût spectral de la MEV (17:20)

Il définit un "coût spectral du MEV" comme la différence de gain entre les nœuds connectés. Cela mesure le lissage local, pas toutes les alternatives globalement.

Tarun introduit une fonction Cg et utilise des outils mathématiques comme les valeurs propres et la transformation de Fourier pour analyser et borner l'écart de résultats.

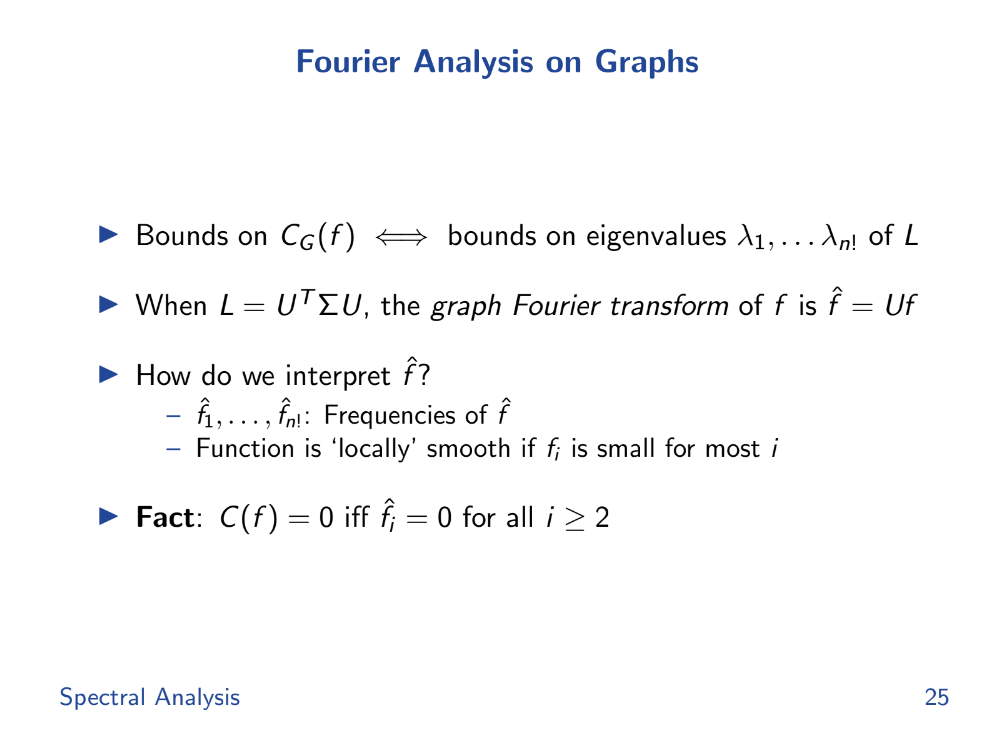

Ces outils aident à mesurer la "régularité" ou la prévisibilité du système avec différents ordonnancements.

Analyse de Fourier (17:50)

Si les coefficients de Fourier à haute fréquence sont nuls, la fonction de gain est constante, donc parfaitement lisse et équitable. La moyenne spectrale des valeurs propres borne le coût d'iniquité.

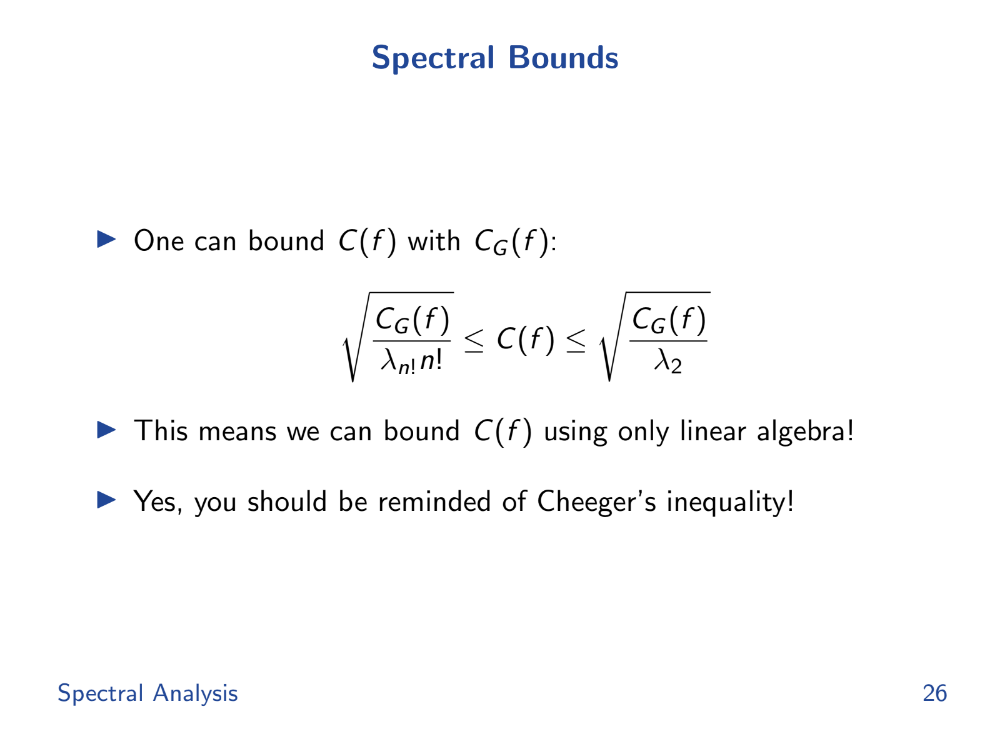

Bornes spectrales (18:30)

Les bornes spectrales, dérivées des valeurs propres, aident à borner le coût local. En bornant le coût local, elles peuvent garantir que l'écart de résultats reste dans des limites acceptables, assurant ainsi l'équité.

Donc, si nous pouvons analyser le spectre du Laplacien du graphe L, nous pouvons borner les différences de gains entre les ordonnancements locaux. Cela fournit un "certificat d'équité".

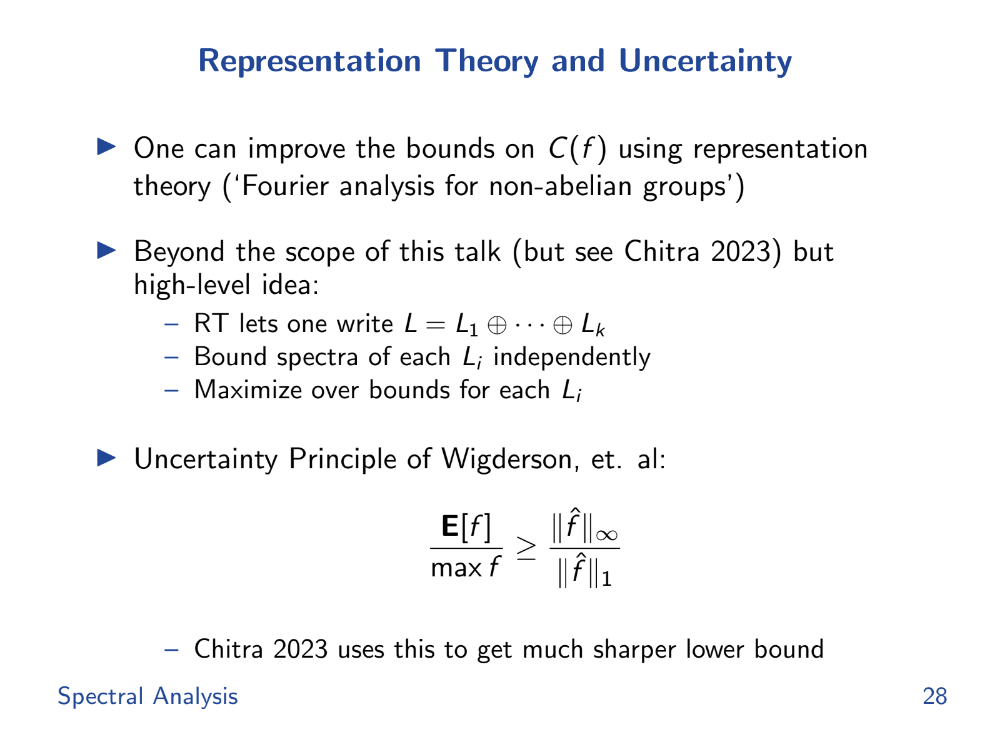

Théorie de la représentation et incertitude (20:00)

Il reste encore des défis :

- Le graphe peut être énorme, rendant l'analyse des valeurs propres coûteuse. Mais il existe des raccourcis pour les graphes clairsemés.

- Les limites sont lâches. Mais il existe des moyens de décomposer L et de resserrer les limites.

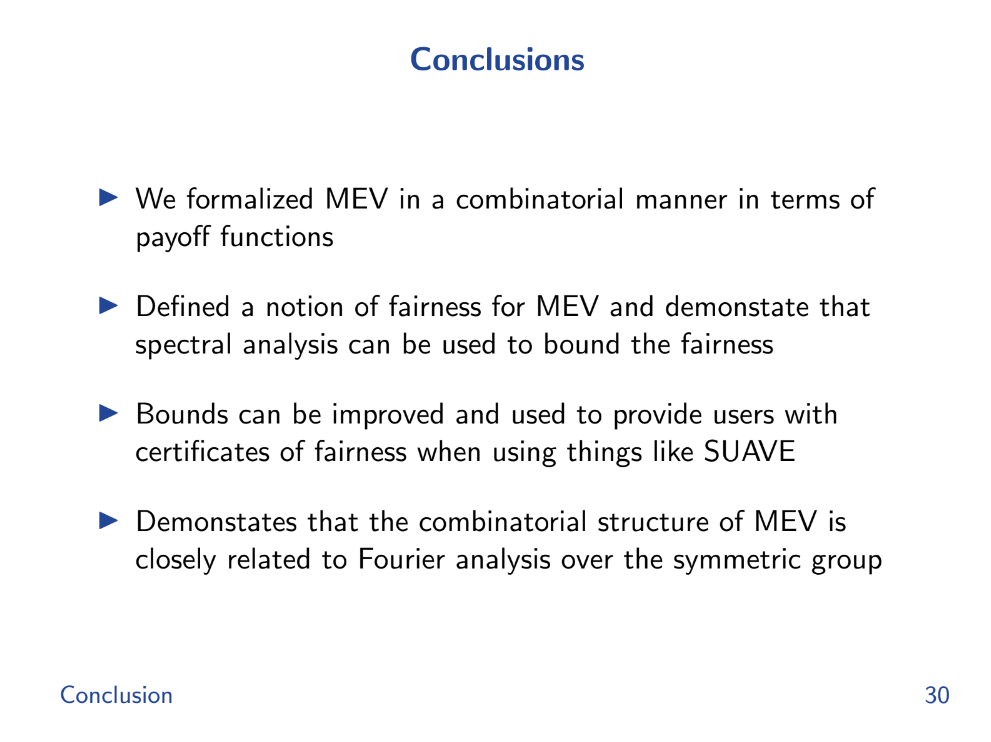

Conclusion (20:20)

On a formalisé la MEV en utilisant la combinatoire plutôt que des programmes. Cela rend l'analyse plus propre.

On définit l'"équité" comme la différence entre les gains du pire cas et du cas moyen sur les ordonnancements de transactions.

On a montré comment les bornes de la théorie spectrale des graphes peuvent limiter la régularité des fonctions de gain. Cela aide à borner l'injustice maximale.

Donc, en faisant un peu d'algèbre linéaire sur le graphe des ordonnancements valides, on peut obtenir des "certificats d'équité" pour des protocoles comme Suave ou Anoma.

L'analyse de Fourier sur le groupe symétrique des ordonnancements est importante pour cette analyse graphique.

Q&A

Dans l'écosystème DeFi d'Ethereum, les liquidations sont une grande source de MEV. Mais de nombreuses applications DeFi utilisent maintenant Chainlink pour les flux de prix, évitant la manipulation des prix sur la chaîne. Alors, en pratique, combien de MEV provenant des liquidations existe-t-il encore ? (21:20)

L'extraction de MEV peut être modélisée mathématiquement pour n'importe quel schéma d'ordonnancement de transactions. Nous pouvons représenter n'importe quel schéma de paiement (comme une enchère ou une plateforme de prêt) comme une "base de liquidation".

Même si les applications utilisent Chainlink pour éviter la manipulation directe, l'ordre des transactions peut encore avoir un impact sur les bénéfices.

Des mécanismes comme PBS ou PEPC peuvent-ils restreindre l'ensemble des ordonnancements de transactions valides, réduisant ainsi le MEV ? (22:45)

Tarun n'est pas sûr si c'est le cas pour PBS, mais il est d'accord. Des solutions comme Anoma et SUAVE restreignent l'ordonnancement des transactions, ce qui aide à borner/réduire le MEV.

La clé est d'analyser formellement la mesure dans laquelle une contrainte donnée améliore l'"équité" en restreignant les ordonnancements.

Pourriez-vous utiliser cette analyse MEV pour définir des limites sur une enchère néerlandaise, comme alternative aux enchères par lots d'ordres ? (24:00)

Oui, les enchères néerlandaises pourraient potentiellement être modélisées pour limiter l'exposition au MEV. L'idée de base est de représenter les schémas de paiement pour raisonner sur les effets de l'ordonnancement des transactions.

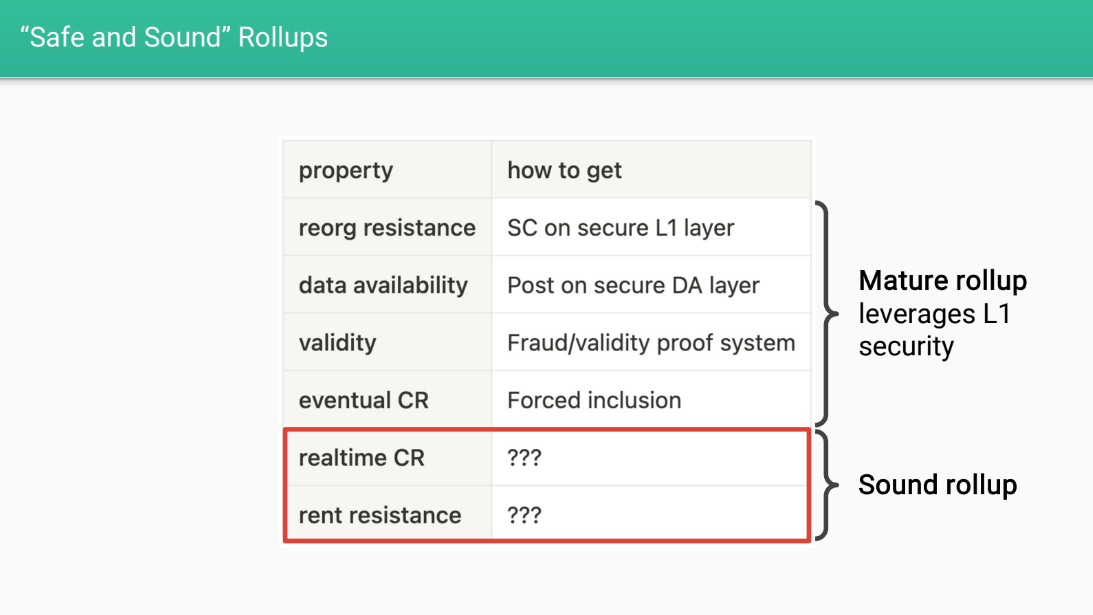

Propriétés des rollups matures et solides

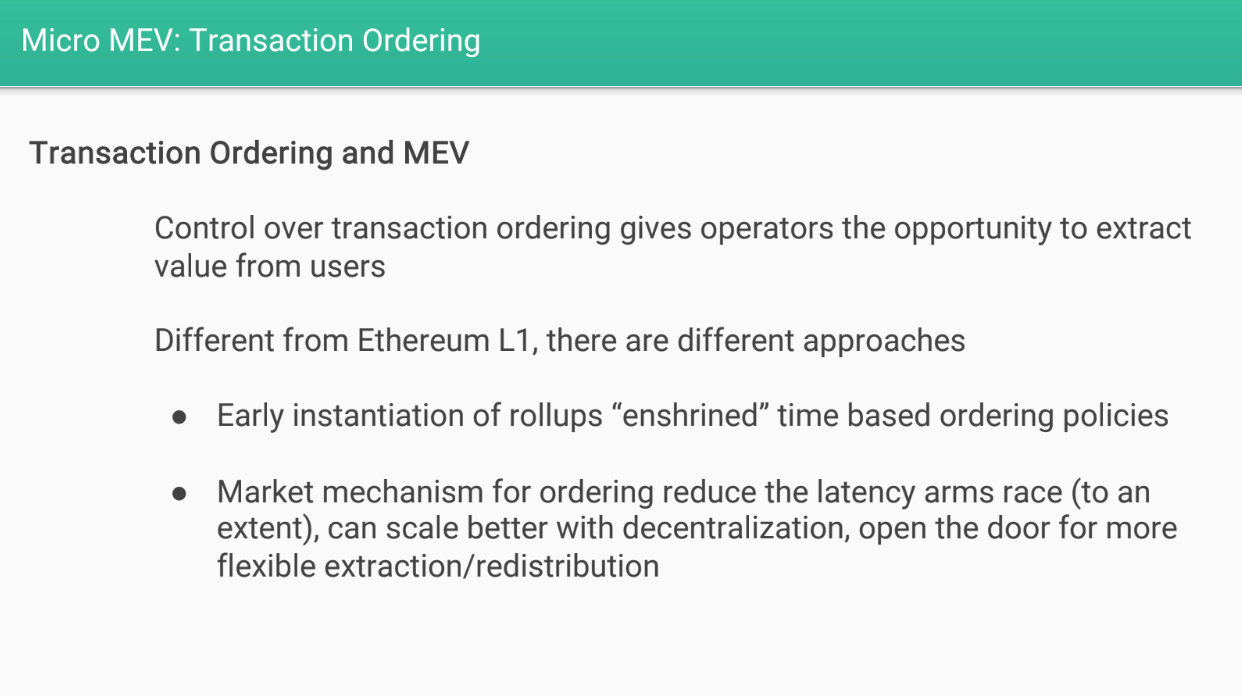

Il existe deux types de MEV possibles sur le Layer 2 :

- La macro MEV, où l'opérateur de rollup pourrait retarder ou censurer des transactions pour en tirer profit.

- La micro MEV, où les validateurs extraient des frais inutiles des transactions comme sur le Layer 1.

Rollups sûrs et solides (1:00)

Davide veut que les rollups aient certaines propriétés pour les rendre "sûrs et solides".

Premièrement, les rollups devraient avoir des propriétés de sécurité héritées du Layer 1 d'Ethereum :

- Résistance aux réorganisations : les transactions ne peuvent pas être inversées

- Disponibilité des données : les données de transaction sont disponibles

- Validité : les transactions suivent les règles du protocole

- Résistance à la censure éventuelle : les transactions seront finalement confirmées

Ils devraient également avoir des propriétés d'équité économique décrites ci-dessous.

Propriétés idéales (2:25)

- Résistance à la censure en temps réel : les transactions sont confirmées rapidement sans retard

- Résistance à la rente : les utilisateurs ne paient que les frais minimum nécessaires au fonctionnement, aucune rente inutile n'est extraite

Avec une résistance à la censure en temps réel et une résistance à la rente, le rollup serait plus équitable pour les utilisateurs.

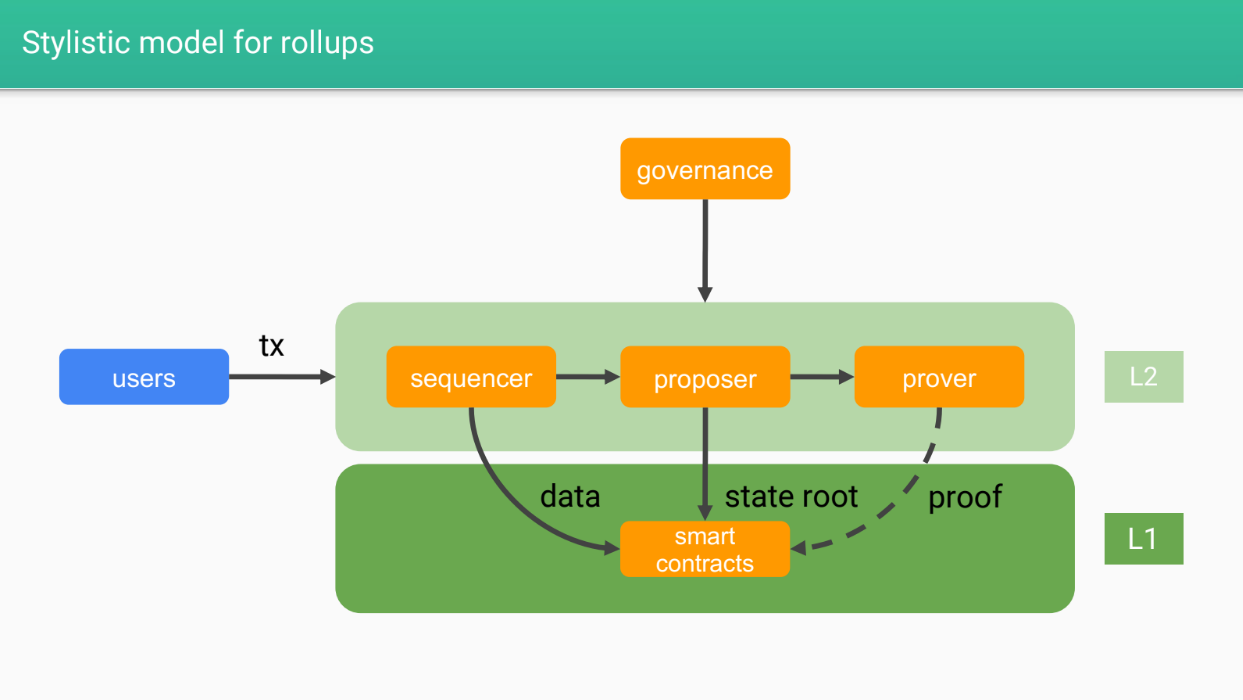

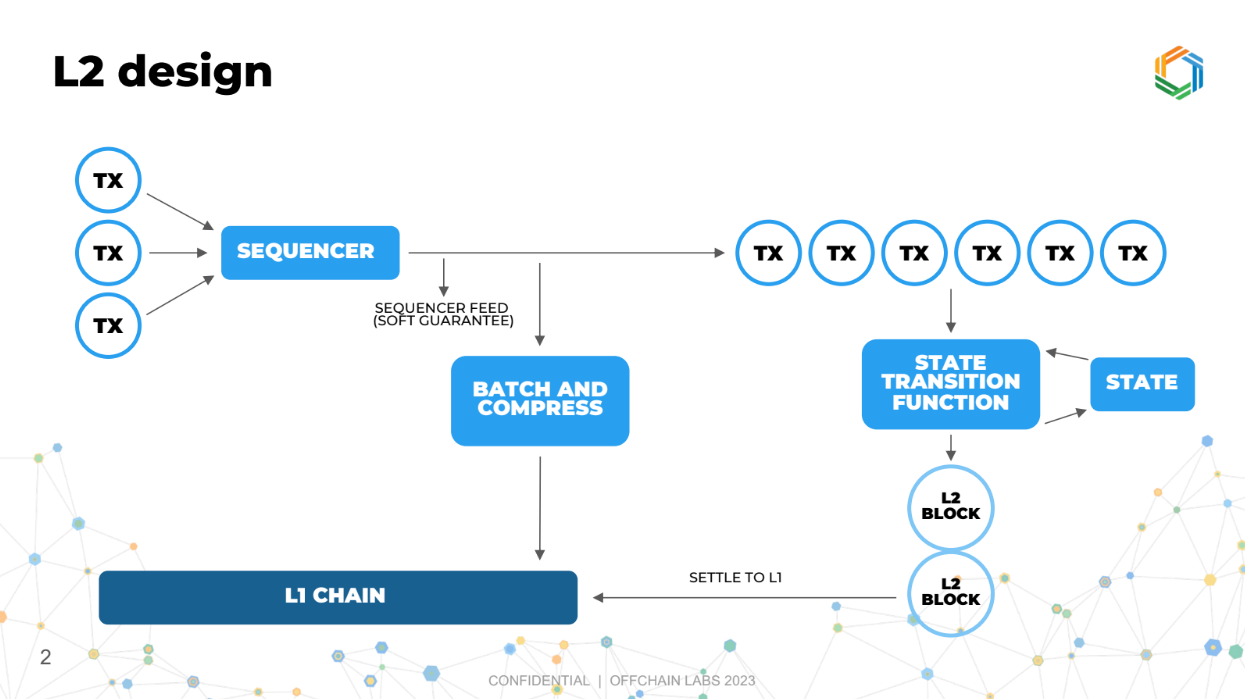

Modèle stylistique pour les rollups (3:05)

- Séquenceurs : chargés de commander les transactions en blocs/lots et de les publier sur le Layer 1 (L1)

- Proposeurs : exécutent les transactions et mettent à jour l'état sur le L1

- Prouveurs : vérifient la validité des transitions d'état (obligatoire pour les validity rollups)

- Smart contracts : la logique de rollup sur le L1

- Gouvernance : conçoit et met à niveau le système de rollup

- Utilisateurs : interagissent avec le rollup, sécurisés par le L1

Les différents rôles dans le système de rollup seront liés au potentiel de "macro mev" et de "micro mev" qui seront discutés ensuite.

Types de MEV sur les L2

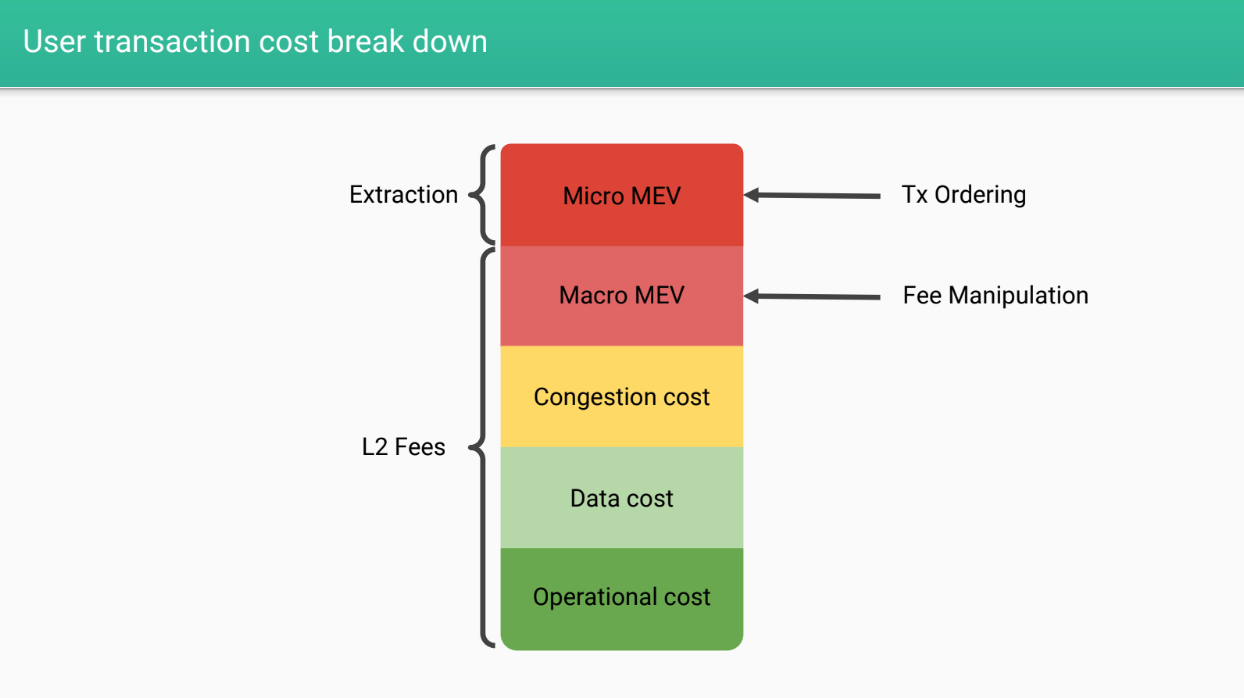

Décomposition des coûts de transaction (4:30)

Lorsqu'un utilisateur envoie une transaction sur un rollup, il paie :

- Des frais de L2 pour les coûts de fonctionnement

- Des coûts de données pour la publication des données sur le L1

- Des frais de congestion pour une allocation efficace des ressources

- Potentiel "macro MEV" : frais extraits par l'opérateur

- Potentiel "micro MEV" : extraction réalisée par l'ordonnancement des transactions

Micro MEV (6:05)

La micro MEV est l'extraction réalisée par l'ordonnancement des transactions, comme sur le L1.

Dans cet exposé, nous nous concentrerons donc sur la macro MEV par l'opérateur.

Macro MEV

Il existe 3 formes principales de macro MEV :

- Manipulation indirecte des frais : Augmenter ou diminuer le volume des transactions pour manipuler les frais

- Manipulation directe des frais : L'opérateur définit directement des frais élevés

- Retarder les transactions : L'opérateur retarde les transactions pour en tirer profit

Manipulation indirecte des frais (7:40)

N'importe qui peut manipuler les frais en augmentant/diminuant le volume de transactions. Mais nous ne pouvons pas définir précisément qui est responsable de ce type de manipulation.